超越序列到序列:增强型RNN在人工智能中的应用

下载需积分: 10 | PDF格式 | 3.29MB |

更新于2024-07-20

| 48 浏览量 | 举报

"Edward Grefenstette的演讲——超越序列到序列:增强型RNN的应用"

在本次演讲中,Edward Grefenstette探讨了如何通过增强型循环神经网络(Augmented RNNs)突破传统的序列到序列模型的限制,以实现更广泛的人工智能应用。以下是演讲的主要内容:

1. **转换瓶颈**:

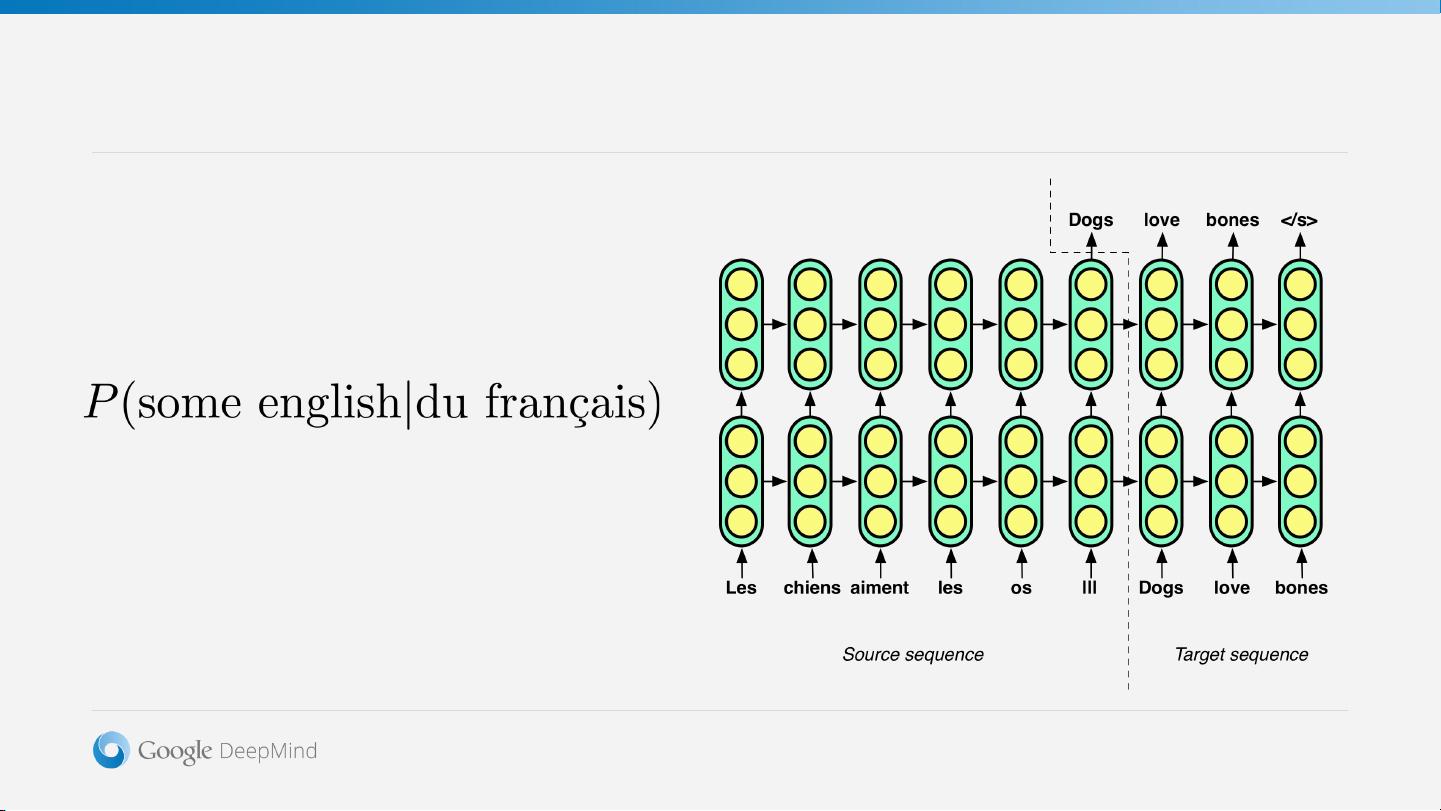

序列到序列模型在处理诸如机器翻译、语音识别等任务时表现出色,但它们通常受限于单一的输入和输出序列。这种“转换瓶颈”限制了模型处理更复杂任务的能力。

2. **RNNs的局限性**:

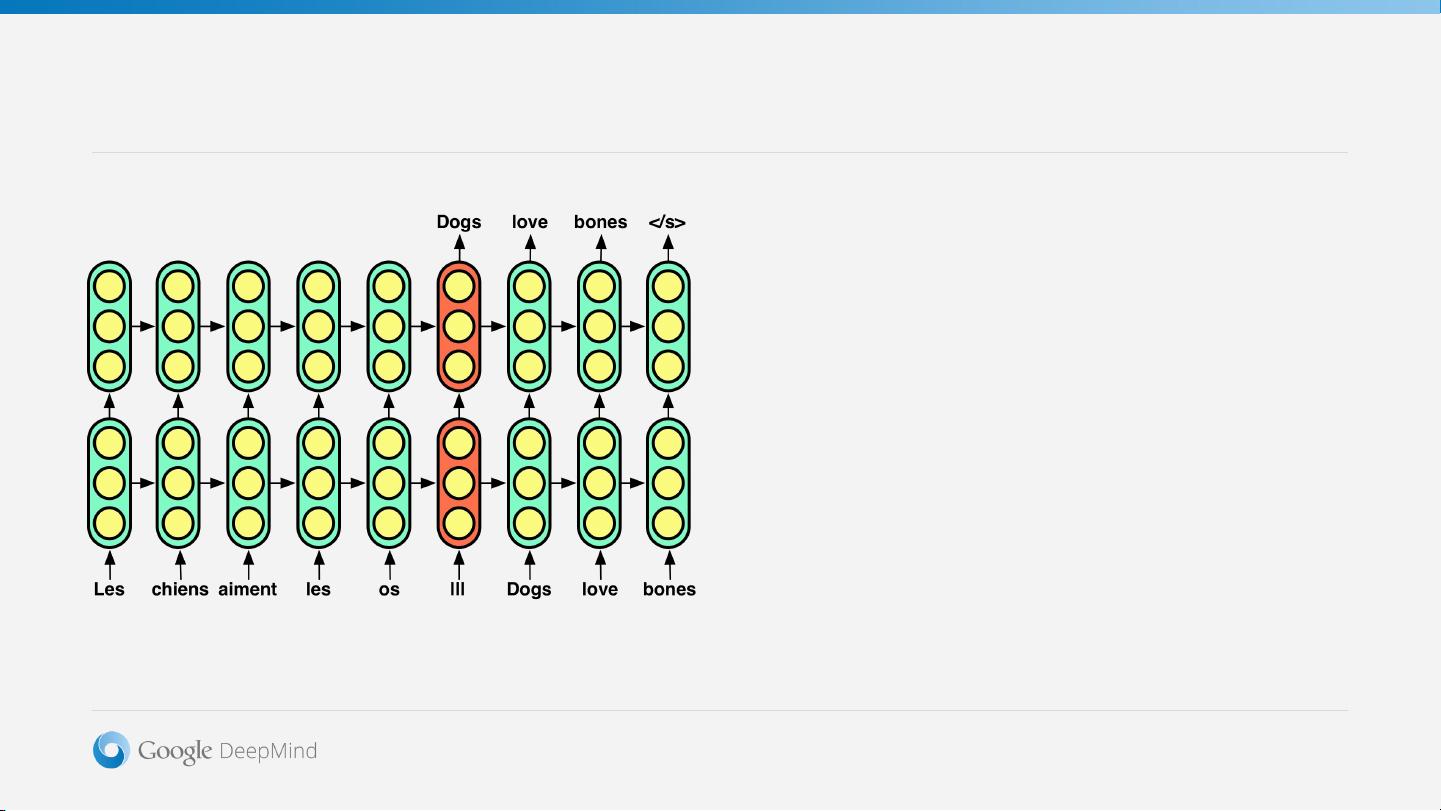

循环神经网络(RNNs)的核心是其循环隐藏层,它能够捕获序列的历史信息。然而,RNNs在处理长距离依赖时可能遇到困难,即著名的“梯度消失”或“梯度爆炸”问题,这限制了它们的学习能力。

3. **RNNs的重新审视**:

尽管RNNs在处理变宽度问题时表现出色,可以展开成具有共享权重的前馈网络,但它们的结构仍然不足以应对所有挑战。

4. **注意力机制**:

为了解决RNNs的问题,引入了注意力机制,允许模型在解码阶段根据需要动态地关注输入序列的不同部分,增强了模型处理长序列的能力。

5. **堆栈**:

基于栈的结构可以模拟LSTM或GRU单元的门控机制,提供更灵活的记忆管理,模拟人类处理问题时的层次性和上下文切换。

6. **寄存器机**:

寄存器机是另一种增强RNN的方法,它可以模拟计算机的内存操作,使模型能够存储和检索信息,从而更好地解决复杂任务。

演讲提到了一些RNN的基础应用,如语言建模、序列标注和句子分类。然而,对于这些任务,存在更简单或更有效的模型。Grefenstette强调,增强型RNNs的目标是扩展至更复杂的任务,如条件转换模型,这涉及到更广泛的输入和输出格式,可能包括多个输入序列和多目标输出。

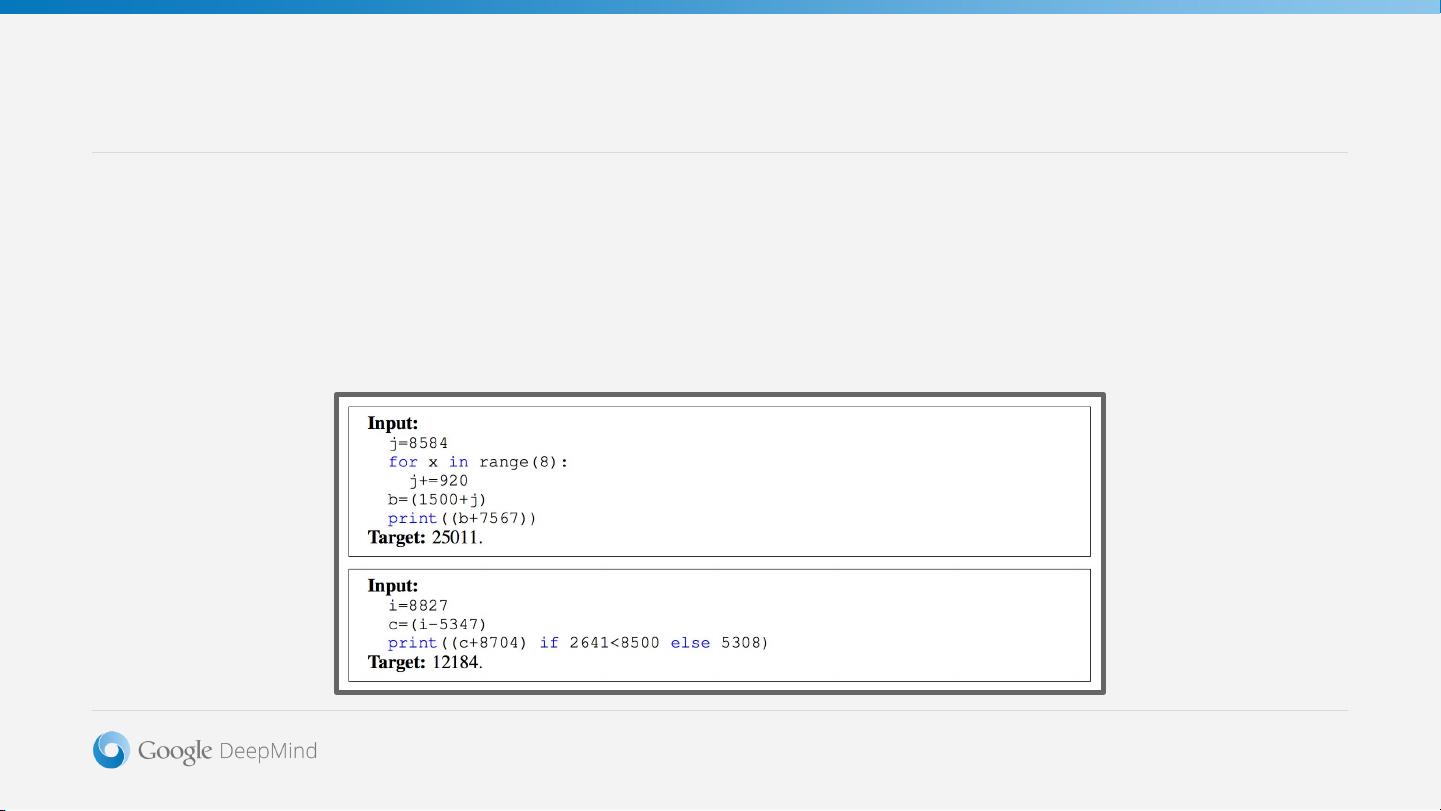

通过引入注意力机制、堆栈和寄存器机等增强技术,RNNs能够超越简单的序列到序列学习,向更全面的人工智能迈进。这些改进有助于模型处理更加多样化和复杂的任务,比如在自然语言处理中生成多句对话、理解和生成代码、甚至是进行更高级的认知任务。

相关推荐

173 浏览量

蓝魅派

- 粉丝: 0

最新资源

- Java图片爬虫程序深入解析:连接数据库实现高效下载

- Panasonic SDFormatter:专业SD卡格式化解决方案

- 官方发布:单片机下载器驱动程序安装与使用指南

- 深入理解Cloud Post - 构建Node.js应用与安全实践

- Android网络检测技术示例:检测不可用WiFi连接

- MSP430F149烧录软件使用与USB-BSL驱动下载指南

- 揭秘网站安全编程:防止xss漏洞的实战技巧

- Java推箱子游戏开发教程及实践

- 使用PHP将Markdown转换为HTML的简易教程

- J2ME推箱子游戏开发:课程设计与移动运行指南

- 邮政编码识别:利用OPENCV技术进行倾斜矫正与字符分隔

- 揭秘无刷电机霍尔传感器与绕组位置对应关系

- OMics患者报告生成与R软件包安装指南

- 使用xmlbeans-2.4.0快速生成JAVA代码的方法

- suit.less:简化 LESS 编写,兼容 Suitcss 样式

- C#连接Access创建密码管理器简易操作指南