Hadoop集群安装配置指南:NameNode与DataNode,JobTracker与TaskTracker解析

需积分: 9 5 浏览量

更新于2024-07-21

收藏 574KB DOCX 举报

"Hadoop安装配置总结,包括集群部署介绍、Hadoop核心组件解析、环境说明及具体安装步骤"

Hadoop的安装配置是一个重要的过程,它涉及到分布式计算平台的基础搭建,以便于有效地处理大规模数据。Hadoop是Apache软件基金会的一个开源项目,其核心组件包括HDFS(Hadoop分布式文件系统)和MapReduce,这两个组件共同构成了Hadoop分布式系统的基础。

HDFS是Hadoop的基石,它是一个高度容错性的分布式文件系统,设计用于在廉价硬件上运行。在Hadoop集群中,NameNode作为主服务器,它维护着文件系统的元数据,包括文件名、文件的块列表和块所在的DataNode。而DataNode是数据的实际存储节点,它们存储数据块并响应来自NameNode和客户端的读写请求。NameNode和DataNode之间的这种主从架构确保了数据的高可用性和可扩展性。

MapReduce则是Hadoop的计算引擎,它基于Google的MapReduce模型实现。JobTracker在主节点上运行,负责作业的调度和监控,将作业拆分为多个任务并分配给TaskTracker执行。TaskTracker运行在从节点上,接收并执行JobTracker分配的任务,同时汇报任务状态。如果某个任务失败,JobTracker会重新调度该任务,保证整个作业的顺利完成。

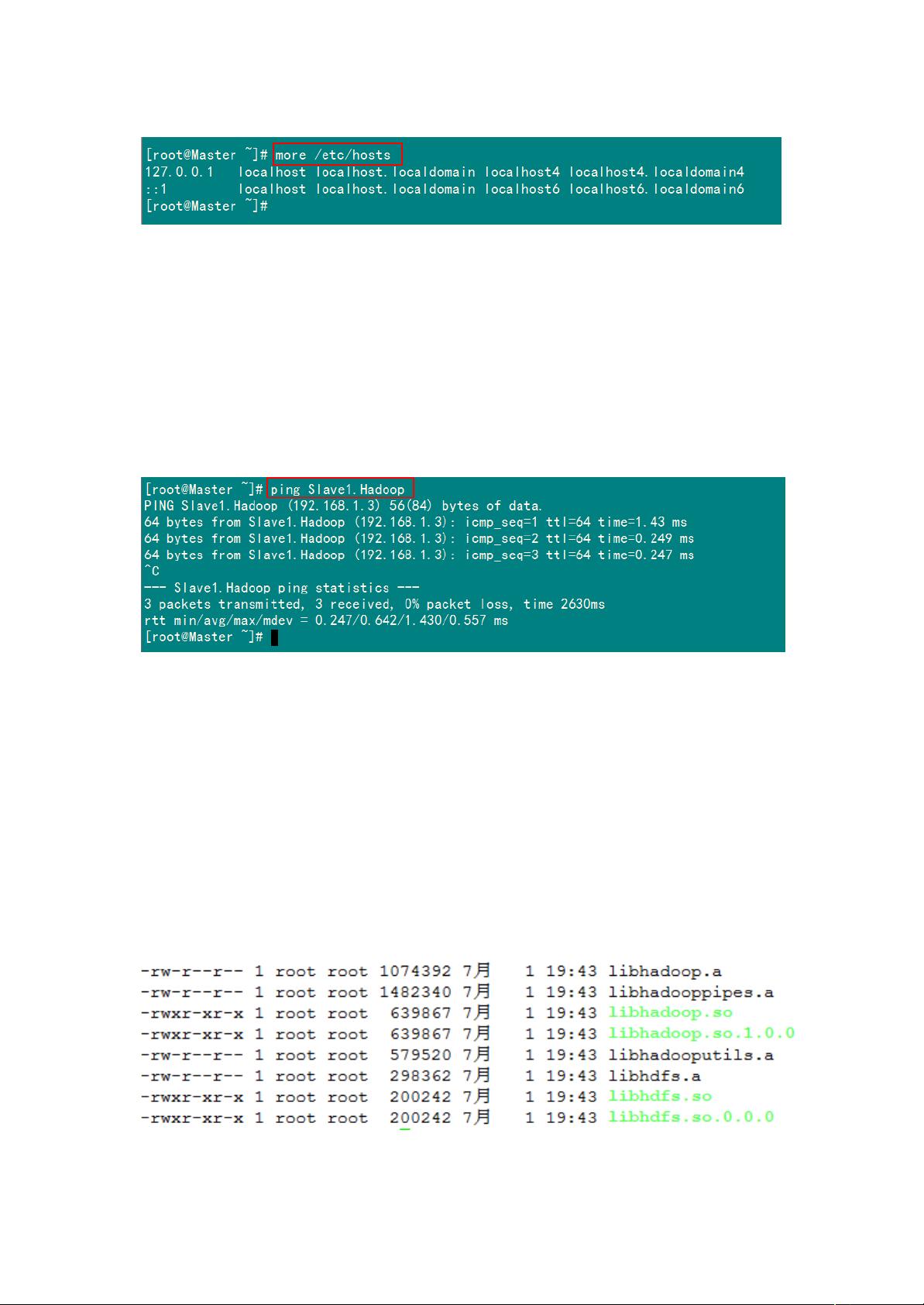

在环境准备阶段,通常会有一个Master节点和多个Slave节点,如在这个案例中,有1个Master节点和2个Slave节点。所有节点需要运行相同的操作系统,例如这里使用的是CentOS6.3 64位,并且需要确保节点间网络连通,可以相互ping通。在安装前,还需要按照特定的指导禁用不必要的服务,如rpcinfo和nfs,以优化Hadoop的运行环境。

安装配置Hadoop时,一般步骤如下:

1. **环境准备**:确保所有节点的操作系统、网络配置和硬件要求满足Hadoop的需求。

2. **安装Java**:Hadoop依赖Java运行,因此需要先安装JDK,并设置好环境变量。

3. **下载Hadoop**:从Apache官网获取最新稳定版本的Hadoop,解压到指定目录。

4. **配置Hadoop**:编辑`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`、`mapred-site.xml`和`yarn-site.xml`等配置文件,设定Master和Slave节点,以及HDFS和MapReduce的相关参数。

5. **格式化NameNode**:首次启动Hadoop前,需要对NameNode进行格式化,初始化HDFS的元数据。

6. **启动Hadoop**:启动Hadoop的所有进程,包括DataNode、NameNode、TaskTracker和JobTracker等。

7. **测试Hadoop**:通过运行简单的WordCount示例验证Hadoop集群是否正常工作。

在实际部署中,还需要考虑安全性、监控、性能优化等因素。例如,启用Hadoop的安全认证(如Kerberos)、配置日志聚合以简化故障排查,以及调整HDFS和MapReduce的参数以提高集群的性能。此外,随着Hadoop生态系统的发展,还可能涉及其他组件的安装,如YARN(用于资源管理和调度)、Hive(用于数据仓库)和Spark(用于大数据处理)等。

Hadoop的安装配置是一个复杂的过程,需要对分布式系统、网络和操作系统有深入理解。正确配置和管理Hadoop集群,能为大数据处理提供强大而可靠的基础设施。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-03-31 上传

2020-11-13 上传

2023-05-04 上传

点击了解资源详情

linux_vae

- 粉丝: 48

- 资源: 38

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用