Kettle数据集成:从入门到精通

需积分: 9 77 浏览量

更新于2024-07-09

收藏 1.07MB DOCX 举报

"Kettle的使用基础手册"

Kettle是一款强大的开源数据集成工具,源自Pentaho公司,专门用于实现ETL(Extract-Transform-Load)流程。ETL是数据仓库建设中的关键步骤,它涉及从各种数据源抽取数据,经过清洗、转换后,再加载到目标系统中。Kettle以其灵活性、高效性和稳定性在众多ETL工具中脱颖而出。

Kettle的ETL过程主要由两个核心组件构成:transformation和job。transformation负责数据的转换,包括数据清洗、转换和预处理等操作;而job则负责工作流的控制,它可以调度和协调多个transformation的执行顺序和条件。

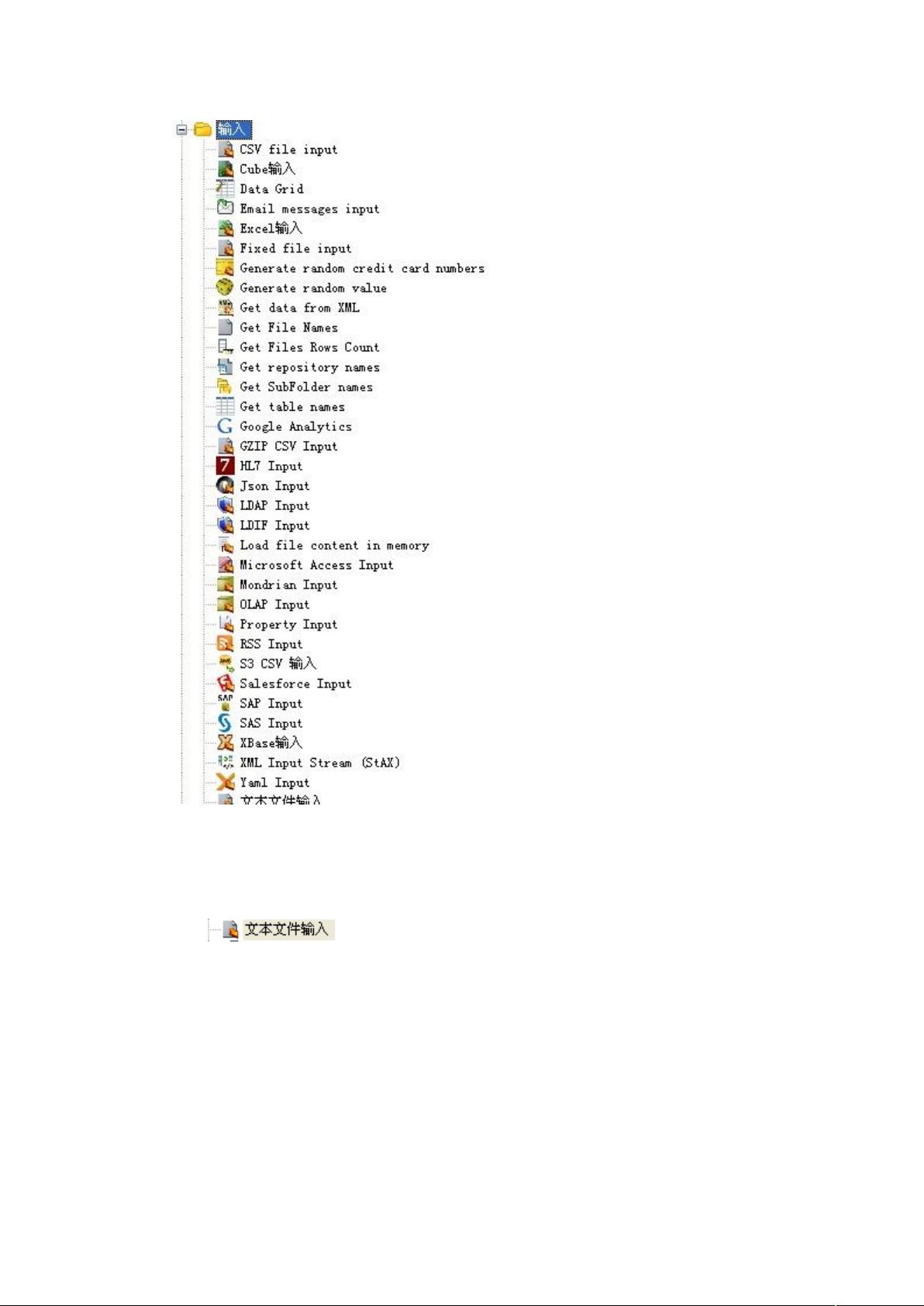

Spoon是Kettle的图形化开发工具,提供友好的用户界面,使得用户可以通过拖拽的方式构建复杂的ETL流程,而无需编写代码。在Spoon中设计的transformation和job可以通过Pan(数据转换引擎)和Kitchen(任务执行器)进行执行。Pan主要用于执行数据转换任务,而Kitchen则用于执行整个工作流。

Kettle的一大特点是其跨平台性,由于是用Java编写的,它可以在Windows、Linux和Unix等多种操作系统上运行。此外,Kettle还支持广泛的数据源,包括各种关系型数据库、文件系统、云存储以及Hadoop等非关系型数据库。这使得Kettle能够处理各种类型和规模的数据,无论是传统的结构化数据还是现代的大数据技术。

Kettle在数据清洗方面表现出色,提供了丰富的数据处理步骤,如过滤、合并、拆分、排序、转换等,可以应对复杂的业务需求。对于大数据处理,Kettle支持并行和分布式计算,能够高效地处理大量数据。同时,它还支持与Hadoop生态系统无缝集成,包括Hadoop作业调度和MapReduce任务的创建。

总结来说,Kettle的主要特点包括:

1. 开源且免费,拥有活跃的社区支持。

2. 强大的图形化开发环境Spoon,易于理解和操作。

3. 跨平台,可在多种操作系统上运行。

4. 支持多种数据源和目标,包括传统数据库和大数据平台。

5. 提供灵活的数据转换和工作流控制机制。

6. 高效处理大数据,支持并行和分布式计算。

7. 集成了Hadoop功能,适应大数据时代的需要。

Kettle不仅适合企业级的数据仓库建设,也是个人开发者和数据分析师进行数据处理和整合的有力工具。无论是在数据迁移、数据清洗,还是在大数据分析中,Kettle都能提供全面的解决方案。通过熟练掌握Kettle,用户可以更有效地管理和操作数据,提升数据的价值。

4512 浏览量

1209 浏览量

2021-09-14 上传

113 浏览量

2023-04-06 上传

2019-09-20 上传

328 浏览量

158 浏览量

539 浏览量

蜗牛小白

- 粉丝: 47

- 资源: 59

最新资源

- JTBC网站内容管理系统

- GameCanvas-Unity:庆应义University大学“智能设备编程”教材GameCanvas for Unity

- Spring Boot 入门到实战

- labview用户登录.zip

- 医生:硕士

- 酒店电传服务管理制度

- matlab开发-SimpleRadarsystemsimulation

- calculadoraIMCemFlutter

- Detect-File-Encoding-and-Language:NPM包,用于检测文件的编码和语言

- 毕业论文-源代码- Java编写手机游戏(程序参考资料)论文字数:71453字.zip

- flux:solr的clojure客户

- 关系

- 账单系统(资金事件版).zip

- protopotesRaider:列出抽动好友的工具,只需单击一下即可突袭他们

- fasstdfs.zip

- 酒店电传、传真、信函订房制度