深度学习笔记:卷积神经网络详解

124 浏览量

更新于2024-08-30

收藏 246KB PDF 举报

"本文是动手学深度学习的学习笔记,主要探讨了卷积神经网络的基础,包括二维卷积层和池化层,以及相关的概念如填充、步幅、输入通道和输出通道。通过实例介绍了二维互相关运算的实现,并定义了一个简单的二维卷积层类。"

在深度学习中,卷积神经网络(Convolutional Neural Networks, CNN)是处理图像等高维数据的核心模型。本篇学习笔记重点讲述了CNN的基础知识,首先是卷积层和池化层。

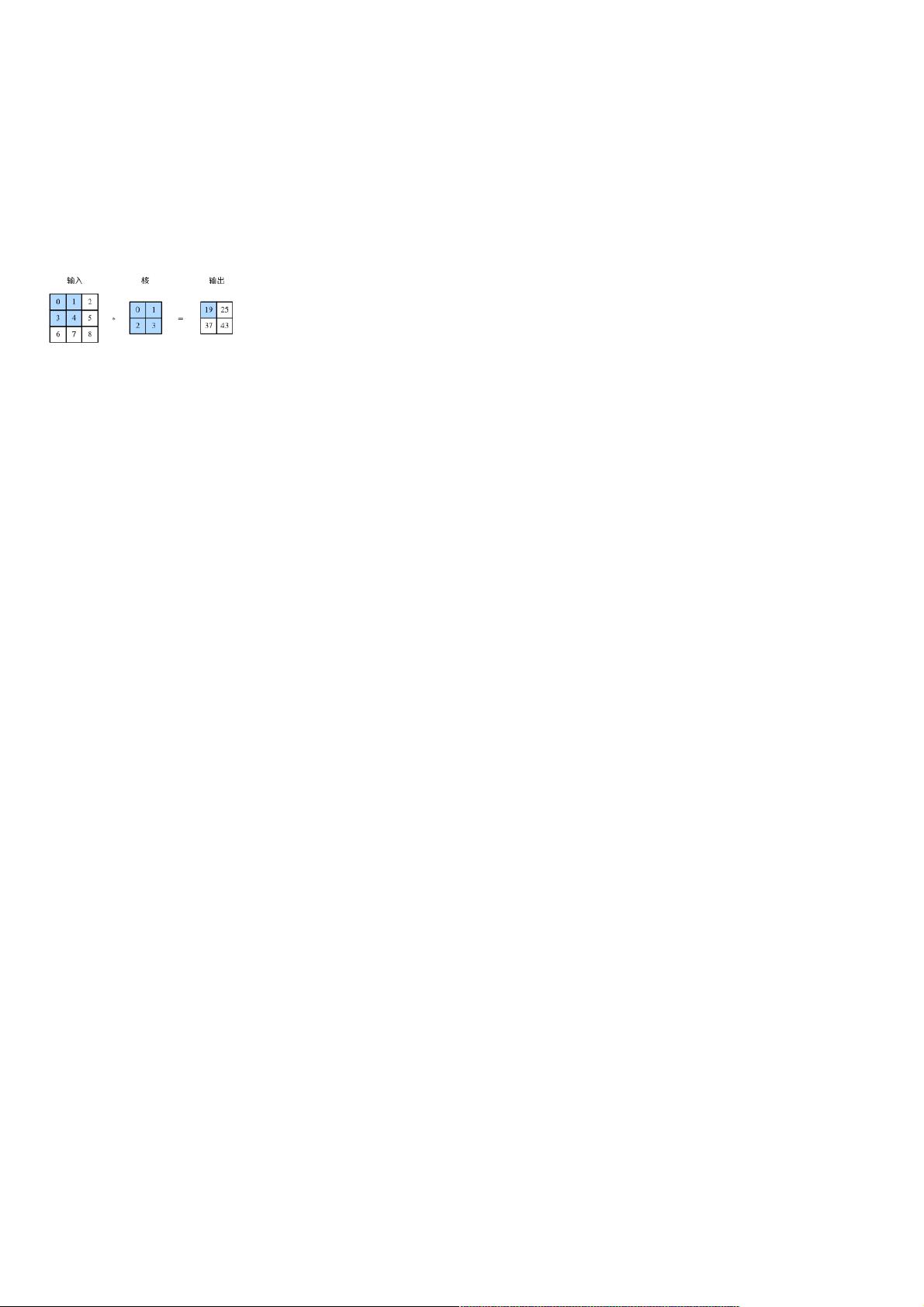

卷积层是CNN的核心组成部分,它的主要功能是对输入数据进行特征提取。在二维卷积层中,数据通常是二维的,例如图像,由多个像素点组成。卷积层通过二维互相关运算来处理这些数据。二维互相关运算是一种特殊的运算方式,其中输入是一个二维数组(如图像),卷积核(或称过滤器)是另一个小的二维数组。卷积核在输入数组上滑动,对每个位置上的输入子数组与卷积核进行逐元素乘法后求和,形成输出数组的一个元素。这个过程可以有效地捕捉输入数据的空间关系,发现局部特征。

卷积层的一些关键参数包括:

1. **填充(Padding)**:在输入数组边缘添加额外的零,以保持输出尺寸与输入尺寸一致或按照预设比例调整。

2. **步幅(Stride)**:卷积核在输入数组上移动的步长,决定了输出的分辨率。

3. **输入通道(Input Channels)**:对应于输入数据的颜色通道,例如RGB图像有三个通道。

4. **输出通道(Output Channels)**:表示卷积层能够检测到的不同特征的数量,每个通道对应一组卷积核。

为了更直观地理解二维互相关运算,文中提供了一个示例,通过Python的PyTorch库实现了一个名为`corr2d`的函数,演示了如何对输入数组`X`和卷积核`K`进行二维互相关运算。然后,通过创建一个简单的二维卷积层类`Conv2D`,展示了卷积层如何结合权重和偏置生成输出。

此外,文中提到的leNet是最早的卷积神经网络之一,用于识别手写数字,它奠定了现代卷积神经网络的基础。卷积神经网络的进阶部分可能包括更复杂的网络架构,如更深的网络层次、激活函数、批量归一化、dropout等技术,这些技术有助于提升模型性能和防止过拟合。

这篇学习笔记提供了对卷积神经网络基本原理的深入理解和实践,对于初学者来说是深入理解深度学习,特别是图像处理领域的重要参考资料。通过学习这些基础知识,读者可以为进一步探索更高级的CNN架构和应用打下坚实的基础。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-01-06 上传

2024-04-26 上传

2021-01-20 上传

2021-01-07 上传

2021-01-06 上传

2021-01-06 上传

weixin_38706951

- 粉丝: 4

- 资源: 930

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用