图像拼接与PDF整合技术教程

需积分: 9 187 浏览量

更新于2024-07-22

收藏 2.04MB PDF 举报

"图像拼接处理的教程,涵盖了图像对齐和拼接的算法,适合视频稳定、总结和全景图像创建等应用。"

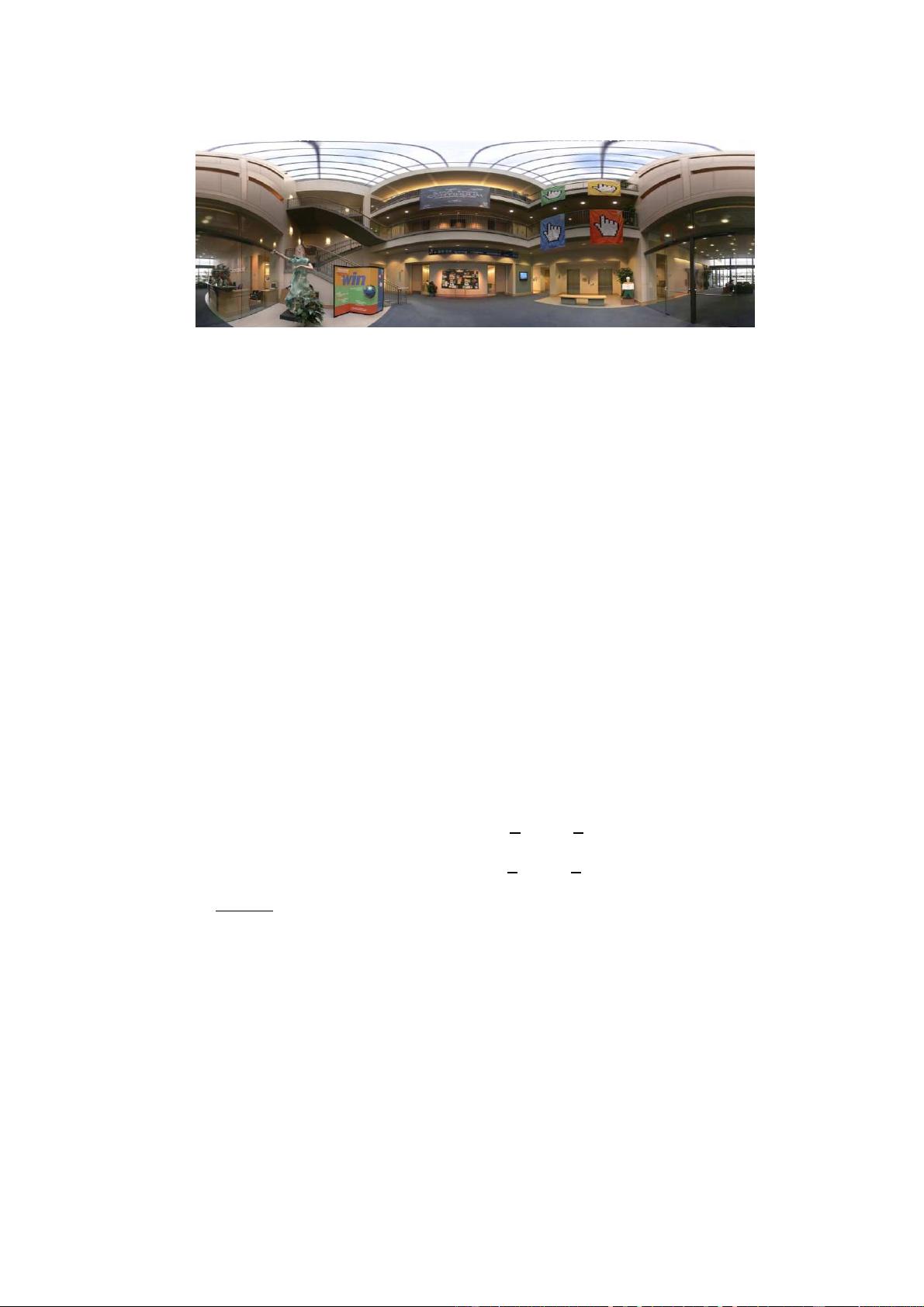

在图像处理领域,图像拼接是一种技术,它将多张图片合并成一张大图,通常用于创建全景照片或在有限视角下展示更广阔的场景。这个过程主要涉及两个关键技术:图像对齐(Image Alignment)和图像拼接(Image Stitching)。

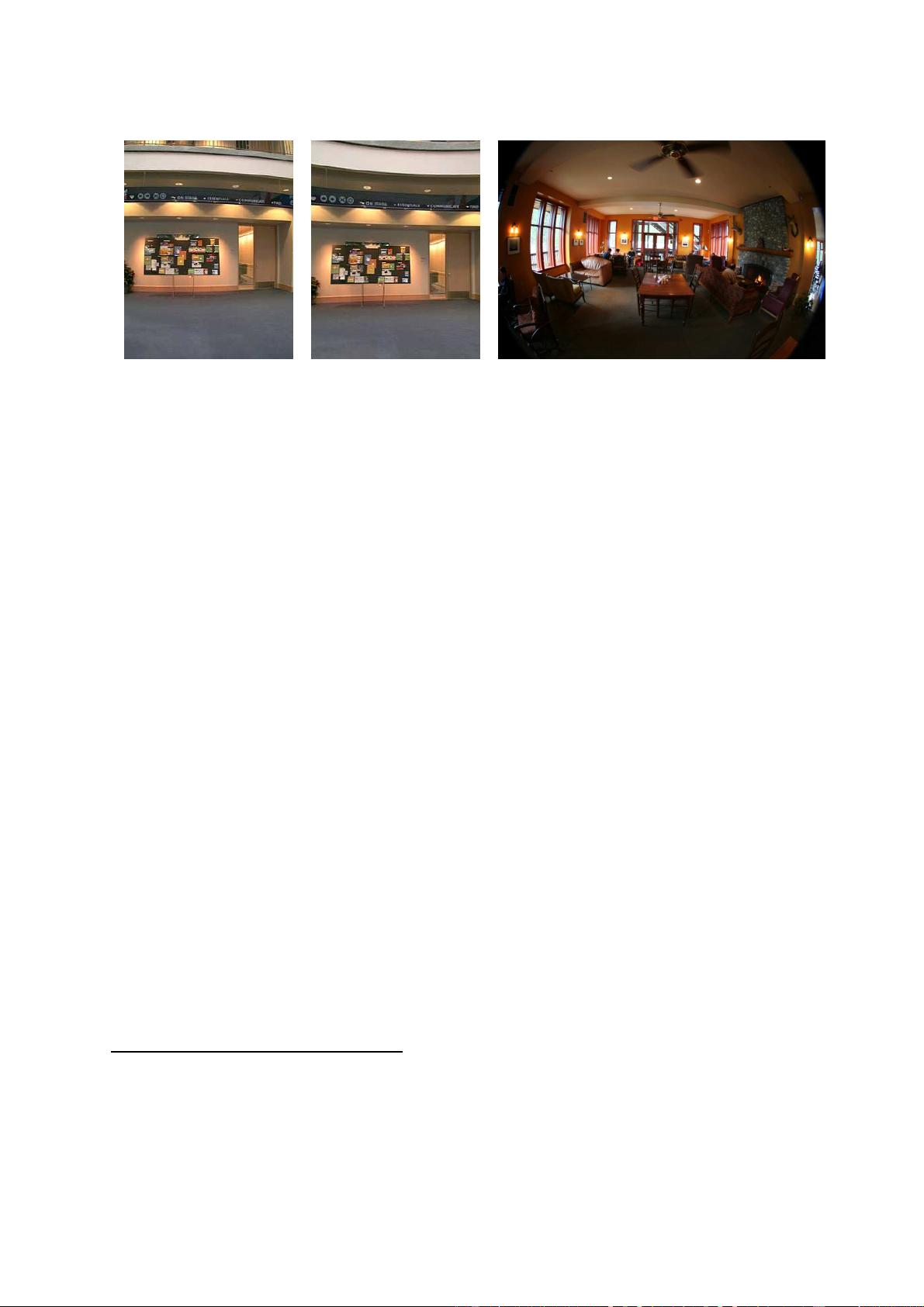

图像对齐是图像拼接的基础,其目标是确定不同图像之间的对应关系,即使得重叠区域的像素能够正确匹配。这通常涉及到不同程度的重叠图像,如在视频稳定、视频摘要中,以及创建全景图像时。对齐算法可以基于像素级(pixel-based)或者特征级(feature-based)的方法。像素级方法直接比较图像的像素值,而特征级方法则识别图像中的显著点或结构,如边缘、角点,然后对这些特征进行匹配。

特征级对齐算法通常更为鲁棒,因为它不那么依赖于精确的像素匹配。例如,SIFT(尺度不变特征变换)和SURF(加速稳健特征)就是常用的特征检测和描述算子,它们能够在光照变化、尺度变化等条件下保持稳定。

图像拼接则是将对齐后的图像进行无缝融合,这需要解决由于视差、场景移动导致的模糊(blurring)和鬼影(ghosting)问题,以及因曝光差异引起的色彩不一致。融合算法通常会使用图像过渡技术,比如使用权重函数来平滑过渡区,减少视觉上的割裂感。此外,为了处理曝光差异,可能还需要进行色调映射(tonemapping)或亮度调整。

该教程还讨论了基本的运动模型,这是理解对齐和拼接算法的关键。这些模型包括平移、旋转、缩放等基本几何变换,以及更复杂的仿射和透视变换。对于动态场景,可能还需要考虑时间相关的运动模型。

最后,教程指出该领域的开放性研究问题,可能包括如何提高对齐精度、如何处理更大的视差、如何在复杂环境下(如快速移动物体、光照剧烈变化)实现更好的拼接效果,以及如何实现更加自然和无缝的图像融合。

图像拼接处理是一个涉及多种技术和算法的复杂过程,它在摄影、虚拟现实、地图制作等多个领域都有广泛的应用。理解和掌握这些技术对于提升图像处理能力至关重要。

2019-12-04 上传

2014-06-03 上传

2023-05-31 上传

2023-05-31 上传

2023-04-27 上传

2024-01-25 上传

2023-04-23 上传

2023-07-13 上传

baidu_21247875

- 粉丝: 0

- 资源: 1

最新资源

- 新型智能电加热器:触摸感应与自动温控技术

- 社区物流信息管理系统的毕业设计实现

- VB门诊管理系统设计与实现(附论文与源代码)

- 剪叉式高空作业平台稳定性研究与创新设计

- DAMA CDGA考试必备:真题模拟及章节重点解析

- TaskExplorer:全新升级的系统监控与任务管理工具

- 新型碎纸机进纸间隙调整技术解析

- 有腿移动机器人动作教学与技术存储介质的研究

- 基于遗传算法优化的RBF神经网络分析工具

- Visual Basic入门教程完整版PDF下载

- 海洋岸滩保洁与垃圾清运服务招标文件公示

- 触摸屏测量仪器与粘度测定方法

- PSO多目标优化问题求解代码详解

- 有机硅组合物及差异剥离纸或膜技术分析

- Win10快速关机技巧:去除关机阻止功能

- 创新打印机设计:速释打印头与压纸辊安装拆卸便捷性