Word2Vec教程: Skip-Gram模型解析

需积分: 10 144 浏览量

更新于2024-09-09

收藏 483KB PDF 举报

"word2vec是自然语言处理领域中一种用于编码单词语义信息的神经网络模型。它通过无监督学习的方式,从大量未标注的文本数据中生成每个单词的向量表示,使得这些向量能够反映单词的语义含义。在word2vec中有两种主要模型:Continuous Bag of Words (CBOW) 和 Skip-Gram模型。本教程主要关注Skip-Gram模型。

Skip-Gram模型的基本思想是,给定一个中心词(context word),尝试预测其周围的上下文词(context words)。这与CBOW模型相反,CBOW是通过上下文词来预测中心词。Skip-Gram模型能够更好地捕捉到单词的分布假设,即相似的上下文往往出现在相似的单词周围。

在Skip-Gram模型中,训练过程通常包括两个步骤:前向传播和负采样。在前向传播阶段,当前词的向量被输入到神经网络中,然后通过softmax函数计算出每个上下文词的概率。负采样是优化过程中的一部分,它避免了在大规模词汇表中计算所有词对概率的计算复杂性,通过随机选择一部分“负样本”进行对比学习,以提高训练效率。

word2vec模型生成的向量具有许多有趣的特性。例如,通过计算两个单词向量的余弦相似度,我们可以量化它们之间的语义相似度。这种相似度可以用于诸如文档分类、命名实体识别和情感分析等监督任务,因为这些向量包含了丰富的语义信息,可以作为有效的特征。

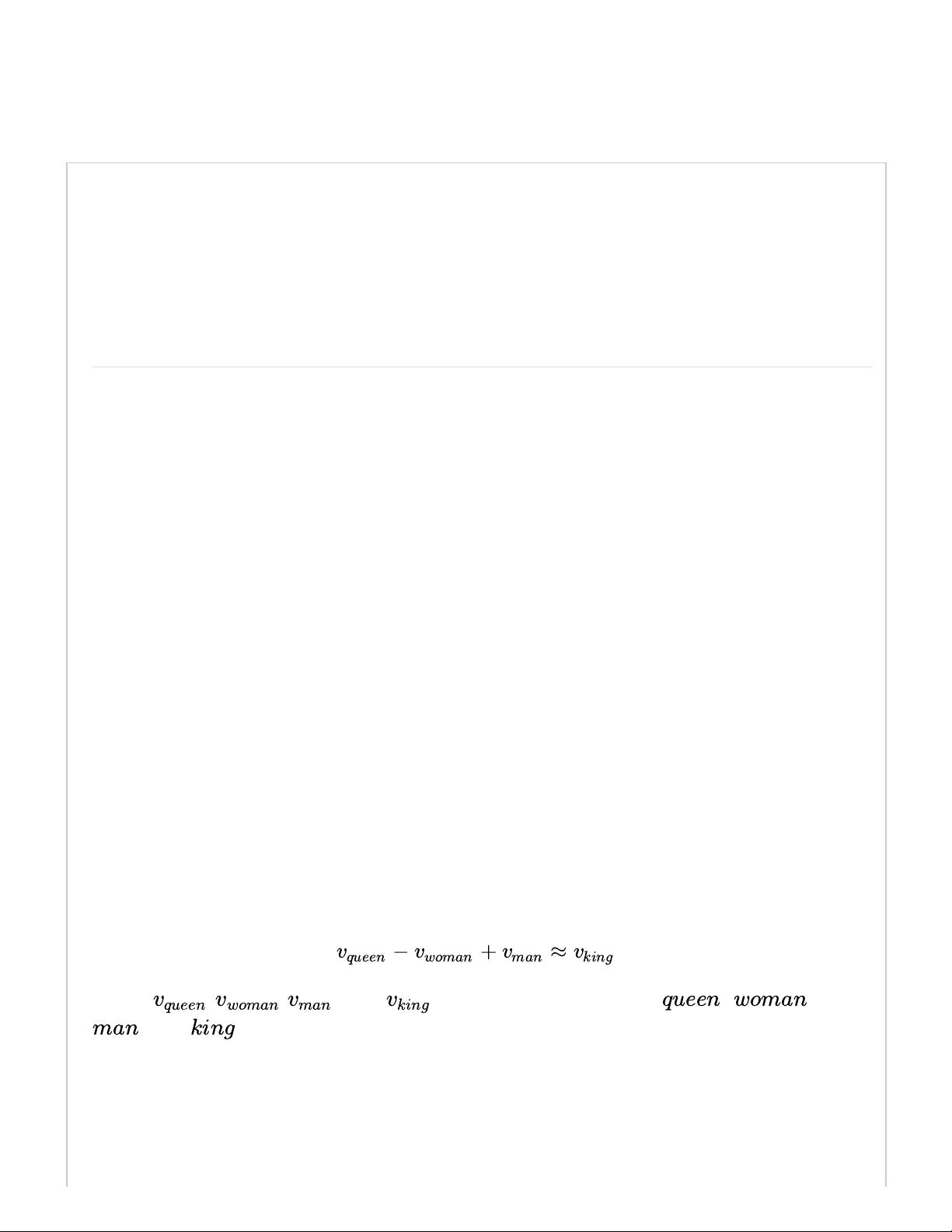

为了验证word2vec向量是否有效地捕捉了单词的语义,研究者们进行了多个实验。其中最著名的就是“国王-男性+女性=王后”这样的词汇关系推理。如果向量空间中的这种线性关系能够成立,那么说明模型确实编码了单词之间的语义联系。此外,word2vec向量还在词义消歧、翻译任务和推荐系统等领域展现出强大的应用潜力。

word2vec通过Skip-Gram模型提供了单词的分布式表示,这些表示不仅包含了单词的统计信息,还捕获了语义和句法结构。这一技术对于自然语言处理的诸多任务而言,是一个极其有价值的工具,极大地推动了NLP领域的发展。"

1536 浏览量

154 浏览量

900 浏览量

209 浏览量

2021-05-21 上传

离线��

- 粉丝: 1

- 资源: 3

最新资源

- 行业分类-设备装置-一种接布机.zip

- pop-punk.vim::guitar: vim 的深色、高对比度配色方案

- 基于Java Web 技术的网上订餐系统.zip

- avsdpll_1v8_sky130_ss

- 草地lar

- random-int:产生一个随机整数

- 利用Python实现三层BP神经网络.zip

- ajax_app

- ctcsound:使用 ctypes 的 Csound 的 Python 绑定。 也可以从 python2.x 和 python3.x 使用

- 行业分类-设备装置-一种接地箱门锁.zip

- 可调叶片离心泵的实际应用.rar

- 学生信息管理系统(含Java源代码) 毕业论文

- gnome-email-notifications:侏儒电子邮件通知

- ORACLE清理工具

- 真棒测试用例集合:此存储库包含初学者的测试用例集合,在验证不同领域的项目时需要包括这些测试用例

- coreos-kubernetes:用于在 CoreOS 上安装和运行 Kubernetes 的 Cloud init 和 Fleet 文件