UCAS-AI深度学习与神经网络发展史:从MP到深度CNN

需积分: 0 57 浏览量

更新于2024-06-30

收藏 4.56MB PDF 举报

本资源聚焦于"UCAS-AI模式识别9神经网络031",深入探讨了人工智能领域中神经网络的发展历程与核心模型。首先,文章回顾了人工神经网络的历史,从20世纪40年代的MP模型(阈值加和模型)和Hebb学习规则开始,经历了多次高潮,如1960年的感知器模型,1980年代的自适应线性单元(Hopfield网络)和Boltzmann机,以及BP算法和SVM等关键理论突破。

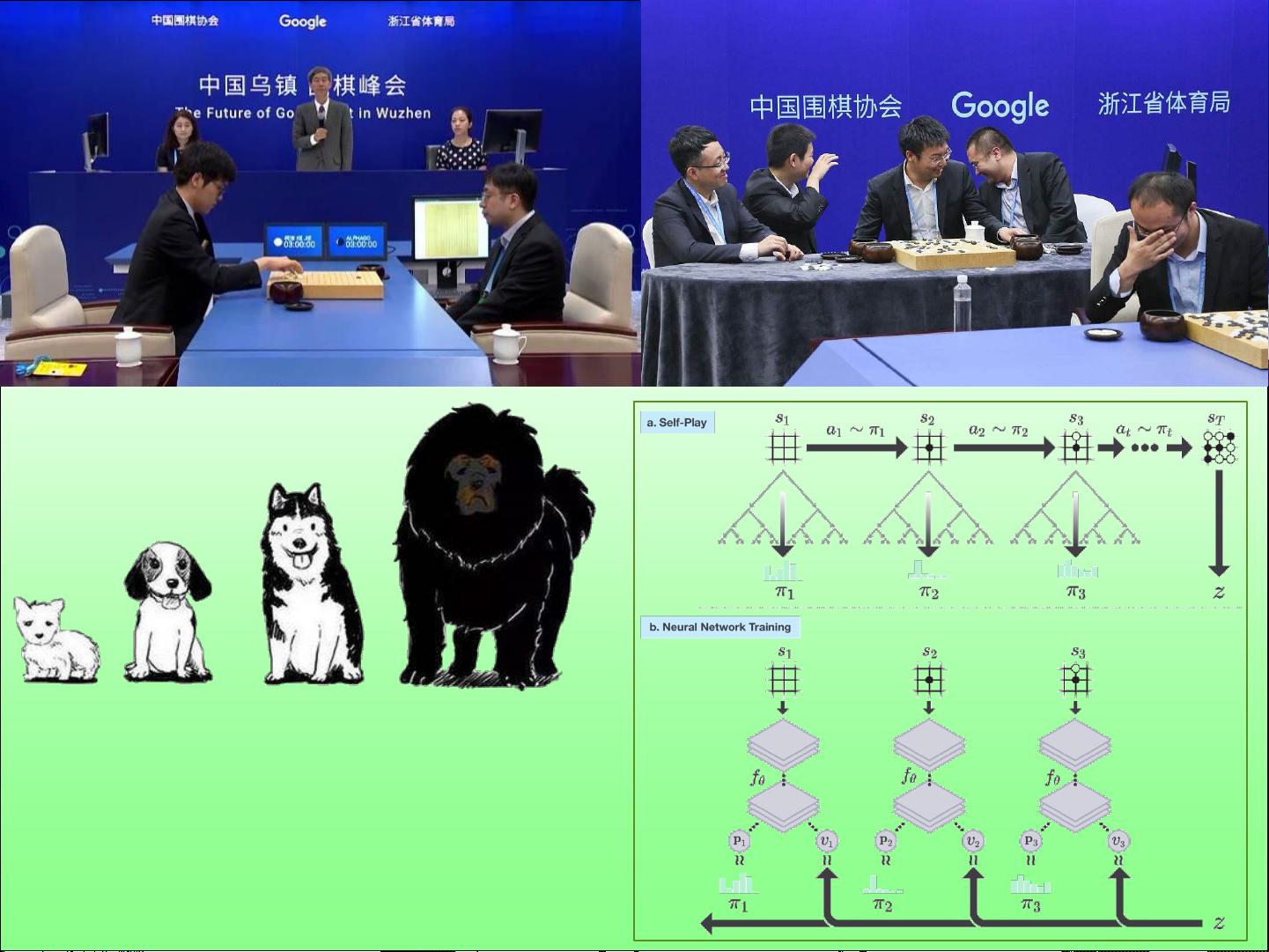

在1990年代,深度学习进入第三次浪潮,特别是随着深度网络(DBN)、深度信念网络(DBM)、深度卷积神经网络(DeepCNN)、循环神经网络(RNN)和长短时记忆网络(LSTM)等复杂模型的提出,AI开始展示出强大的学习能力和对复杂任务的建模能力。这一时期,深度学习解决了过去人工神经网络的局限,如单一任务和结构、过多参数、以及学习效率问题。

然而,在2000年代初期,由于计算能力的限制和样本不足,深度学习一度陷入低谷,直到LeCun的卷积神经网络(CNN)模型在1998年的应用,以及后续技术的改进,如AlexNet和VGG等,才重新点燃了人们对深度学习的热情。

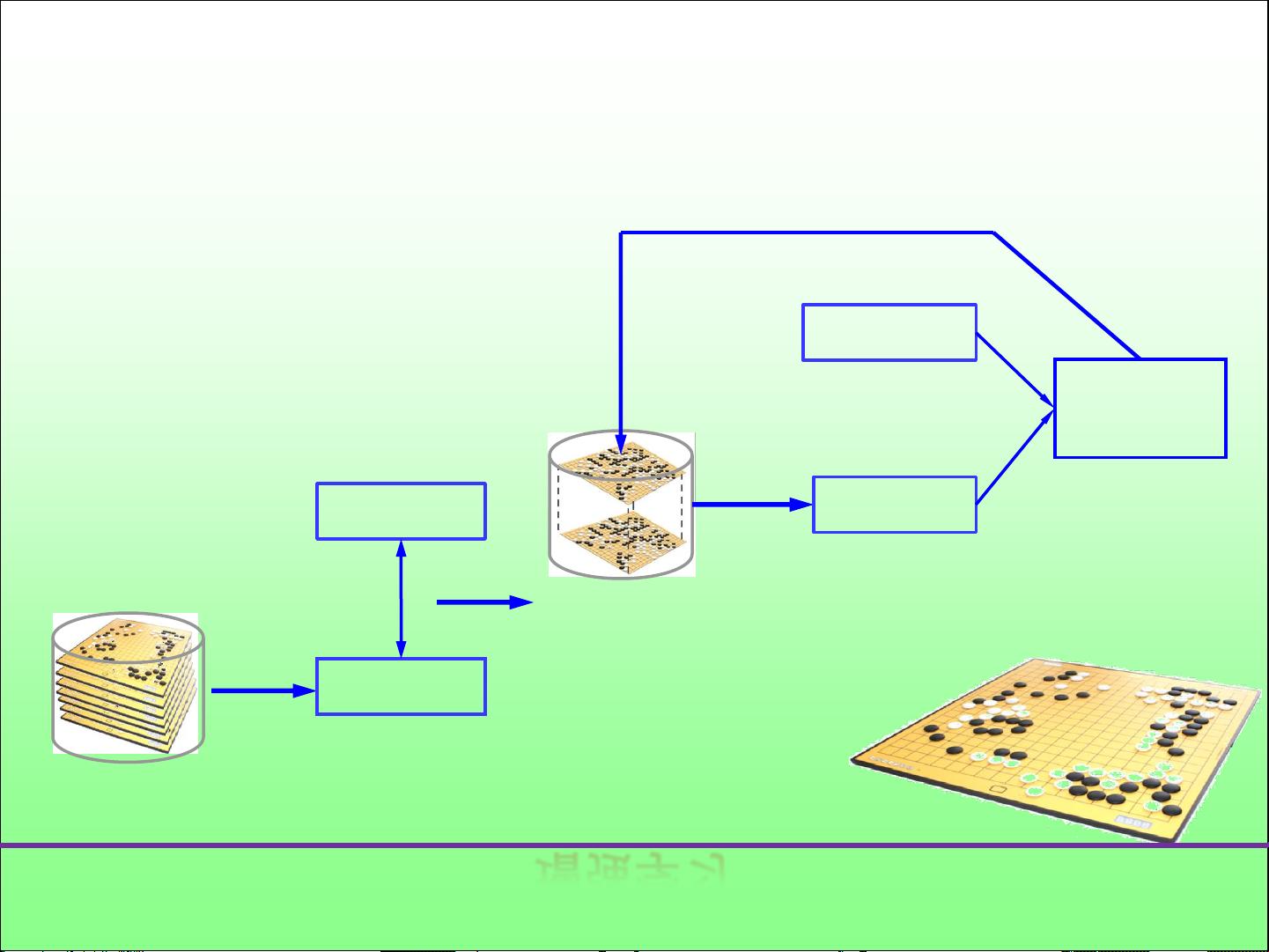

深度学习的核心在于其深度模型架构,这些模型由多个非线性变换层层叠加,能够从数据中自动提取和学习高层抽象特征,极大地提高了机器的学习能力。深度学习的成功解决了大规模参数学习和小样本问题,通过反向传播算法优化权重,使得机器能够自我调整并适应复杂的输入。

本课程内容详尽地介绍了人工神经网络从起源到发展的脉络,以及深度学习如何推动AI技术的革新,包括其背后的理论基础、关键模型和技术,对于理解人工智能特别是模式识别领域的最新进展具有重要意义。

2022-08-04 上传

2022-08-03 上传

2022-08-04 上传

2022-08-04 上传

2023-07-21 上传

2022-08-03 上传

2022-08-04 上传

2022-08-04 上传

2022-08-03 上传

又可乐

- 粉丝: 663

- 资源: 309