Spark视觉API详解:从操作到高级分析

需积分: 9 171 浏览量

更新于2024-07-19

收藏 3.62MB PDF 举报

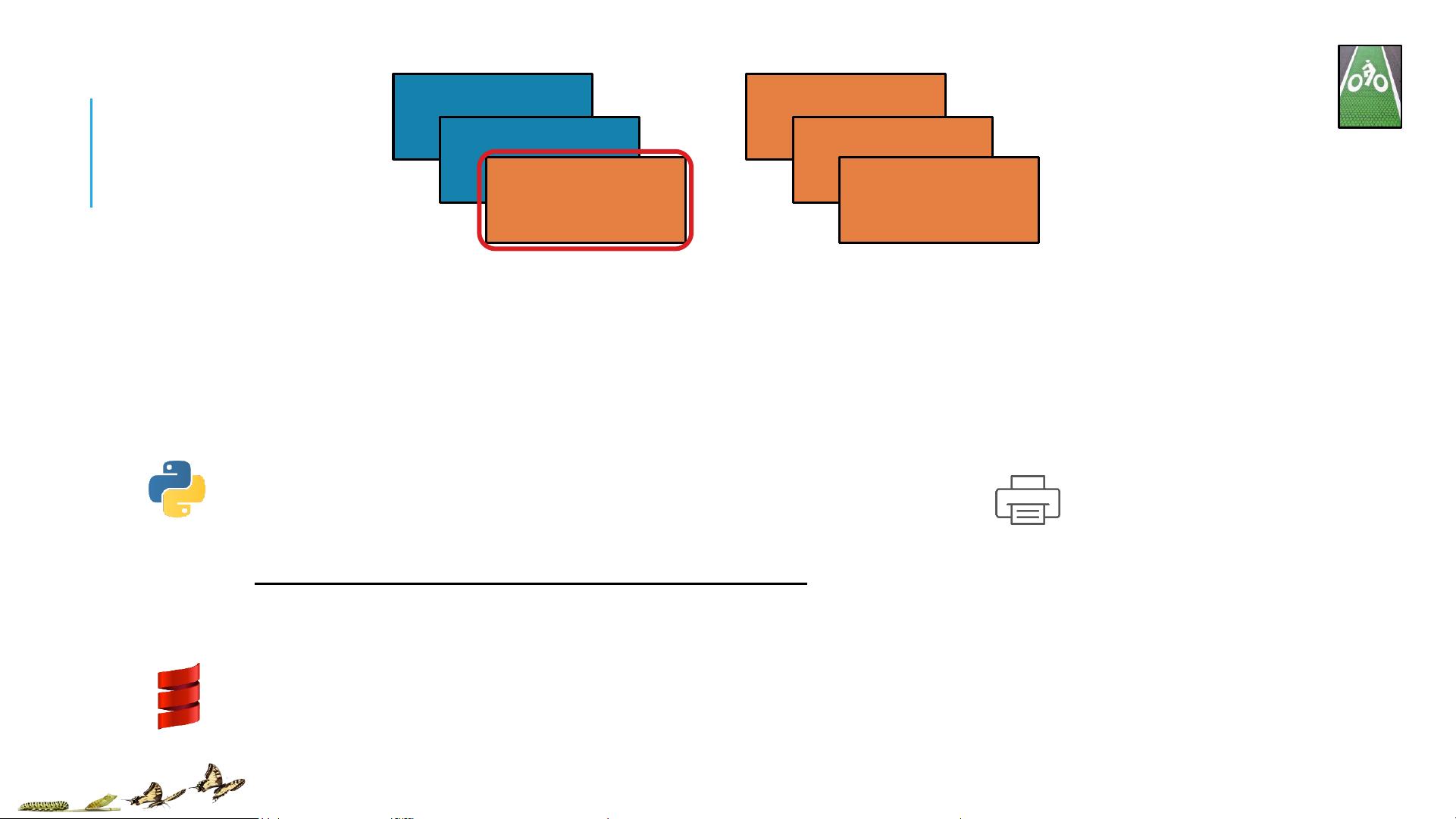

Spark Visual API是Apache Spark生态系统中的一个重要组成部分,它提供了一种直观的方式来理解和操作分布式计算框架。这份名为"TRANSFORMATIONSANDACTIONS:AVisualGuideoftheAPI"的文档深入解析了Spark API的核心概念,旨在帮助用户更好地掌握如何在Spark环境下进行数据转换和操作。

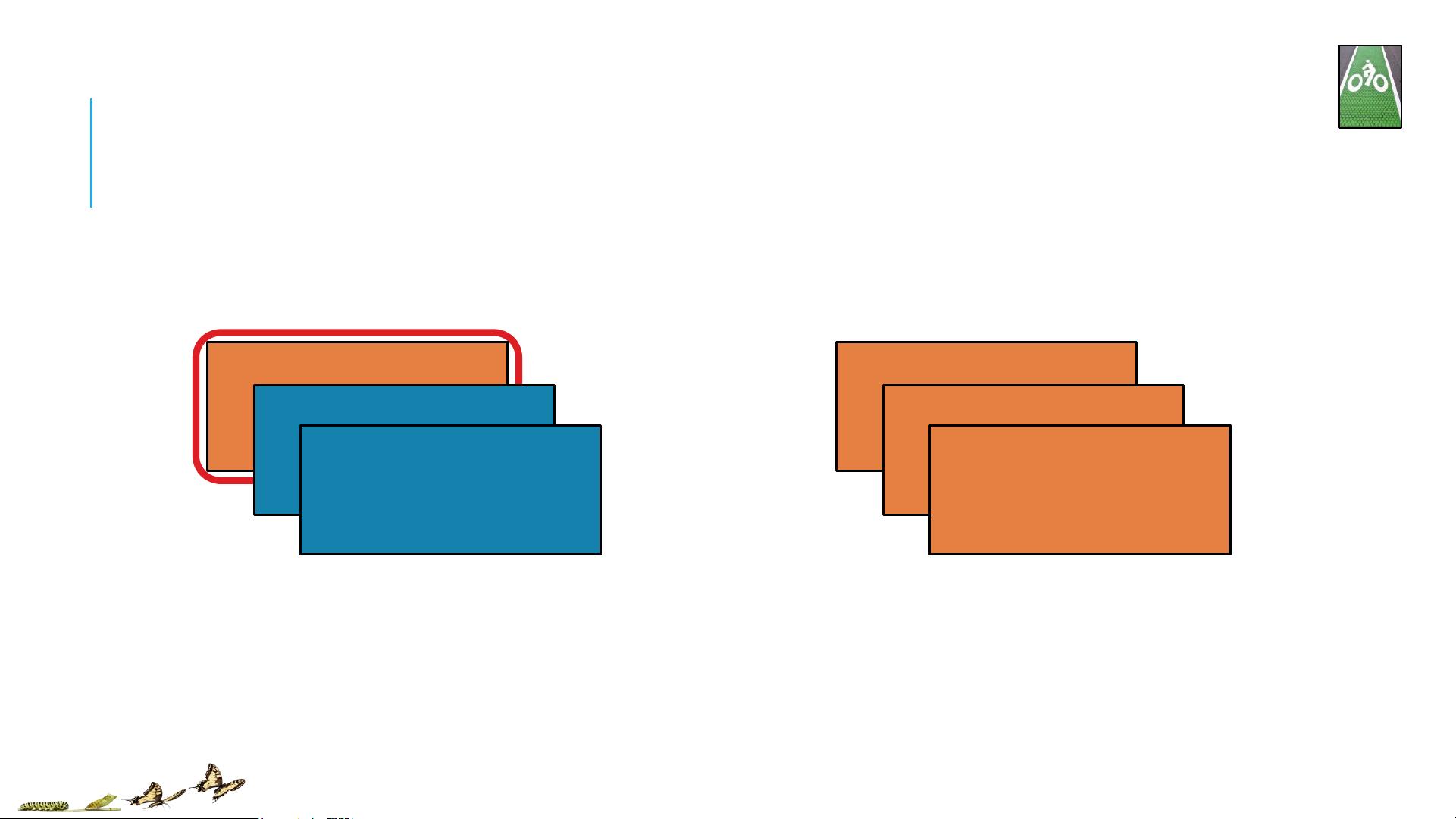

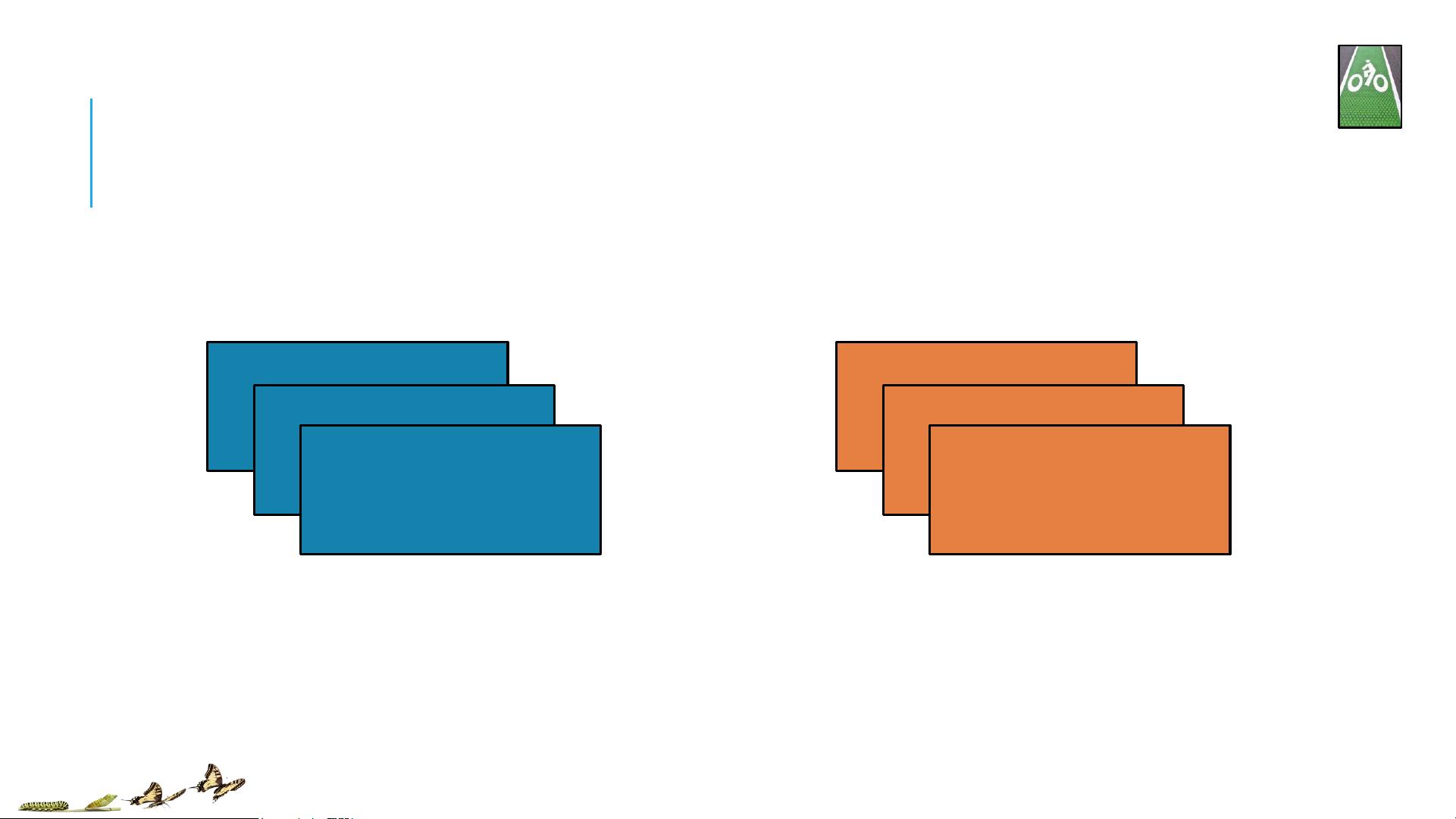

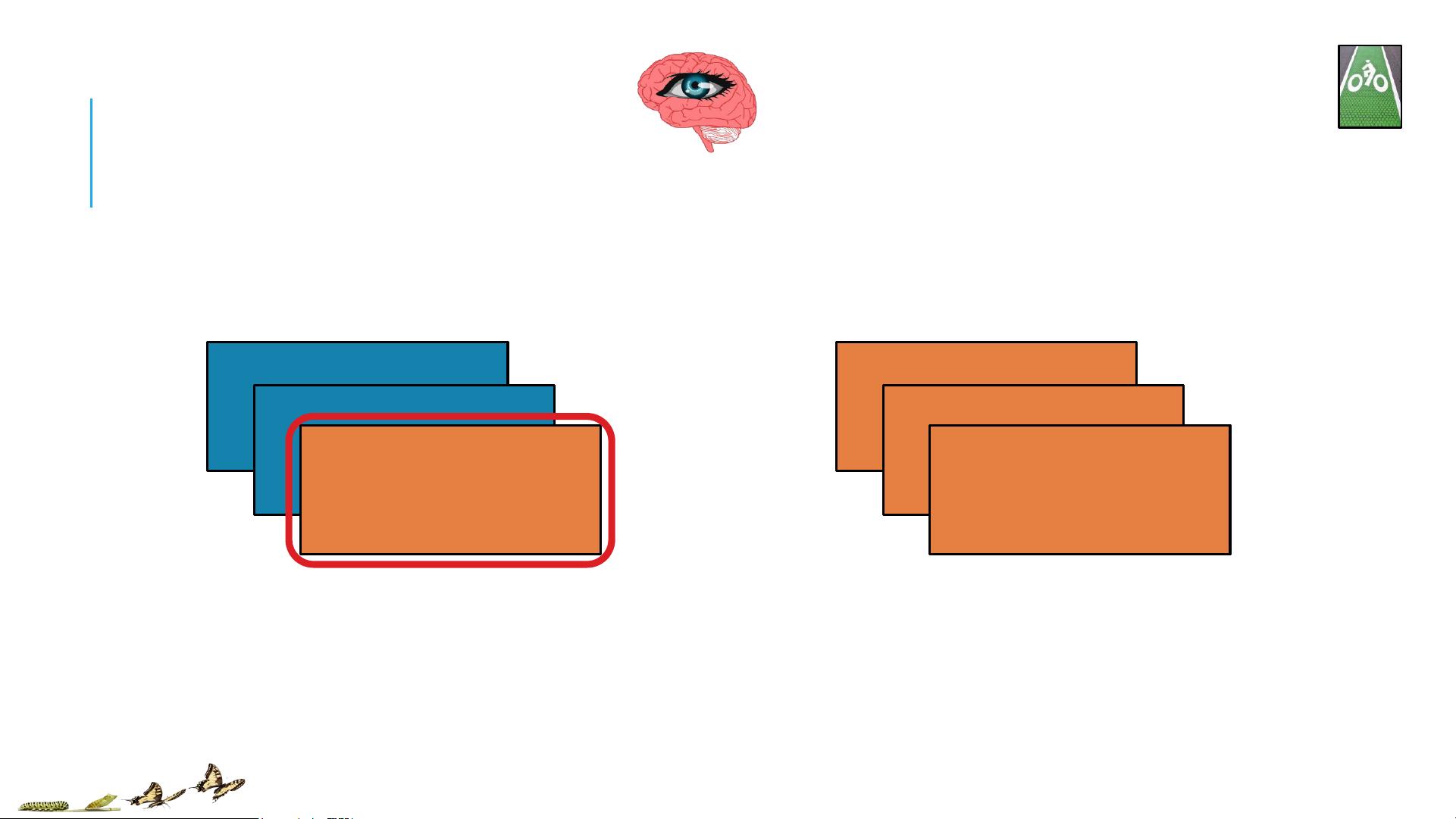

Spark API的基础是Resilient Distributed Datasets (RDD),它是Spark中的核心抽象,用于处理分布式数据集。在这个视觉指南中,RDD被描绘为一个对象,位于驱动程序(driver)上,由多个分区(partition(s))组成,每个分区可以分布在集群的不同节点上。用户可以通过定义用户函数(userfunctions)来对数据执行操作,这些函数可以在每个分区上并行执行,提高了性能。

Transformations是Spark编程模型的核心,它们将一个RDD转换为另一个RDD,例如map、filter、reduce等操作。这些操作会对数据进行处理,但并不会立即执行,而是生成一个新的、基于原RDD的逻辑计划。当用户请求一个结果时,这些计划才会被执行。Actions则是会触发实际数据操作的函数,如count、collect或save,它们会返回一个值或者将结果写入存储。

Visual Guide展示了这些操作在图解中的执行流程,包括输入(userinput)、变换过程(originalitem到transformed)、以及最终的emittedvalue(输出)。随机化操作(Randomizedoperations)可能涉及到数据的重新分区,确保数据分布均匀,提高并行处理效率。

这个文档背后的贡献者Jeff Thompson和Adam Breindel通过他们的创意工作,使得复杂的数据处理逻辑变得可视化和易于理解。Databricks, Spark的创建者之一,提供了统一的大数据平台,支持从数据提取、加载(ETL)、探索和仪表板,到高级分析和数据产品的构建。自2013年成立以来,Databricks已经获得了约4700万美元的风险投资,并拥有约55名员工,显示出其在大数据领域的强劲势头。

此外,Databricks还与Hortonworks、MapR和DataStax等公司建立了合作伙伴关系,提供了第二级和第三级的支持服务。如果你对加入这样一个创新且高速发展的团队感兴趣,可通过Databricks的招聘页面(<http://databricks.workable.com>)了解更多信息。

Spark Visual API文档是一份实用的工具,帮助用户更直观地掌握Spark编程的内在机制,对于提升大数据处理能力具有重要的指导意义。

2021-03-10 上传

2021-05-09 上传

2009-10-29 上传

2021-08-09 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_40001777

- 粉丝: 0

- 资源: 1

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜