理解LSTM的长期与短期记忆机制

需积分: 0 36 浏览量

更新于2024-08-05

收藏 2.31MB PDF 举报

"3LSTM介绍1"

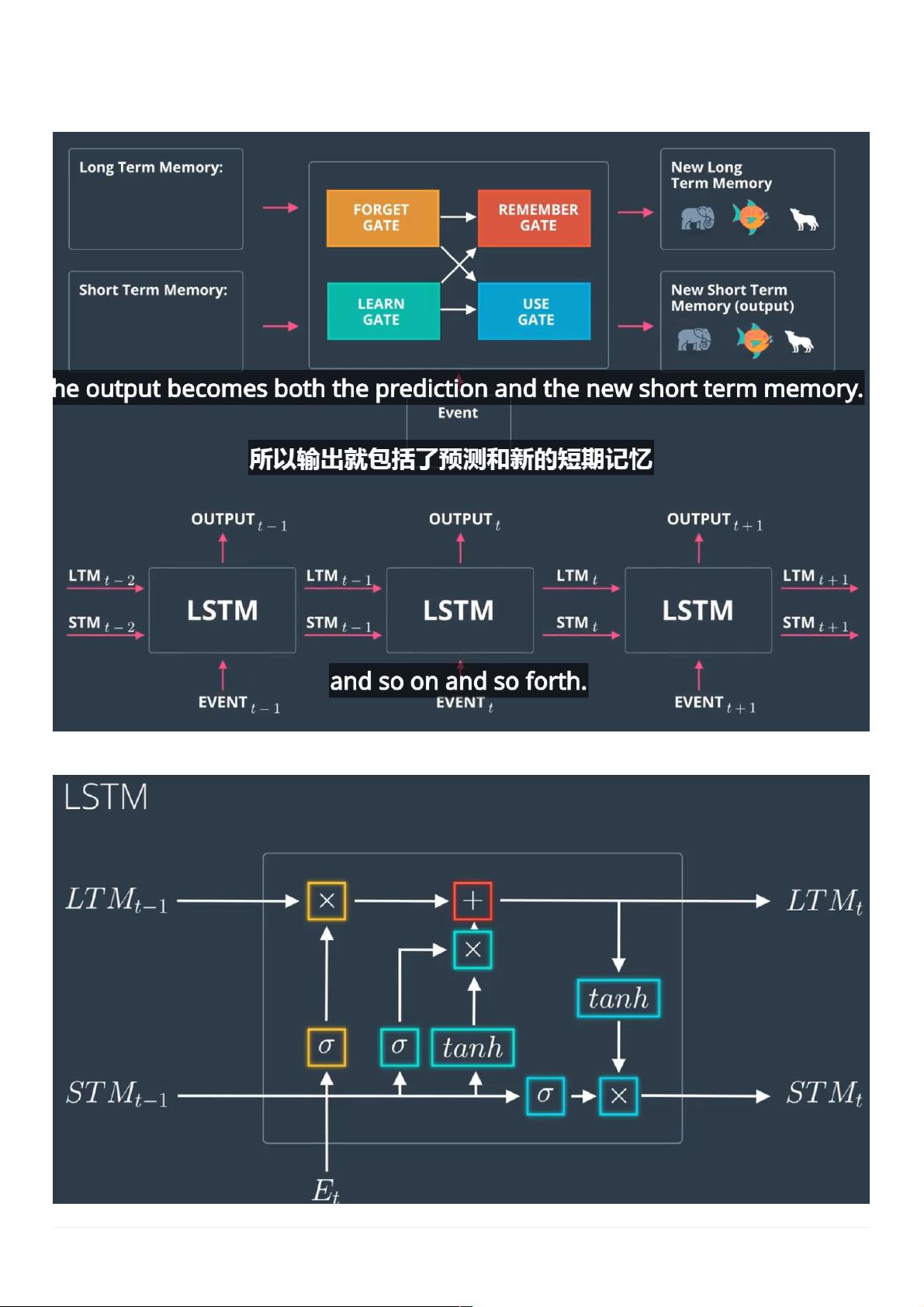

本文主要介绍了长短时记忆网络(LSTM),这是一种在人工智能领域,尤其是自然语言处理和序列数据建模中广泛使用的递归神经网络(RNN)变体,旨在解决传统RNN存在的长期依赖问题。

在普通的RNN中,由于梯度消失或梯度爆炸等问题,模型往往难以捕捉和处理长期的依赖关系,只能有效地存储短期记忆。而LSTM引入了一种特殊的设计,使得它可以更好地处理长期和短期记忆,从而在序列数据的分析和预测中表现出色。

LSTM的基本框架包含四个核心部分:遗忘门(Forget Gate)、输入门(Input Gate)、输出门(Output Gate)和记忆细胞(Memory Cell)。这四个门控机制协同工作,允许LSTM在不丢失关键信息的情况下,选择性地记住或忘记信息。

遗忘门负责决定丢弃旧记忆中的哪些部分。它根据当前输入和前一时刻的隐藏状态计算一个遗忘因子,然后将这个因子与上一时间步的长期记忆相乘,从而决定遗忘哪些信息。

输入门则控制新信息的流入。它首先通过一个非线性激活函数(如tanh)处理当前输入和隐藏状态的组合,生成新的候选记忆。然后,输入门会生成一个新记忆因子,这个因子与候选记忆相乘,确定新信息的量。

记忆细胞的作用是存储经过遗忘门筛选后的长期记忆,并结合输入门学到的新信息。这种设计使得LSTM能够保留远期的相关信息,即使这些信息在序列中间隔较远。

输出门用于决定哪些信息应当传递到下一个时间步以及作为当前时间步的输出。它同样基于当前输入和隐藏状态来生成一个输出因子,这个因子与经过遗忘和输入门处理后的记忆细胞状态相乘,得到最终的输出,即当前时间步的隐藏状态和预测结果。

LSTM通过这些门控机制有效地解决了传统RNN中的长期依赖问题,使其在处理序列数据时,无论是语言理解、文本生成还是时间序列预测等方面,都能展现出强大的性能。LSTM的这一特性使得它成为人工智能领域,特别是深度学习中不可或缺的工具之一。

2022-05-06 上传

2021-09-11 上传

2022-08-03 上传

2021-03-31 上传

2024-07-23 上传

2023-08-18 上传

2023-05-12 上传

2023-02-17 上传

2023-11-17 上传

牛站长

- 粉丝: 31

- 资源: 299

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜