两台虚拟机上Linux Hadoop安装及集群配置教程

需积分: 9 150 浏览量

更新于2024-09-10

收藏 113KB DOCX 举报

本文档详细介绍了如何在Linux环境下,尤其是在两台虚拟机CentOS 6.4-i386上安装和配置Hadoop 0.20.0集群。整个过程分为几个关键步骤:

1. **环境准备**:

- 安装环境包括两台虚拟机,其中一台作为Master(192.168.112.3,即linux1),另一台作为Slave(192.168.112.4,即linux2)。确保两台机器之间的网络连接正常。

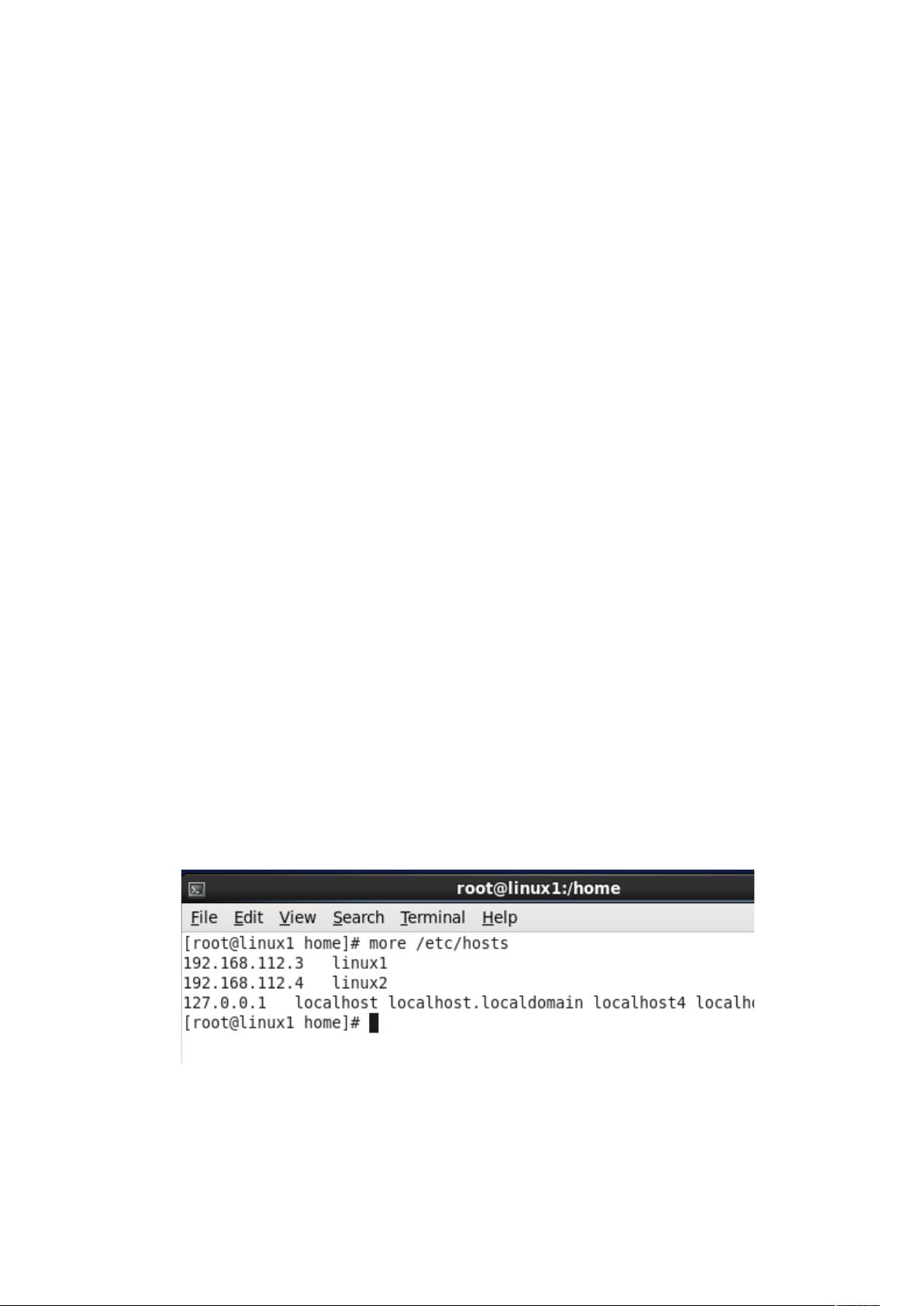

2. **hosts配置与SSH无密码登录**:

- 在两台机器的`/etc/hosts`文件中添加对应主机名和IP地址,便于后续的通信。

- 在Master上执行SSH密钥对生成(id_rsa和id_rsa.pub),并将公钥复制到Slave的authorized_keys文件中,实现无密码SSH登录。

3. **安装JDK**:

- 在两台服务器上安装Java Development Kit (JDK) 7u45,通过解压并配置环境变量`JAVA_HOME`指向安装目录。用户需自行调整环境变量路径。

4. **检查JDK安装**:

- 使用`java –verbose`或`java –version`命令验证JDK是否正确安装。

5. **Hadoop安装与配置**:

- 解压Hadoop-0.20.0.tar.gz文件到相应目录,并进入Hadoop的安装目录。

- 配置Hadoop的主要配置文件(通常在`hadoop-0.20.0/conf`目录下),这些配置可能包括核心配置(如core-site.xml, hdfs-site.xml, mapred-site.xml等)和其他必要的环境变量设置。

6. **配置Master节点**:

- Master节点通常负责Hadoop的NameNode和JobTracker角色,需要额外配置,如启动守护进程、分配数据块等。

7. **配置Slave节点**:

- Slave节点主要是DataNode和TaskTracker角色,配置时需要指定从Master节点获取任务和数据块信息。

8. **集群验证**:

- 安装和配置完成后,通过运行Hadoop的相关命令(如`start-all.sh`或`hadoop-daemon.sh start namenode`等)来启动服务,并检查日志以确保集群配置无误。

这篇文档提供了一个基础的步骤指南,帮助读者在Linux环境下搭建Hadoop 0.20.0集群,适用于初学者和需要在本地进行小规模测试的情况。随着Hadoop版本的更新,部分细节可能会有所变化,但基本原则保持一致。

285 浏览量

1291 浏览量

102 浏览量

117 浏览量

qq343526776

- 粉丝: 0

最新资源

- Subclipse 1.8.2版:Eclipse IDE的Subversion插件下载

- Spring框架整合SpringMVC与Hibernate源码分享

- 掌握Excel编程与数据库连接的高级技巧

- Ubuntu实用脚本合集:提升系统管理效率

- RxJava封装OkHttp网络请求库的Android开发实践

- 《C语言精彩编程百例》:学习C语言必备的PDF书籍与源代码

- ASP MVC 3 实例:打造留言簿教程

- ENC28J60网络模块的spi接口编程及代码实现

- PHP实现搜索引擎技术详解

- 快速香草包装技术:速度更快的新突破

- Apk2Java V1.1: 全自动Android反编译及格式化工具

- Three.js基础与3D场景交互优化教程

- Windows7.0.29免安装Tomcat服务器快速部署指南

- NYPL表情符号机器人:基于Twitter的图像互动工具

- VB自动出题题库系统源码及多技术项目资源

- AndroidHttp网络开发工具包的使用与优势