利用1B参数小模型实现CoT技术:击败GPT3.5的高效推理法

需积分: 0 115 浏览量

更新于2024-08-02

收藏 2.46MB PDF 举报

在2023年4月23日的一份名为"如何使用1B参数的小模型吊打GPT3.5"的Kaggle教程和竞赛资料中,本文详细探讨了如何利用Chain-of-Thought (COT) 技术在AI领域特别是自然语言处理(NLP)中的应用,尤其是在解决推理任务时提升小模型的表现。COT的核心概念在于引导模型通过一系列中间推理步骤来解决问题,而非单纯依赖于上下文线索。

传统的提示方式往往局限于提供问题和答案样例,然后让模型尝试预测缺失的答案。这种方式在处理推理问题时存在局限性,因为模型可能无法理解和构建正确的推理路径。COT通过在输入中增加人为编写的中间推理步骤,帮助模型理解问题的逻辑结构,从而提高其解决问题的能力。

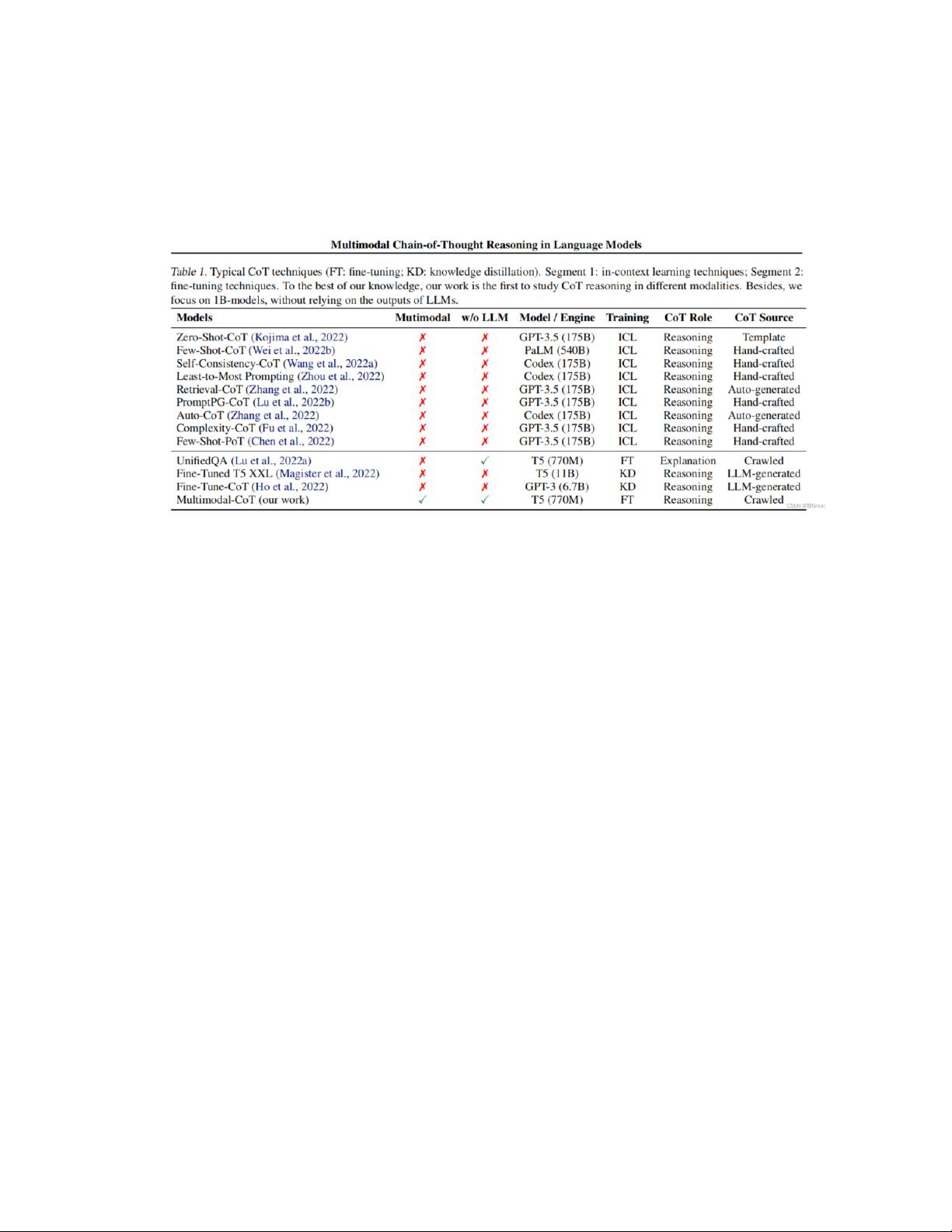

文章特别提到了几种COT的技术实现,如Zero-Shot-CoT、Few-Shot-CoT、Manual-CoT和Auto-CoT。Few-Shot-CoT依赖于高质量的演示样本,但样本质量对结果影响显著。为了改善这一点,研究者引入了Auto-CoT,这是一种自动调整演示选择过程的方法,以及强化学习(RL)和多模态思维链推理策略,这些方法已经在GPT-3.5等大型语言模型中展现了有效性。

优化推理链是提升COT效果的关键,文章提到一种常见的方法是问题分解,即将复杂问题拆分成多个小问题,这样模型可以逐个解决,降低了难度。此外,文章还可能讨论了如何通过调整模型的输入结构、调整训练策略或者结合其他技术(如元学习或迁移学习)来进一步增强小模型在推理任务上的表现。

这份教程和竞赛资料为Kaggle上的参与者提供了宝贵的策略和技巧,帮助他们利用有限的参数资源,通过巧妙地利用COT技术,挑战并超越更大规模的模型如GPT3.5,提升了在推理类竞赛中的竞争力。对于任何关注AI竞赛、尤其是NLP领域的专业人士来说,这份资源都是不可多得的学习和参考材料。

1094 浏览量

345 浏览量

2056 浏览量

2023-06-30 上传

131 浏览量

345 浏览量

白话机器学习

- 粉丝: 1w+

最新资源

- VB+SQL Server教师工资管理系统的源代码与部署指南

- 美女桌面图标集锦,性感风格一键下载

- 剑子店开源中文词典项目介绍

- AngularJS CRUD示例: 前端框架的应用演示

- 初学者入门:构建简单选课系统

- 简易物体检测识别python源代码实现

- Windows Server 2008 AD回收站工具:快速恢复被删除对象

- 电脑桌面素描图标素材下载推荐

- ComponentArt WebChart 2007.1.1171 ASP.NET控件发布与授权

- 《易学C++》电子教案全解析:教你轻松掌握C++

- BoilsoftVideoSplitterPortable:无需安装的视频剪切利器

- Java到C#代码转换详解

- MTK6235多号码电话本备份工具下载与使用体验

- 卡通头像桌面图标精选集下载

- 汇编程序设计:实现学生成绩与名次显示系统

- tiny4412板Android LED HAL示例教程与源码