深度学习模型压缩:二值化、三值化与INQ解析

需积分: 38 200 浏览量

更新于2024-09-08

收藏 429KB PPTX 举报

本资源是一份关于神经网络模型压缩技术的PPT总结,涵盖了理论介绍以及几种具体的压缩方法,如二值化网络(BWN)、三值化网络(TWN)、动态网络剪枝(DNS)和渐进式网络量化(INQ),特别提到了在移动计算领域受欢迎的MobileNet_v2的结构特点。

深度学习模型通常具有庞大的参数量,这不仅增加了计算成本,也对硬件设备的存储提出了高要求。因此,模型压缩成为了优化模型效率的关键技术。这份资料详细讲解了以下几种压缩方法:

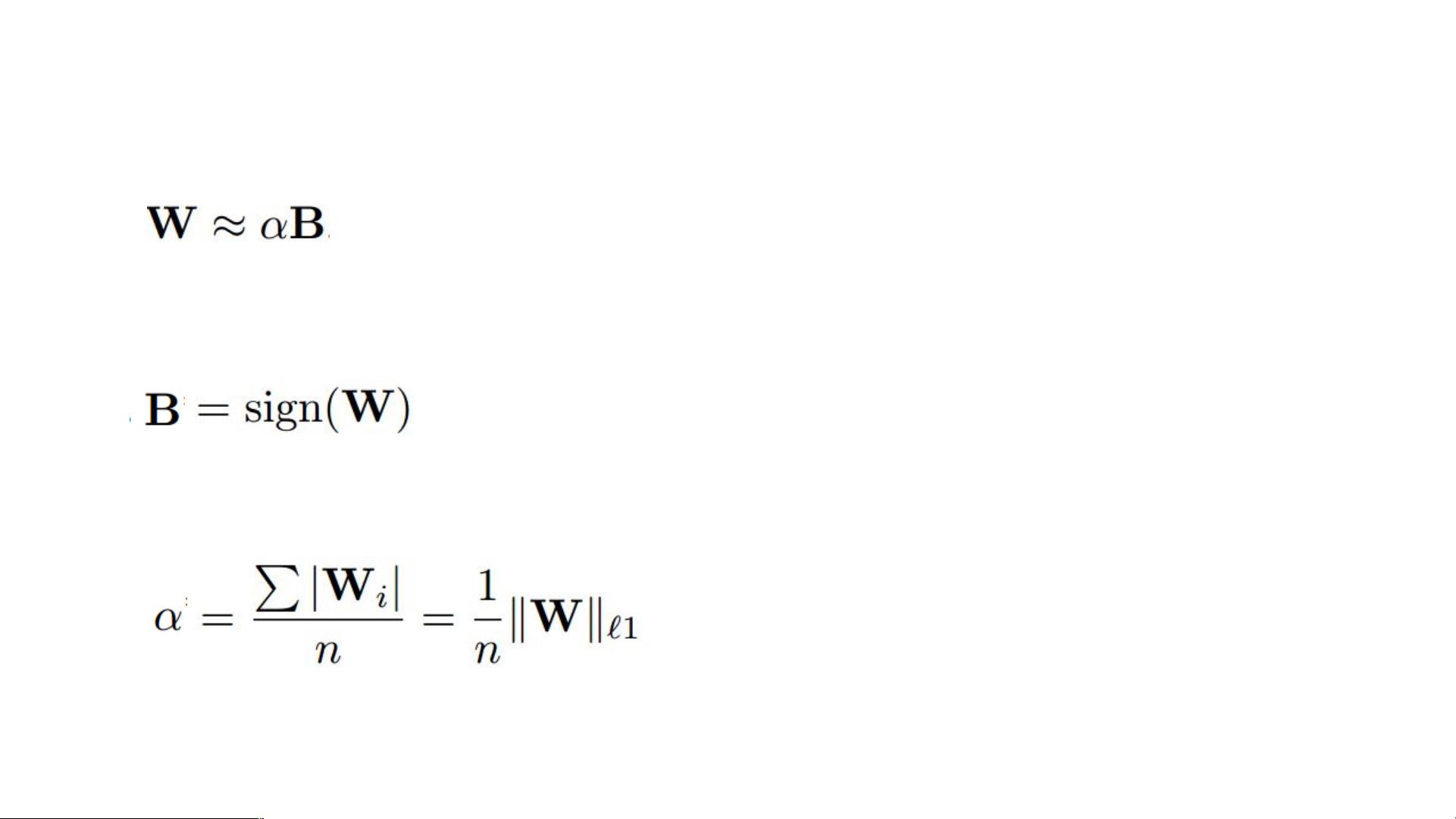

1. **二值化网络(Binary Weight Networks, BWN)**:该方法将权重二值化,即权重被简化为+1或-1,通过引入补偿系数来保留模型的准确性。二值化的阈值设为0,大于0的权重映射为+1,小于0的权重映射为-1。补偿系数是原始权重的L1范数除以非零权重的数量,用于弥补二值化带来的信息丢失。

2. **三值化网络(Ternary Weight Networks, TWN)**:不同于BWN,TWN将权重三值化,即权重变为+1, 0或-1。阈值设定为权重均值和L1范数的平均值乘以0.7。三值化后的补偿系数是原始权重中非零项的和,除以非零项的个数。

3. **动态网络剪枝(Dynamic Network Surgery, DNS)**:DNS通过删除对模型性能影响较小的参数来实现模型压缩,同时保持模型的准确度。具体操作流程包括参数分组、量化和重训练,以确保在减少参数的同时,模型性能不受显著影响。

4. **渐进式网络量化(Incremental Network Quantization, INQ)**:INQ是一种逐步量化网络的方法,它在训练过程中逐步将全精度参数转化为低精度表示。通过迭代过程,一部分网络参数被量化,其余部分则继续进行训练,直到整个网络都被量化。此过程由绿色和浅紫色区域在示例图中表示。

5. **MobileNet_v2**:这是深度学习中一种轻量级模型,主要由两种类型的块构成:stride=1的块和stride=2的块。前者采用了残差结构,而后者用于减小特征图的尺寸。MobileNet_v2的关键创新是“倒残差”结构,通过1x1卷积调整通道数量,并利用深度可分离卷积(Depthwise Separable Convolution)降低计算复杂度。这种结构使得模型在保持高性能的同时,大幅减少了计算量和参数数量。

这份资料提供了一个简明扼要的神经网络模型压缩方法概述,适合初学者快速了解和深入研究这些技术。对于想要优化深度学习模型效率,特别是在资源有限的设备上部署模型的开发者,这些方法具有重要的实践价值。

2020-04-02 上传

2018-06-13 上传

2021-03-29 上传

2021-04-30 上传

2021-02-16 上传

2021-05-23 上传

2021-05-17 上传

2021-07-11 上传

2021-04-10 上传

andeyeluguo

- 粉丝: 694

- 资源: 32

最新资源

- sthcraftue:STHCcraft

- icojs:一个用于解析ICOJavaScript库

- SimpleToDo:使用Android Studio创建简单的待办事项列表

- Chronicle-Queue-Demo:编年史队列的示例程序

- 基于STM32的电子设计应用超声波测距仪的设计.rar

- 创业计划书-装修公司推广方案

- weixin093南宁周边乡村游微信小程序+ssm(源码+部署说明+演示视频+源码介绍+lw).rar

- 基于android开发的天气预报app,网上学习制作

- 易语言中秋祝福源码.zip

- regtlib.exe

- Linux 脚本部署 Kubernetes

- doi_serv:该Web应用程序是一项简单的服务,它查看id参数并返回mgi_logo.png图片id,该参数的值包含在ftp报告MGI_Elsevier.rpt中。

- Python库 | flask-utilities-0.2.tar.gz

- weixin007医院管理系统+Springboot(源码+部署说明+演示视频+源码介绍+lw).rar

- 施工管理资料表格-D0401_线路(设备)绝缘电阻测试记录

- 基于SpringBoot+Java开发的微服务小说网站后端源码+数据库+项目说明.7z