使用BERT进行短文本二分类:推荐评论挖掘

30 浏览量

更新于2024-08-29

1

收藏 204KB PDF 举报

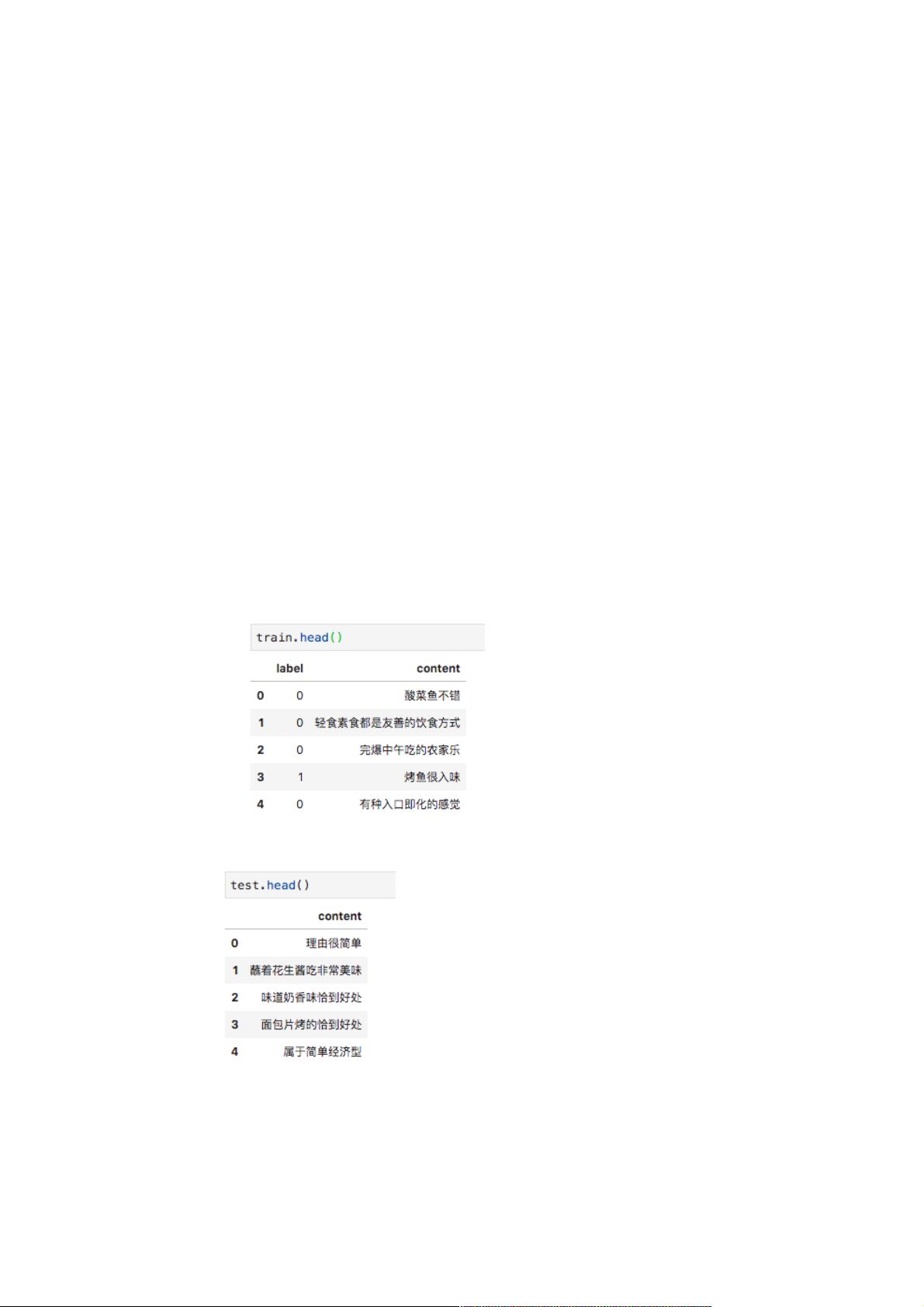

该资源是一个关于短文本二分类问题的教程,主要目标是从用户评论中挑选出适合作为推荐理由的短句。任务涉及到的是自然语言处理中的文本分类,特别是情感分析的应用。数据集包含训练集和测试集,用于评估模型的性能。评估指标为AUC(Area Under the Curve)。在解决这个问题时,提到了使用BERT模型作为主要的解决方案,因为BERT在处理这类任务上表现出色。在Keras框架中实现BERT模型,并结合全局平均池化和最大池化等技术来提取特征。

详细知识点:

1. **文本分类**:这是自然语言处理的一个重要任务,旨在将文本分为预定义的类别。在这个场景中,分类目标是确定评论是否适合作为推荐理由。

2. **二分类问题**:该任务是一个二分类问题,因为评论被分为两个类别,即适合展示和不适合展示作为推荐理由。

3. **背景描述**:任务的背景是在线点评软件,需要筛选出吸引人的、内容相关的短评论用于展示,这要求模型能理解评论的情感倾向和内容相关性。

4. **数据集**:数据集包含训练集和测试集,用于模型训练和性能评估。测试集有4189条数据。

5. **AUC(Area Under the Curve)**:AUC是ROC曲线下的面积,是衡量二分类模型性能的重要指标,尤其在不平衡数据集的情况下,能更好地反映模型的区分能力。

6. **ML/DL的前提假设**:机器学习和深度学习模型的性能依赖于训练集和测试集的独立同分布假设,即训练数据和测试数据应来自同一分布,确保模型泛化能力。

7. **文本长度分析**:在实践中,通过计算文本长度检查训练集和测试集的分布,以确认它们是否满足独立同分布的假设。这里的分析表明,长度不是决定分类的重要特征。

8. **BERT模型**:BERT(Bidirectional Encoder Representations from Transformers)是一种预训练的Transformer架构模型,擅长处理自然语言理解任务,包括文本分类。在本任务中,BERT用于提取评论的语义信息。

9. **Keras框架**:Keras是一个高级神经网络API,用于构建和训练深度学习模型。在本案例中,Keras与BERT库结合,用于构建和训练模型。

10. **池化操作**:全局平均池化和最大池化是常用的深度学习技术,用于减少序列数据的维度并保留关键信息。在这儿,它们用于从BERT的输出中提取特征。

11. **SeqSelfAttention**:这是一个Keras自注意力层,可能用于增强模型对序列内部关系的理解,但在这个例子中,没有详细说明如何应用。

12. **[CLS] token**:BERT模型的开始标记,通常用于执行分类任务,因为它捕获了整个输入序列的上下文信息。

13. **注意力得分**:BERT模型中的注意力机制允许模型关注输入序列的不同部分,这对于理解和分类评论可能是有益的。

这个教程提供了一个使用BERT进行短文本二分类的实例,对于理解如何利用预训练模型解决实际问题具有指导意义。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-06-24 上传

2021-10-08 上传

2021-08-07 上传

2020-11-19 上传

2021-09-18 上传

2021-09-18 上传

weixin_38646706

- 粉丝: 4

- 资源: 1005