聚类算法详解:基于划分的方法与K-Means

需积分: 0 131 浏览量

更新于2024-08-05

收藏 1.07MB PDF 举报

"聚类算法是无监督学习的一种方法,旨在将数据集中的对象根据相似性归类,使得同一类内的对象相似度高,类间差异性大。主要分为基于划分、层次、密度、网格、模型和模糊六种方法。本文重点关注基于划分的聚类算法,特别是k-means算法及其变种。

1. 基于划分的聚类:这种算法首先确定聚类的数量,然后选择初始中心点,通过迭代更新中心点直至达到稳定状态。k-means是最典型的代表,其时间复杂度为O(nkt),n为对象数量,k为簇数,t为迭代次数。k-means变种包括k-medoids、k-modes、k-medians和kernel k-means等。

2. 距离度量:在聚类中,样本之间的相似度通常通过距离来衡量。常见的距离度量方法包括:

- 闵可夫斯基距离(Minkowski Distance):p=1对应曼哈顿距离,p=2对应欧式距离,p趋于无穷大则为切比雪夫距离。欧式距离广泛使用,但对异常值敏感。在数据分布不均匀时,可以考虑使用曼哈顿或切比雪夫距离。

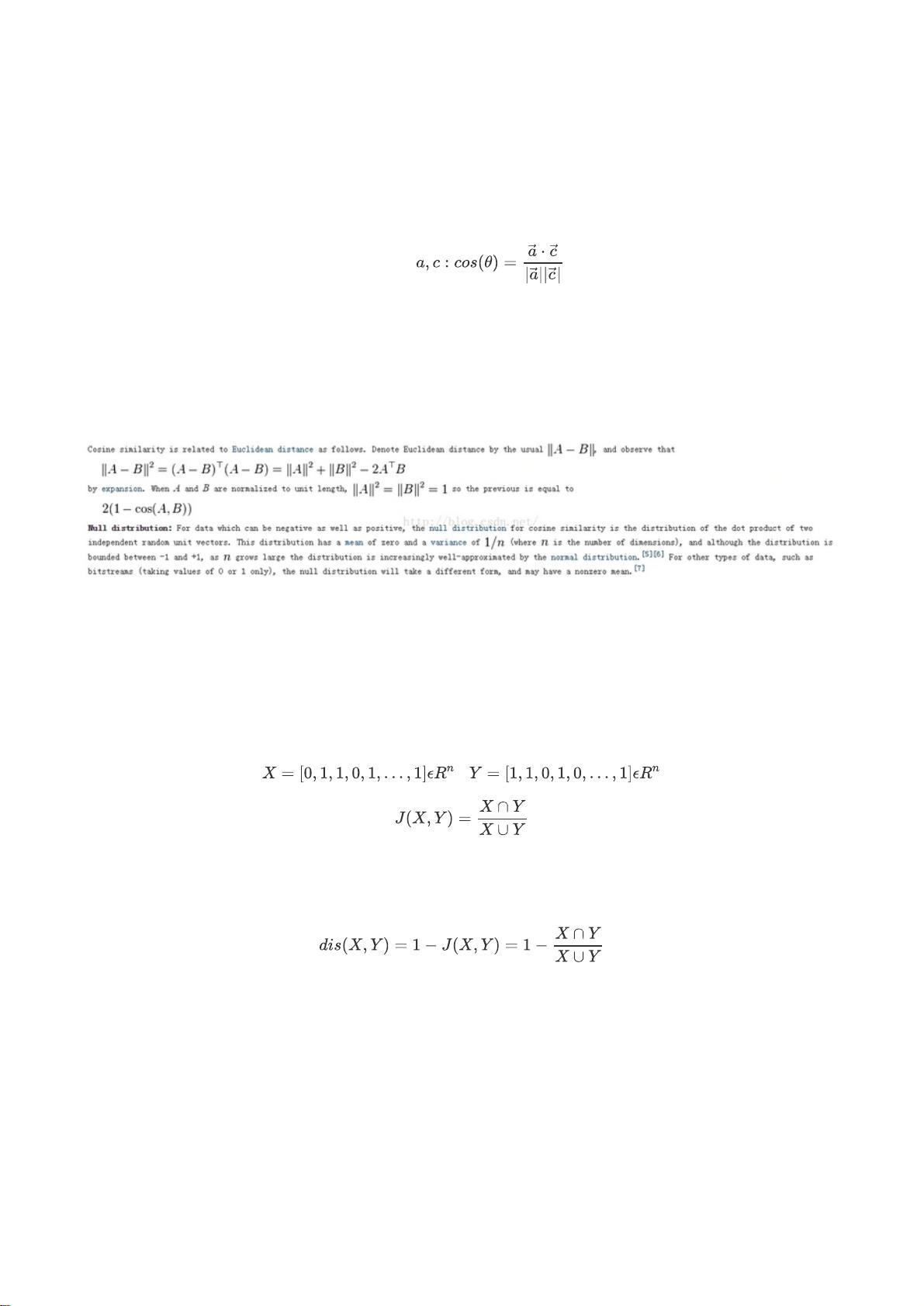

- 夹角余弦相似度:衡量两个向量在多大程度上指向相同的方向,值域在-1到1之间,1表示完全相同,-1表示方向完全相反。

- 杰卡德相似系数与距离(Jaccard Similarity and Distance):常用于衡量集合间的相似性,适用于处理稀疏数据。

3. 数据预处理:在计算距离之前,可能需要对数据进行标准化处理,如z-score标准化,即将每个特征减去其均值,除以其标准差,以消除不同特征尺度的影响,使各维度具有可比性。

k-means算法流程如下:

1. 初始化:选择k个初始质心(中心点)。

2. 分配:将每个数据点分配到最近的质心所在的簇。

3. 更新:重新计算每个簇的质心,即簇中所有点的平均值。

4. 重复步骤2和3,直到质心不再显著移动或达到预设的最大迭代次数。

4. 局限性:k-means算法有一些局限,例如对初始质心的选择敏感,可能陷入局部最优解;对于非凸形状的簇识别能力有限;需要预先设定簇的数量k,这在实际应用中往往未知。

5. 解决策略:可以通过多次运行k-means并选择最优结果,或者使用更复杂的变体如DBSCAN(基于密度的聚类)来应对非凸簇。对于k值的选取,可以尝试Elbow Method或Silhouette Method等方法进行评估。

聚类算法是数据分析的重要工具,尤其在数据探索和模式识别阶段。理解各种距离度量方法和算法的优缺点,有助于选择合适的聚类策略,提高数据分析的准确性和有效性。"

953 浏览量

608 浏览量

1431 浏览量

2022-08-04 上传

182 浏览量

207 浏览量

2615 浏览量

194 浏览量

东方捕

- 粉丝: 22

最新资源

- Subclipse 1.8.2版:Eclipse IDE的Subversion插件下载

- Spring框架整合SpringMVC与Hibernate源码分享

- 掌握Excel编程与数据库连接的高级技巧

- Ubuntu实用脚本合集:提升系统管理效率

- RxJava封装OkHttp网络请求库的Android开发实践

- 《C语言精彩编程百例》:学习C语言必备的PDF书籍与源代码

- ASP MVC 3 实例:打造留言簿教程

- ENC28J60网络模块的spi接口编程及代码实现

- PHP实现搜索引擎技术详解

- 快速香草包装技术:速度更快的新突破

- Apk2Java V1.1: 全自动Android反编译及格式化工具

- Three.js基础与3D场景交互优化教程

- Windows7.0.29免安装Tomcat服务器快速部署指南

- NYPL表情符号机器人:基于Twitter的图像互动工具

- VB自动出题题库系统源码及多技术项目资源

- AndroidHttp网络开发工具包的使用与优势