Apache Kylin 3.0新特性:使用Livy优雅管理Spark任务

186 浏览量

更新于2024-09-02

收藏 565KB PDF 举报

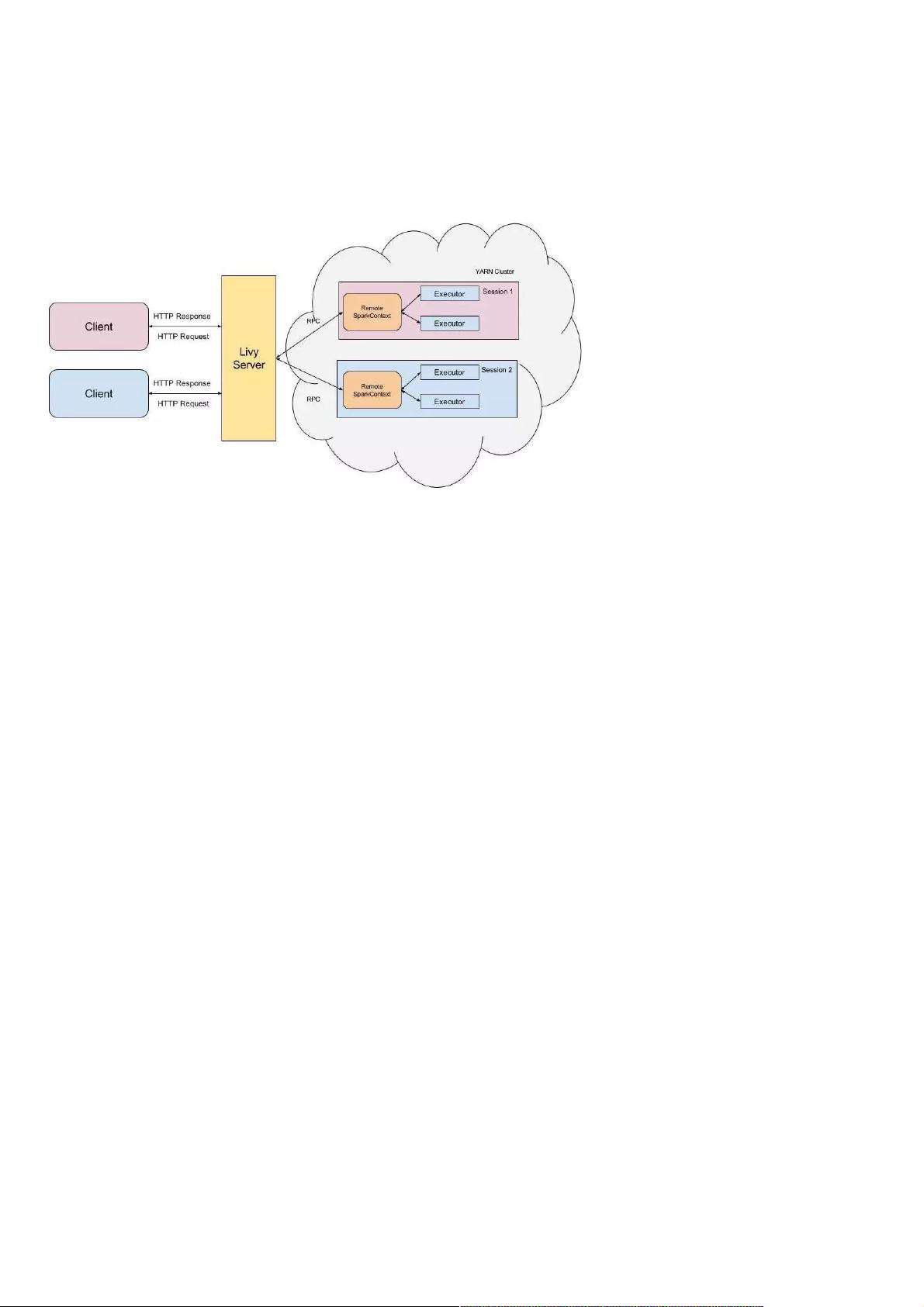

"Apache Kylin 3.0版本引入了使用Apache Livy递交Spark任务的功能,解决了用户在使用Spark时遇到的任务提交问题和构建节点稳定性问题。Apache Livy是一个基于Spark的开源REST服务,允许通过REST接口提交代码片段或序列化二进制代码到Spark集群执行,提供对Scala、Python和R语言的支持。使用Livy可以解决Spark的交互式处理和批处理方式带来的如资源负担、单点故障和管理不便等问题。Livy作为中间层,能减轻Gateway节点压力,支持远程提交和管理Spark任务,且便于集成审计和权限管理工具,如Apache Knox。"

Apache Kylin是一款开源的分布式分析型数据库,设计用于大数据分析,提供亚秒级的查询性能。在Kylin中优雅地使用Spark涉及到如何有效地利用Spark处理大规模数据。在传统的Spark使用中,用户通常需要直接在Gateway节点上提交和管理任务,这可能导致资源过度消耗和故障风险增加。Apache Livy作为解决方案,它作为一个RESTful服务,提供了一个安全、可扩展的途径,使得用户可以通过网络远程提交Spark作业,降低了对Gateway节点的依赖。

Livy的核心特性包括:

1. **代码片段提交**:用户可以提交Scala、Python或R的代码片段,Livy会将这些代码发送到Spark集群执行。

2. **Spark作业提交**:Java、Scala、Python编写的Spark作业可以通过Livy提交到远端集群,无需直接在Gateway节点执行。

3. **作业管理和监控**:Livy管理所有由用户启动的Spark任务,提供了状态查询、日志查看等功能。

4. **安全性与集成**:Livy支持身份验证和授权,方便与现有系统(如Apache Knox)集成,提供更好的安全性和审计能力。

通过集成Livy,Apache Kylin 3.0版本增强了其Spark任务的提交和管理体验,降低了系统的复杂性,提高了系统的稳定性和可靠性。这使得Kylin用户能够更高效、安全地处理大数据分析任务,避免了直接操作Spark集群可能带来的问题,同时提升了整体的运维效率。在实际应用中,开发人员和数据分析师可以利用这一特性,更便捷地构建和运行复杂的分析模型,进一步提升大数据分析的速度和质量。

2017-05-16 上传

2023-09-01 上传

2018-03-12 上传

2022-02-25 上传

161 浏览量

点击了解资源详情

weixin_38685608

- 粉丝: 1

- 资源: 995

最新资源

- upptime-test:Kar Karan Kale的正常运行时间监控器和状态页面,由@upptime提供支持

- Practica:数据清洗与分析

- 渣浆泵过流部件的生产实践.rar

- Newsletter-Signup-Web-App:在Node中使用MailChimp API服务制作的Newsletter注册Web应用程序

- 使用SpringBoot + SpringCloudAlibaba(正在重构中)搭建的金融类微服务项目-万信金融. .zip

- 西安交大电力系统分析视频教程第27讲

- MDIN3xx_mainAPI_v0.2_26Aug2011.zip

- hibernate,java项目源码,java中如何查看方法的

- 七段图像创建:非常灵活的功能,您可以创建任意大小的七段图像。-matlab开发

- cv

- OnePortMeas:适用于一端口RF设备表征的Python App

- java,java源码网站,javaunsafe

- 网址状态

- 网络时间同步工具 NetTime 3.20 Alpha 3.zip

- css-grid-course

- Python库 | clay-3.2.tar.gz