大规模数据处理:Apache Spark与MapReduce

"Data.Algorithms" 由 Mahmoud Parsian 编著,主要探讨在大数据时代高效、可扩展和并行的算法需求。随着搜索引擎、基因组分析和社交媒体等领域的数据量爆炸式增长,处理这些数据的计算能力需要大幅度提升。MapReduce 框架应运而生,它为处理大规模(吉字节、太字节或拍字节)数据集提供了并行和分布式处理的方法。本书重点关注 Apache Spark 和 MapReduce/Hadoop 实现,通过实例来教授如何在这两个平台上实现 MapReduce。

MapReduce 是一种软件框架,旨在在商品服务器集群上对大型数据进行大规模数据处理。它包括两个主要阶段:Map 阶段和 Reduce 阶段。Map 阶段将输入数据分割成独立的键值对,并将其分发到集群中的各个节点进行处理;Reduce 阶段则负责收集 Map 阶段的结果,对相同键的数据进行聚合,生成最终结果。这种模型使得数据处理能够充分利用分布式计算资源,处理海量数据。

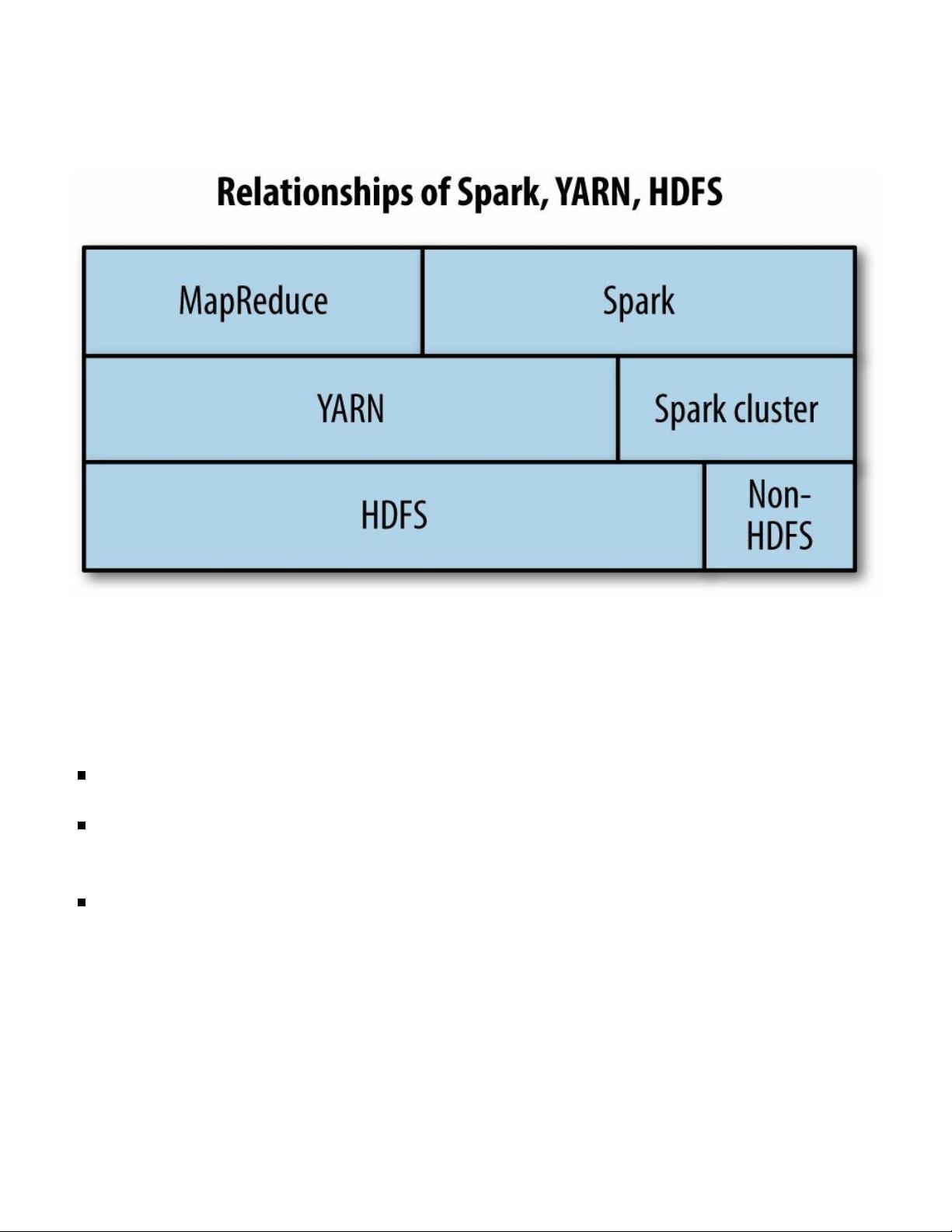

Apache Spark 是一个快速、通用且可扩展的大数据处理系统,它支持内存计算,提高了数据处理速度。Spark 提供了一个高级 API,使得开发人员可以更容易地编写分布式应用程序。Spark 的弹性分布式数据集 (RDD) 是其核心概念,它是不可变、分区的数据集合,可以在集群中并行操作。Spark 还包含对 SQL 查询的支持(Spark SQL)、流处理(Spark Streaming)和机器学习库(MLlib),提供了一站式的数据分析解决方案。

Hadoop 是另一种广泛使用的开源大数据处理框架,主要由 HDFS(Hadoop 分布式文件系统)和 MapReduce 组件组成。HDFS 提供高容错性的数据存储,而 MapReduce 则负责数据处理。Hadoop 的设计目标是处理PB级别的数据,适合批处理任务。

本书将介绍如何在 Spark 和 Hadoop 上编写 MapReduce 程序,帮助读者理解并应用这些工具处理大数据问题。内容涵盖了从基本概念到实际编程技巧,旨在让读者能够熟练掌握大数据处理技术。此外,书中可能还包含了错误检查和修订历史,以确保信息的准确性。

"Data.Algorithms" 是一本面向 IT 专业人士的指南,涵盖了大数据处理的关键算法和框架,对于那些希望在大数据领域深化理解和实践的开发者来说,是一本重要的参考书。通过学习本书,读者可以了解到如何利用 MapReduce 和 Spark 处理海量数据,提升数据处理效率,为现代数据分析和挖掘工作奠定坚实基础。

116 浏览量

178 浏览量

156 浏览量

182 浏览量

196 浏览量

2007-12-04 上传

172 浏览量

219 浏览量

250 浏览量

此人没有昵称

- 粉丝: 0

最新资源

- C#实现DataGridView过滤功能的源码分享

- Python开发者必备:VisDrone数据集工具包

- 解决ESXi5.x安装无网络适配器问题的第三方工具使用指南

- GPRS模块串口通讯实现与配置指南

- WinCvs客户端安装使用指南及服务端资源

- PCF8591T AD实验源代码与使用指南

- SwiftForms:Swift实现的表单创建神器

- 精选9+1个网站前台模板下载

- React与BaiduMapNodejs打造上海小区房价信息平台

- 全面解析手机软件测试的实战技巧与方案

- 探索汇编语言:实验三之英文填字游戏解析

- Eclipse VSS插件版本1.6.2发布

- 建站之星去版权补丁介绍与下载

- AAInfographics: Swift语言打造的AAChartKit图表绘制库

- STM32高频电子线路实验完整项目资料下载

- 51单片机实现多功能计算器的原理与代码解析