理解支持向量机:线性与非线性分类的策略

需积分: 0 182 浏览量

更新于2024-08-04

收藏 833KB DOCX 举报

"第六章 支持向量机1"

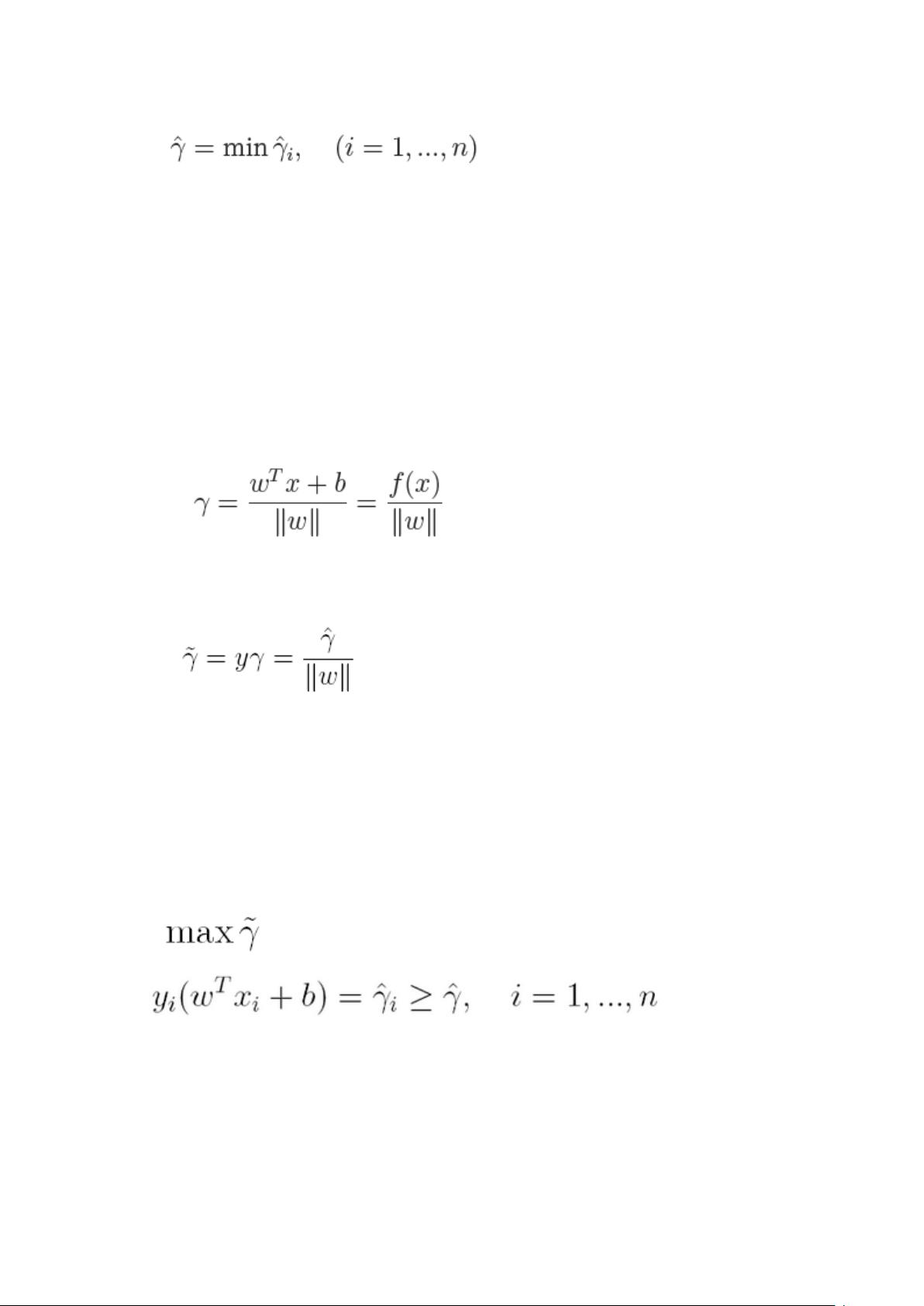

支持向量机(SVM,Support Vector Machine)是一种广泛应用于二分类任务的监督学习模型。它的核心思想是寻找一个能够最大化类别间间隔的决策边界,这使其区别于早期的感知机模型。SVM通过引入核函数,能够处理线性不可分的数据,从而实现非线性分类。

1. 线性可分支持向量机:在数据线性可分的情况下,SVM采用硬间隔最大化的方法,寻找一个能将两类数据完全分开且具有最大间隔的超平面。这种模型是理想的分类器,但对噪声和异常点非常敏感。

2. 线性支持向量机:面对近似线性可分的数据,SVM采用软间隔最大化,允许一定数量的数据点落在决策边界内部,以增加模型的鲁棒性和泛化能力。这种模型被称为软间隔支持向量机。

3. 非线性支持向量机:对于线性不可分的数据,SVM利用核函数技术,将低维度的输入空间映射到高维度的特征空间,使得在特征空间中的数据变得线性可分。常见的核函数有多项式核、高斯核(径向基函数RBF)和sigmoid核等。核函数的选择直接影响模型的性能和复杂度。

4. 学习策略与优化目标:SVM的学习目标是找到一个最大化间隔的超平面,这通常转化为一个凸二次规划问题,或者等价于最小化正则化的合页损失函数。合页损失函数允许一定程度的误分类,同时鼓励大间隔。

5. 支持向量:在SVM中,距离超平面最近的训练样本点被称为支持向量,它们对决策边界的位置起决定性作用。只有支持向量参与了模型的构建,使得SVM在样本量大的情况下仍能保持高效。

6. 核技巧:核函数是SVM的关键,它使得在原始输入空间难以解决的非线性问题在高维特征空间中得以简化。核函数的选择直接影响模型的性能,需要根据具体问题选择合适的核函数。

7. 最优化算法:SVM的学习算法通常基于梯度下降法或 Cutting Plane Algorithm 等最优化方法,寻找最优的超平面。

支持向量机是一种灵活且强大的机器学习工具,通过间隔最大化和核函数的使用,能够处理各种复杂的分类问题。理解并正确选择核函数以及调整模型参数是应用SVM时需要关注的重点。

点击了解资源详情

118 浏览量

129 浏览量

2022-08-03 上传

2024-12-30 上传

2022-01-18 上传

328 浏览量

2023-08-06 上传

2023-09-02 上传

吉利吉利

- 粉丝: 29

- 资源: 308

最新资源

- yolov3 yolov3-tiny yolov4 yolov-tiny预训练模型下载

- TCSC.zip_tcsc simulink_无功补偿_电力 补偿_电容器_电容器补偿

- fs-family:已弃用:显示一对夫妇,并可以选择加载和显示该夫妇的孩子

- github-upload

- Open-Myo:使用通用BLE接口从Myo臂章获取数据的Python模块

- D3-React-Patterns:各种技术和模式的集合,用于在较大的React框架内组织D3项目。 这将是任何人都可以参与的公开回购,更多细节可以在DVS松弛中找到。

- Yolov5-master.zip

- RoboSpice-samples:RoboSpice库的所有样本

- ExtremeSpaceCombat:带有太空飞船的Java游戏

- 学生管理系统源码.zip

- FurniTale::no_entry:种族关系进展

- 捷德

- Trapped

- 高斯白噪声matlab代码-PE-GAMP:带有内置参数估计的通用近似图像消息传递

- 安卓Android活动社交仿QQ聊天app设计

- sdnotify-proxy:在不同cgroup中的systemd和进程之间代理sd_notify消息