对抗训练与半监督提升模型鲁棒性:FGSM、VAT、FGM代码解析

版权申诉

163 浏览量

更新于2024-08-07

收藏 1.96MB DOC 举报

"小样本利器2.文本对抗+半监督FGSM&VAT&FGM代码实现"

在本文档中,作者探讨了如何利用对抗训练和半监督学习提高模型在小样本情况下的鲁棒性。重点集中在Fast Gradient Sign Method (FGSM),Virtual Adversarial Training (VAT) 和 Fast Gradient Method (FGM) 这三种方法的代码实现,特别是在自然语言处理(NLP)和计算机视觉(CV)领域的应用。

1. 对抗样本的存在性与对抗训练的有效性

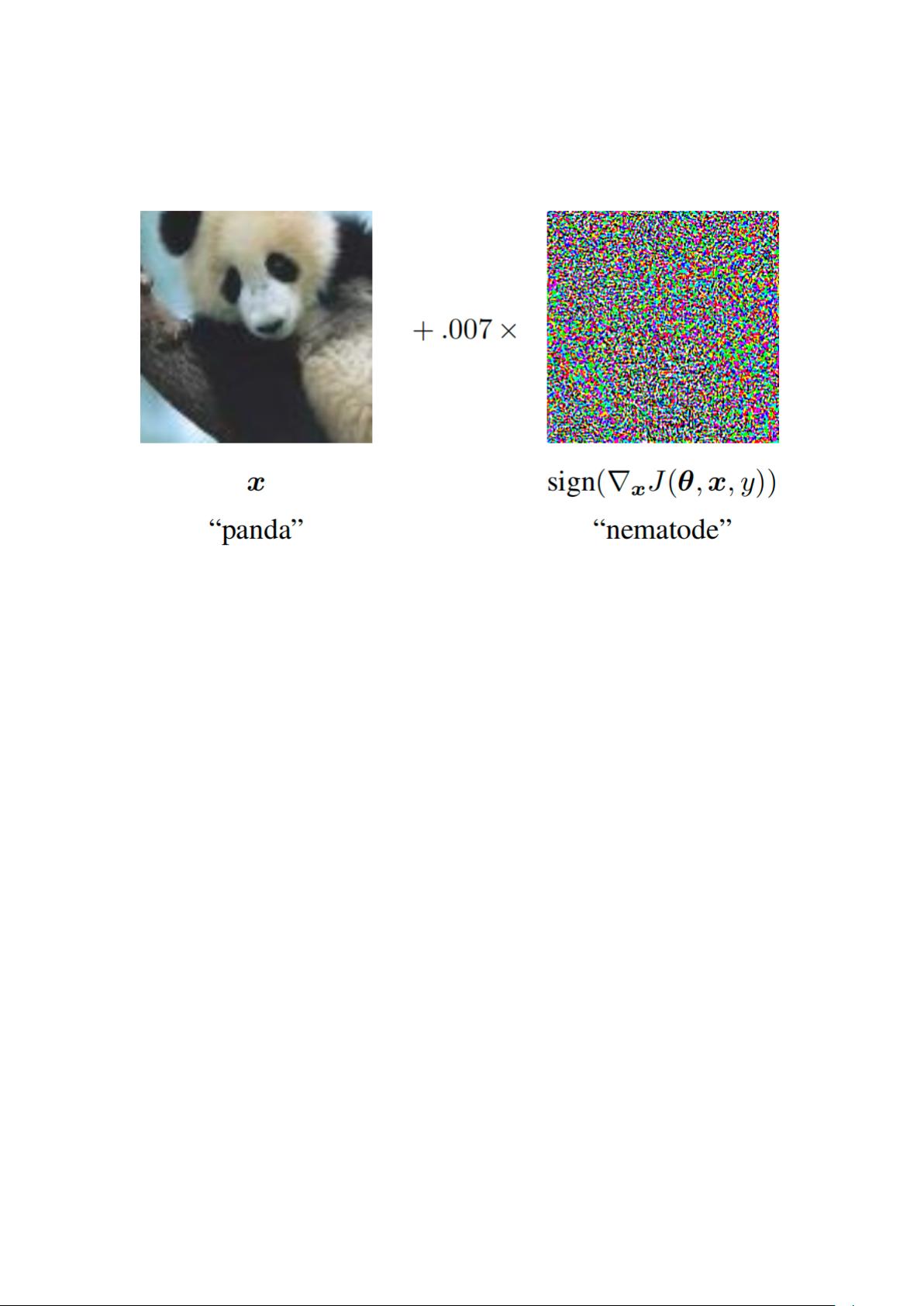

对抗样本是由于模型对输入数据的过度拟合导致的,即使微小的输入扰动也可能导致模型预测结果的巨大变化。FGSM揭示了这种现象,并提出通过对抗训练来增强模型的鲁棒性,即在训练过程中,人为制造对抗样本以使模型能够正确处理这些扰动。

2. 对抗训练实现方案

对抗训练的基本思想是在模型训练中加入对抗性扰动,目的是使模型在受到小幅度扰动的样本上也能做出正确的预测。这与生成对抗网络(GANs)中的对抗训练有所不同,后者是生成器和判别器之间的博弈。在CV领域,对抗扰动可能非常微小,以至于人眼无法察觉。在训练过程中,通过最大化的损失函数找到扰动,并以最小化损失为目标进行训练。

3. FGM与VAT

FGM是一种用于NLP的对抗训练方法,它基于梯度的方向来生成对抗样本,通过反向传播中的学习率来控制扰动大小,确保扰动在微小范围内。VAT则是一种用于CV的对抗训练方法,强调的是模型的局部平滑性,通过最大化局部扰动来改进模型。

4. 半监督学习与一致性正则化

除了对抗训练,文档还提到了使用半监督学习提升小样本模型性能的方法,特别是通过一致性正则化,利用大量未标注数据来引导模型学习更稳健的表示。这种方法可以与对抗训练相结合,进一步提高模型的泛化能力和鲁棒性。

5. 代码实现

文档中提供的代码实现了FGSM、VAT和FGM,适用于TensorFlow框架,这对于研究人员和开发者来说是一个宝贵的资源,可以帮助他们在实际项目中应用这些技术。

总结来说,这份文档深入介绍了对抗训练和半监督学习在小样本问题上的应用,结合了CV和NLP领域的实践,提供了具体的技术实现,对于想要增强模型鲁棒性和泛化能力的研究者和工程师具有很高的参考价值。

1423 浏览量

2024-07-10 上传

2024-07-10 上传

2129 浏览量

508 浏览量

666 浏览量

121 浏览量