深度残差网络中的恒等映射:ResNet-v2提升精度与效率

33 浏览量

更新于2024-08-30

收藏 825KB PDF 举报

"《翻译 – ResNet-v2 – 残差网络中的恒等映射》

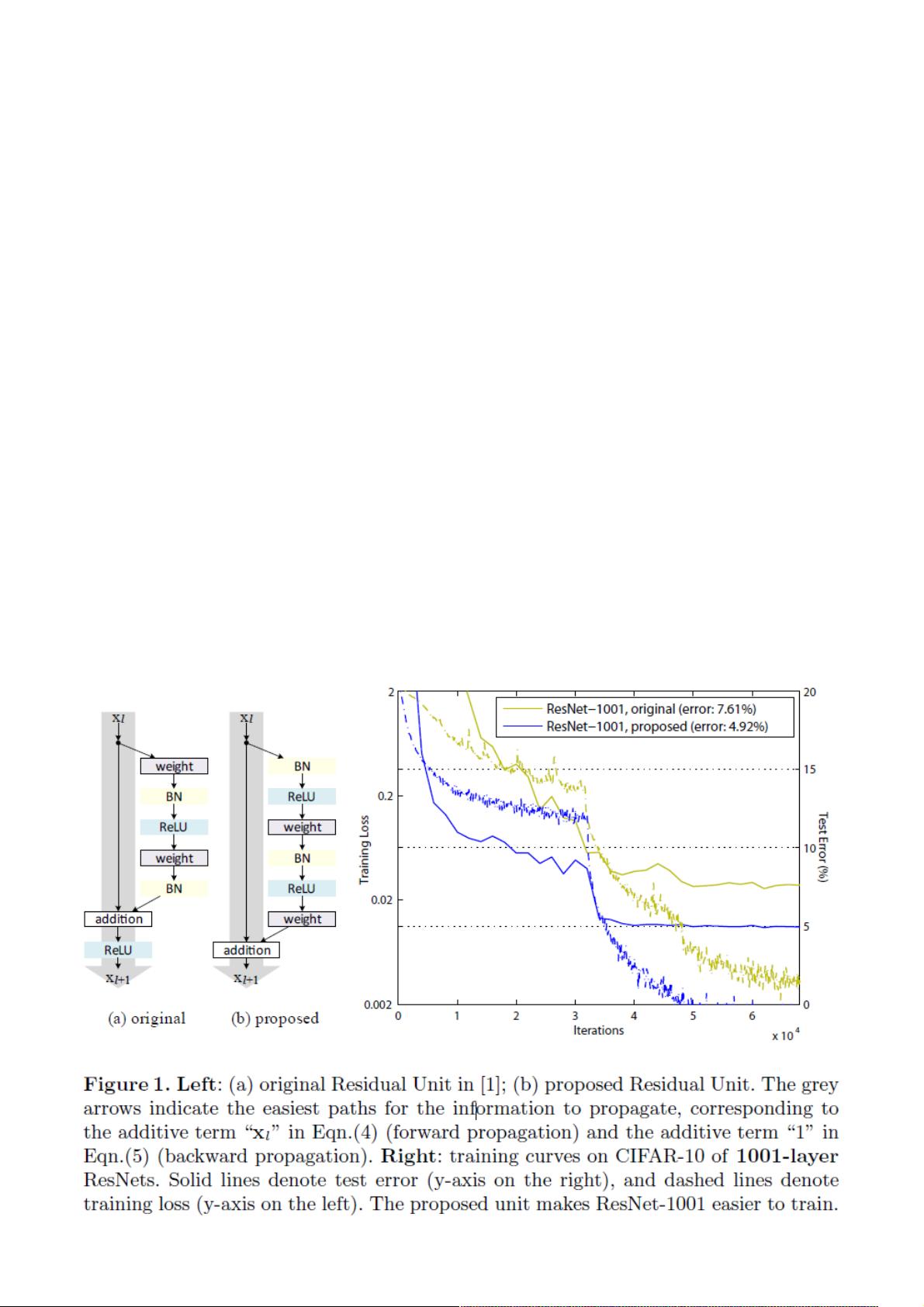

深度残差网络(Residual Networks, ResNets)因其在深度学习领域的卓越表现而受到广泛关注。这篇论文深入探讨了ResNet-v2设计中的一个重要组成部分——恒等映射(Identity Mappings)在深层网络中的作用。作者首先指出,在ResNet的构造块中,当跳跃连接(Skip Connections)和附加激活函数都采用恒等映射时,前向和反向信号可以无阻地从一个单元传播到整个网络的任意位置。这种特性使得深层网络的训练变得更加有效,并有助于保持梯度的稳定,从而改善模型的泛化能力。

论文通过实验验证了恒等映射的重要性,它不仅是训练过程中的稳定器,而且能够简化网络结构,使得网络更容易学习。作者因此提出了一种新的残差单元设计,它在保留恒等映射的同时,优化了网络架构,提升了整体性能。具体成果体现在他们在CIFAR-10和CIFAR-100数据集上使用1001层ResNet模型取得了4.62%的错误率,以及在ImageNet竞赛中使用200层ResNet模型所展现的优秀识别性能。

深度ResNets在ImageNet和MSCOCO等多个挑战性识别任务上的成功,归功于其核心思想,即学习一个额外的残差函数,这个函数的目标是逼近恒等映射h(x),而不是完全替代它。通过这种方式,ResNets能够处理更深的网络层次,避免梯度消失或爆炸问题,从而实现高效的训练和更好的结果。这篇论文强调了恒等映射在ResNet-v2架构中的关键地位,对深度神经网络的设计和优化提供了有价值的洞察。"

2021-09-14 上传

2018-08-08 上传

2021-05-31 上传

2024-10-20 上传

2023-09-17 上传

2023-09-10 上传

2023-09-17 上传

2023-03-06 上传

2023-03-17 上传

weixin_38736529

- 粉丝: 2

- 资源: 875

最新资源

- SSM动力电池数据管理系统源码及数据库详解

- R语言桑基图绘制与SCI图输入文件代码分析

- Linux下Sakagari Hurricane翻译工作:cpktools的使用教程

- prettybench: 让 Go 基准测试结果更易读

- Python官方文档查询库,提升开发效率与时间节约

- 基于Django的Python就业系统毕设源码

- 高并发下的SpringBoot与Nginx+Redis会话共享解决方案

- 构建问答游戏:Node.js与Express.js实战教程

- MATLAB在旅行商问题中的应用与优化方法研究

- OMAPL138 DSP平台UPP接口编程实践

- 杰克逊维尔非营利地基工程的VMS项目介绍

- 宠物猫企业网站模板PHP源码下载

- 52简易计算器源码解析与下载指南

- 探索Node.js v6.2.1 - 事件驱动的高性能Web服务器环境

- 找回WinSCP密码的神器:winscppasswd工具介绍

- xctools:解析Xcode命令行工具输出的Ruby库