sigmoidal神经网络逼近φ-有界变差函数:误差分析与扩展

下载需积分: 5 | PDF格式 | 299KB |

更新于2024-08-11

| 113 浏览量 | 举报

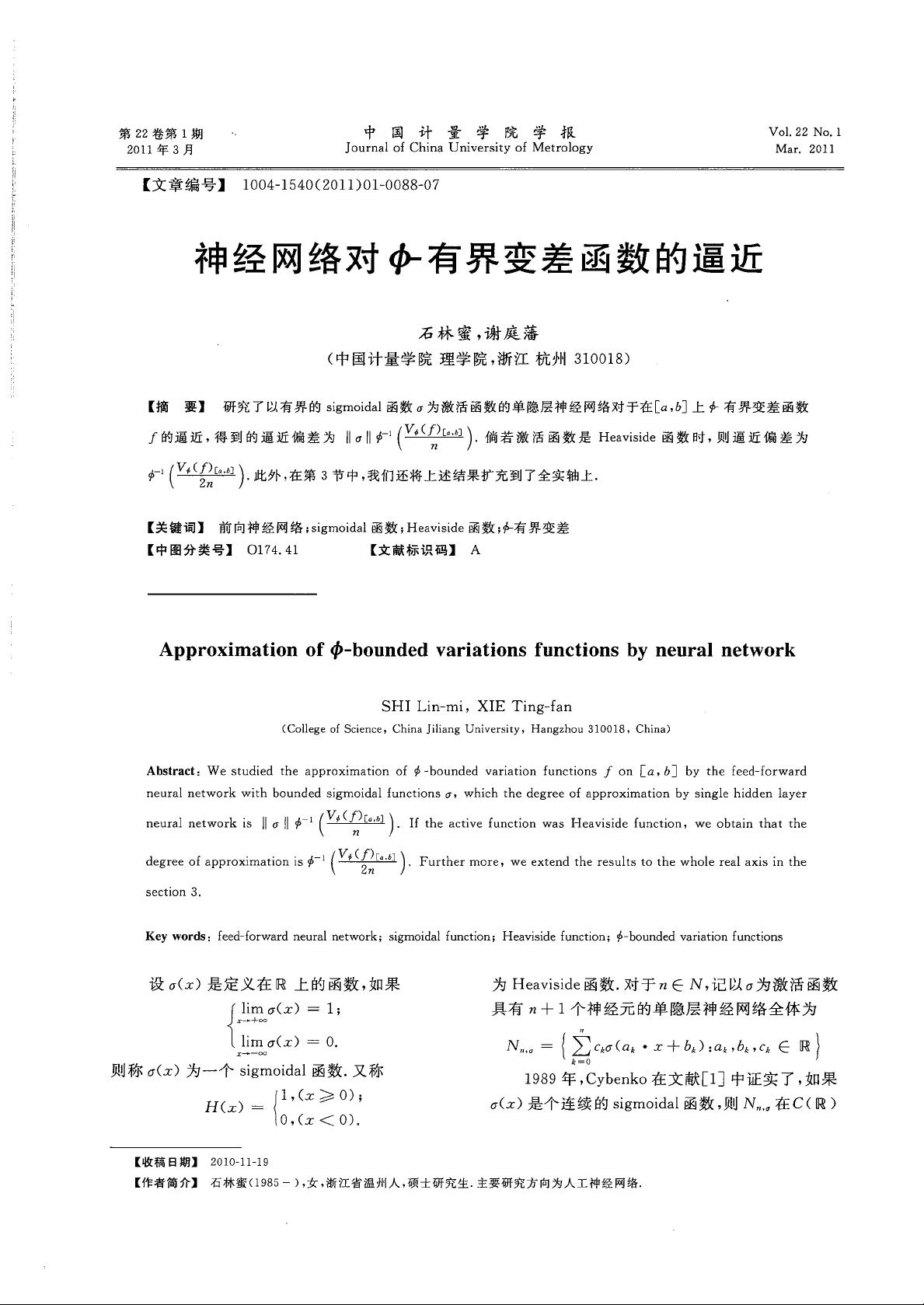

本文主要探讨了神经网络在数值分析中的应用,特别是针对在区间[a, b]上的φ-有界变差函数的逼近问题。φ-有界变差函数是一种在数学分析中具有重要意义的函数类,它描述了一类在有限区间内变化幅度受到限制的函数。作者石林蜜和谢庭藩聚焦于使用单隐藏层神经网络,其激活函数选择有界的sigmoidal函数(一种常用的连续可微非线性函数)来近似这类函数。

研究的核心内容是通过计算sigmoidal函数的性质,确定单隐藏层神经网络的逼近偏差。具体来说,当激活函数为sigmoidal函数时,神经网络的逼近偏差被量化为σ-1函数作用于函数f在区间[a, b]上的φ-有界变差减去神经元数量n后的值。这表明随着神经元的增加,网络的逼近精度会提高,与标准的误差理论相符。

值得注意的是,文章还特别提及了一个特殊情况,即当激活函数改为Heaviside函数时,逼近偏差将变为φ-1函数作用于同样差分量减去2n的结果。Heaviside函数是一种特殊的阶跃函数,其结果与sigmoidal函数相比,逼近性能有所不同。

在第三部分,作者扩展了他们的研究成果,将这些理论推广到了整个实数轴上,这意味着理论不仅限于特定的区间,而是适用于更广泛的函数空间。这是一项重要的贡献,因为它拓宽了神经网络在实际应用中的适用范围,尤其是在信号处理、图像识别等领域,可以处理更复杂、全局性的函数特性。

这篇论文提供了关于如何利用神经网络逼近φ-有界变差函数的重要理论基础,这对于理解神经网络的表达能力和优化算法设计具有深远影响。通过深入分析激活函数的选择及其对逼近精度的影响,该研究有助于提升神经网络在实际问题中的准确性和效率。

相关推荐

weixin_38580959

- 粉丝: 3

最新资源

- 扩展Brackets实现JS多行字符串格式化与取消

- Java领域DeViNT-2015-d-d项目分析

- MATLAB实现先进PID控制仿真教程与源代码下载

- 实现OpenShift自定义构建器的自动化标记

- FFmpeg安装脚本与离线包的一键解压指南

- 模拟GPS信号代码的生成与应用

- pe-epub:简化电子书制作流程

- C#实现UDP协议通信的详细步骤与代码示例

- Sakitam-cli: 快速开发Vue&React项目的脚手架工具

- GD32微控制器串口IAP升级技术解析

- QlikView OnOffSwitch 扩展:轻松以 iPad 样式切换变量

- 响应式医疗体检中心网站模板设计

- VideoControl - MATLAB开发的GUI图像采集控制工具

- 异步并发执行Ping操作:多站点高效监控技巧

- Atom编辑器的LiveStyle插件:实时CSS/LESS/SCSS编辑工具

- Andy V.开发的图像编辑器支持本地保存功能