面向对象与结构分析的网页信息抽取技术

“网页解析器设计与实现,包括基于模板和基于结构分析的两种信息抽取方案,探讨了各自的优缺点,并提出了改进方案。”

网页解析是互联网数据挖掘中的关键步骤,特别是对于搜索引擎开发而言,网页信息的解析与抽取是提升搜索效率和准确性的核心。HTML解析器的主要任务是从HTML文档中提取出有价值的信息,比如正文内容和特定目标信息,而这个过程通常涉及到去除HTML标签,只保留纯文本内容。

传统的网页解析方法依赖于基于模板的技术。这种方法的基本思路是为每个类型的网页或特定网站设计模板,模板定义了信息的位置和结构。尽管这种方法实现起来较为简单,但其局限性也显而易见。模板依赖性强,一旦网页结构发生变化,可能需要重新设计模板,这导致系统的可移植性和自适应性较差。

针对这些问题,本文提出了两种新的网页解析方案。第一种是基于面向对象设计理念的模板抽取方案,通过抽象网页元素,创建更灵活的对象模型来适应网页结构的变化。这种方式旨在提高模板的通用性和适应性,减少对模板的频繁修改。

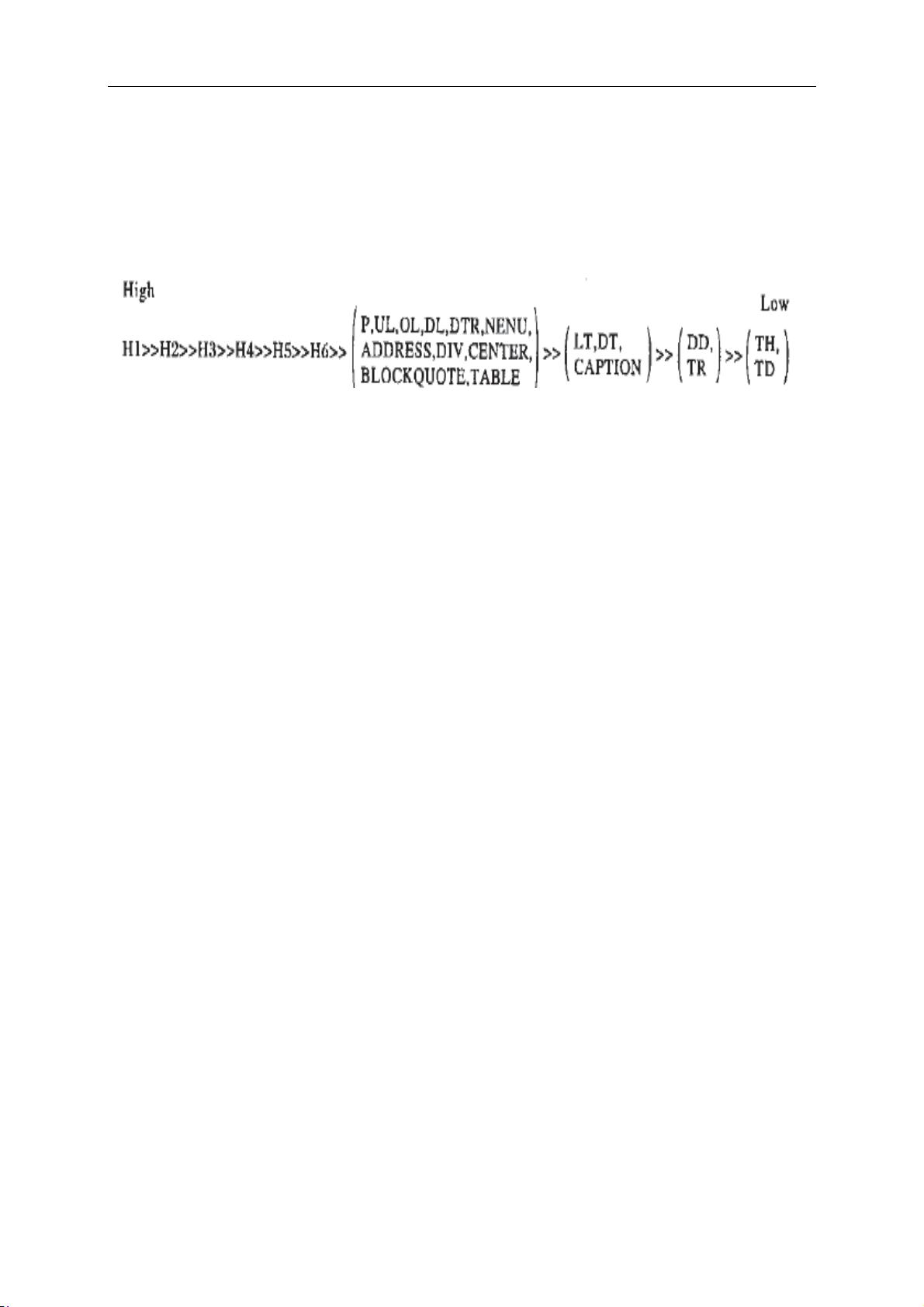

第二种方案则是基于网页结构分析的信息抽取。这种方法不依赖于预定义的模板,而是通过分析HTML结构,利用网页元素的层次关系和语义特性来定位和提取信息。这种方法更注重动态分析,能更好地应对网页结构的复杂性和多变性,但可能需要更复杂的解析算法。

文中详细讨论了这两种方案的实现算法,分析了它们的优缺点。基于模板的方案在实现上简便,但在处理网页变化时显得乏力;而基于结构分析的方案虽然能较好地适应变化,但可能需要更高级的解析技巧和计算资源。

为了提高算法的实际应用价值,设计时倾向于选择简单易行且效果理想的策略,避免过于复杂和高深的算法。系统采用C#语言在Visual Studio 2005平台上实现,经过对腾讯、新浪、凤凰、搜狐等国内主要新闻网站的测试,取得了满意的结果。

最后,文章还对未来可能的发展方向和改进方案进行了展望,包括算法优化、智能学习方法的应用,以及如何结合深度学习等先进技术来进一步提升网页解析的效率和准确性。这些设想将有助于推动网页解析领域的进步,为信息抽取和搜索引擎的未来发展提供新的思路和技术支持。

2009-08-07 上传

2021-04-29 上传

2013-11-03 上传

2020-09-16 上传

2024-03-02 上传

262 浏览量

南平163

- 粉丝: 0

- 资源: 4

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手