深度学习基础:卷积神经网络原理与LeNet解析

175 浏览量

更新于2024-08-30

收藏 651KB PDF 举报

"《动手学深度学习》Task05涵盖了卷积神经网络的基础知识,包括二维卷积层、填充和步幅、多通道处理,以及池化操作,并介绍了经典的LeNet模型。此外,还深入讨论了卷积神经网络的进阶内容,如AlexNet、VGG、NiN和GoogLeNet等深度模型。"

卷积神经网络(CNN)是深度学习领域中用于图像处理和计算机视觉任务的关键结构。它们通过模拟人脑的视觉皮层工作原理,以识别和提取图像特征。

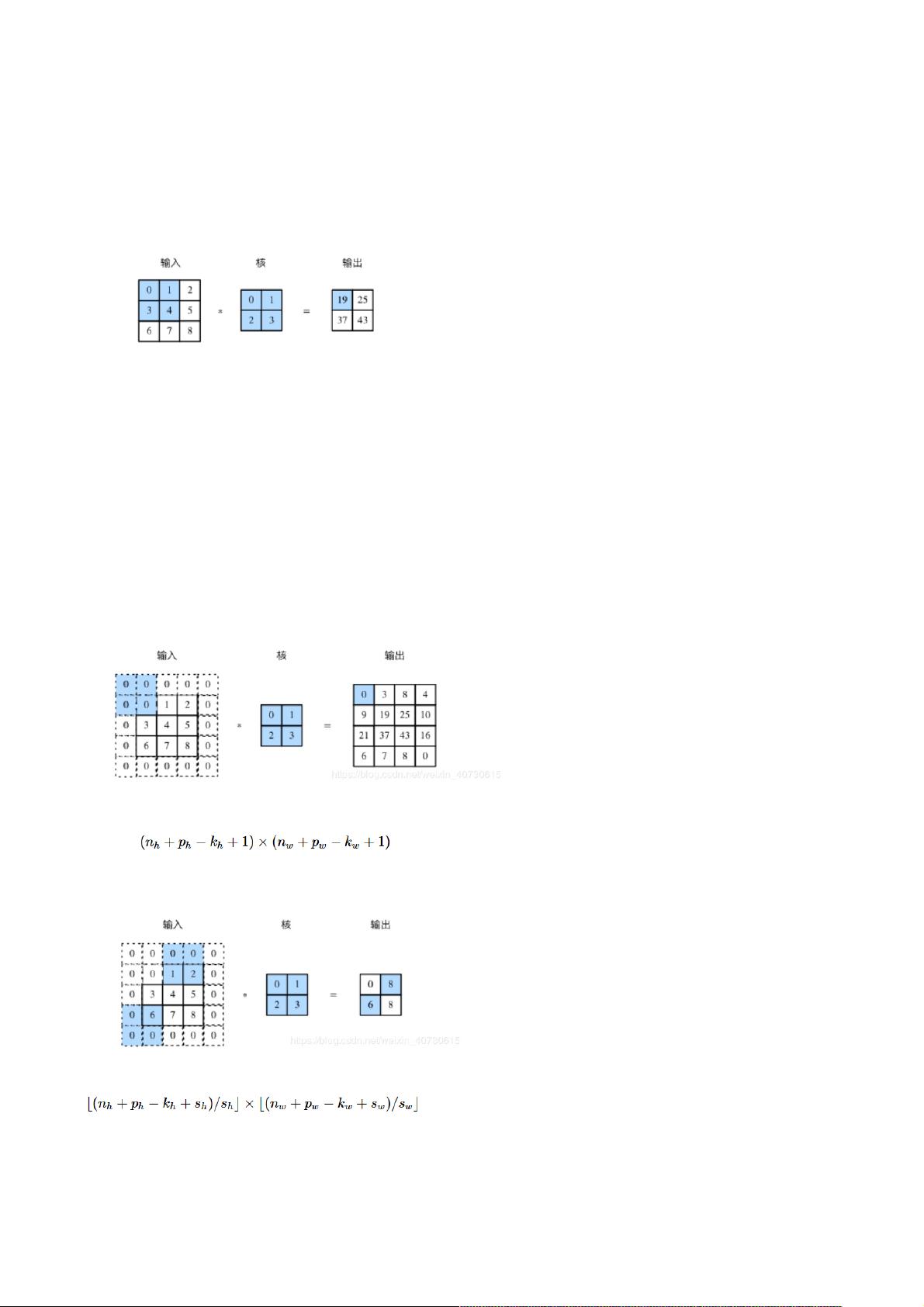

1. **二维卷积层**:是CNN中最基本的组件,用于对输入图像进行特征提取。卷积层通过应用一系列小的可学习滤波器(卷积核)在输入图像上滑动,执行二维互相关运算,生成特征图。特征图的每个元素反映了其对应输入区域的特征响应。

2. **填充(Padding)和步幅(Stride)**:填充是在输入边缘添加额外的零以保持输出尺寸不变;步幅定义了滤波器移动的步长。两者都影响着特征图的大小和模型的捕获细节的能力。

3. **多输入通道和多输出通道**:当处理彩色图像时,输入有多个通道(如红绿蓝RGB三个通道),卷积层可以处理这些通道,生成多输出通道的特征图,每个通道代表不同类型的特征。

4. **卷积层与全连接层对比**:全连接层处理所有输入单元与所有输出单元之间的连接,而卷积层则只连接输入局部区域与输出。这使得卷积层在处理高维数据时更加高效且参数数量相对较少。

5. **池化(Pooling)**:是降采样技术,常用于减少计算量和防止过拟合。常见的池化操作有最大池化和平均池化,它在特征图上滑动窗口并提取最大值或平均值。

6. **LeNet**:由Yann LeCun等人提出的早期CNN模型,主要用于手写数字识别。它包含卷积层、池化层和全连接层,展示了卷积神经网络在图像分类上的潜力。

7. **卷积神经网络进阶**:随着深度学习的发展,出现了许多更复杂的CNN结构,如AlexNet、VGG、NiN和GoogLeNet等。AlexNet首次在ImageNet比赛中击败传统方法,引入了ReLU激活函数和GPU加速;VGG以其深的网络结构和重复的3x3卷积层著称;NiN强调了网络模块化,提出了“块”概念;GoogLeNet引入了Inception结构,优化了计算效率和性能。

这些基础知识和进阶模型共同构成了卷积神经网络的核心,对于理解和实现深度学习项目至关重要。通过动手实践,读者可以更好地掌握CNN的工作原理及其在实际问题中的应用。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-01-20 上传

2021-01-20 上传

点击了解资源详情

2021-01-06 上传

2021-01-06 上传

2021-01-06 上传

weixin_38672800

- 粉丝: 4

- 资源: 917

最新资源

- exercise4-hannao6:GitHub Classroom创建的exercise4-hannao6

- Excel模板基建预算.zip

- SP21-PUFY1225-DIGITAL-ART

- snapcache:Snapcache 允许用户与他们的朋友创建、共享和发现 geocached 时间胶囊

- pronoun-fitting:使用网络话务台的简单代词试衣间

- heappy:一个快乐的堆编辑器,可支持您的利用过程

- Fox-game

- React-Todo-Custom-Hook

- flatten-object:展平嵌套对象,如果存在冲突,则重命名键

- 北大光华-寻找中国版公募REITs的“价格锚”:商业不动产资本化率调查研究-2019.6-32页(1).rar

- django-postgres-fast-test:使用postgres数据库改善django测试的运行时间

- ejson:EJSON是一个小型库,用于使用非对称加密来管理加密的机密

- 毕业设计&课设--毕业设计-校园二手物品交易管理系统.zip

- Excel模板基本建设财务管理人员备案表.zip

- network-idle-callback:类似于requestIdleCallback,但用于检测网络空闲

- splitwithfriends:全栈营的 AngularNode 演示