微软内部禁用ChatGPT:隐私与滥用引发关注

需积分: 0 110 浏览量

更新于2024-06-18

收藏 2.33MB PDF 举报

在2023年11月11日的一则互联网快讯中,出现了关于知名人工智能模型ChatGPT的最新动态。据消息透露,Microsoft(微软)内部对ChatGPT采取了禁用措施。尽管这款由OpenAI开发的语言模型最初因其强大的自然语言处理能力和高度定制性而受到用户欢迎,例如用户能够通过GPT Builder创建特定功能的机器人,如数据分析和代码解释器,甚至用于撰写文本、简历修改和进行社交互动。

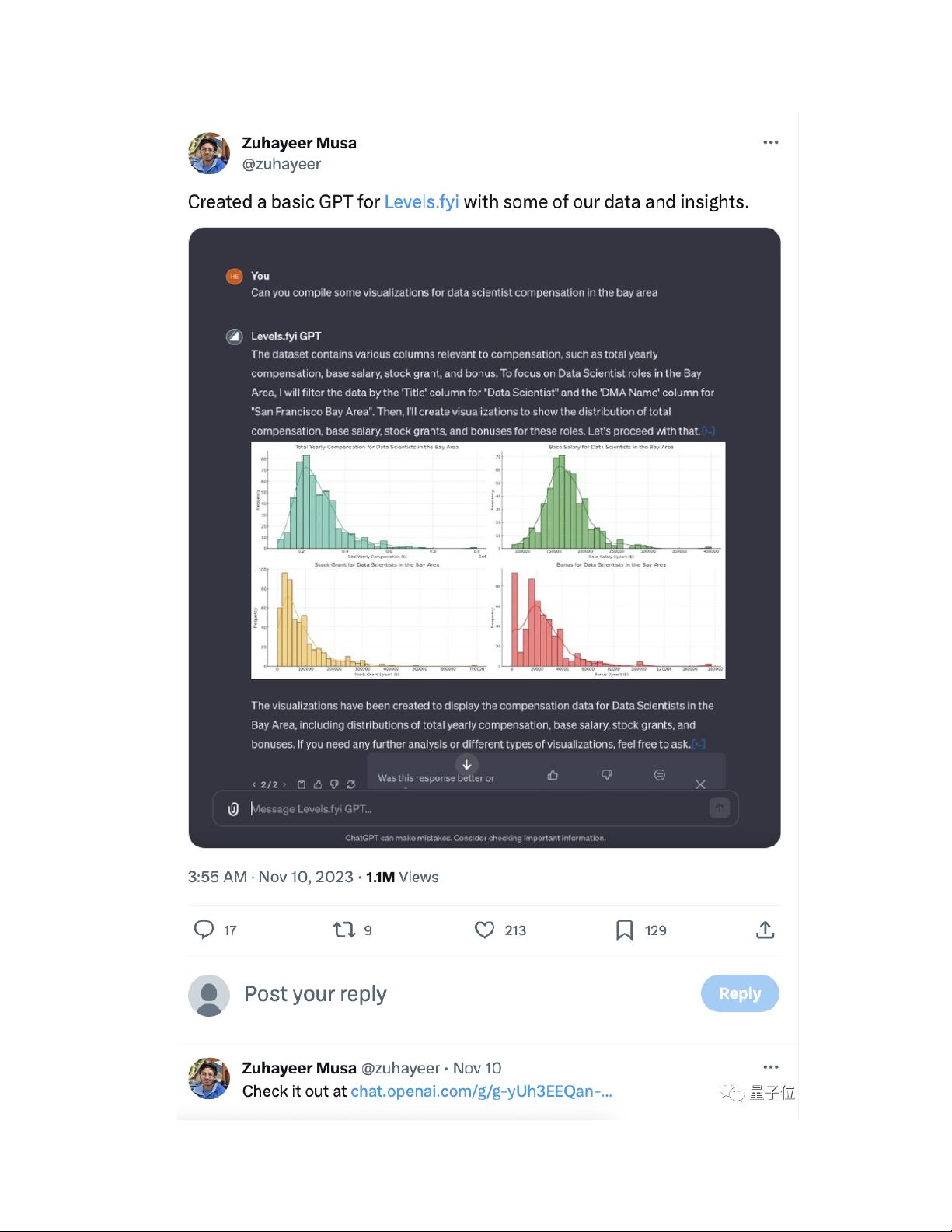

然而,此次禁用并非由于技术故障,而是可能出于安全考量。开发者利用ChatGPT的能力创建了一个名为Levels.fyi的基本版本,该版本能够处理和分享公开数据,但被指出存在漏洞,即用户可以通过简单的询问下载文件,这可能涉及数据隐私和知识产权问题。对此,部分网友建议通过关闭代码解释器功能来减少潜在风险,同时,个性化设置规则也能避免提示词泄露。

尽管OpenAI为付费用户提供了一系列定制化的机器人,如数学导师、烹饪助手等,但开发者们的创新并未止步,他们迅速利用ChatGPT的功能创作出各种奇特应用,从专业辅助到娱乐搞笑,甚至是进行心理测试。然而,由于GPT的使用限制,如每日3小时50条的使用次数,不少用户感到不便,担心过度使用可能导致服务受限。

值得注意的是,马斯克,作为另一大AI模型Grok的幕后支持者,对ChatGPT的态度显得有些讽刺,他在社交媒体上戏谑地将其称为“GPT-Snore”,暗示他对该模型的实际价值持怀疑态度。巧合的是,就在OpenAI遭遇黑客攻击的前一天,微软对内部员工的ChatGPT使用进行了临时限制,这进一步凸显了该公司对于其合作伙伴和自家产品的信息安全的关注。

总体来说,虽然ChatGPT展示了强大的潜力,但在实际应用中,安全和隐私问题成为关注焦点。微软的禁用措施可能是为了保护公司的利益和用户的数据安全,同时也预示着AI技术在快速发展中,监管和伦理问题的讨论将会日益重要。随着技术的不断演进,我们期待看到各方如何平衡创新与责任,以确保AI的健康发展。

2023-04-05 上传

2023-06-10 上传

750 浏览量

2023-12-27 上传

2021-09-01 上传

毕业小助手

- 粉丝: 2754

- 资源: 5583

最新资源

- Angular程序高效加载与展示海量Excel数据技巧

- Argos客户端开发流程及Vue配置指南

- 基于源码的PHP Webshell审查工具介绍

- Mina任务部署Rpush教程与实践指南

- 密歇根大学主题新标签页壁纸与多功能扩展

- Golang编程入门:基础代码学习教程

- Aplysia吸引子分析MATLAB代码套件解读

- 程序性竞争问题解决实践指南

- lyra: Rust语言实现的特征提取POC功能

- Chrome扩展:NBA全明星新标签壁纸

- 探索通用Lisp用户空间文件系统clufs_0.7

- dheap: Haxe实现的高效D-ary堆算法

- 利用BladeRF实现简易VNA频率响应分析工具

- 深度解析Amazon SQS在C#中的应用实践

- 正义联盟计划管理系统:udemy-heroes-demo-09

- JavaScript语法jsonpointer替代实现介绍