ReLU激活函数驱动的CNN深入解析:结构与应用

下载需积分: 15 | PPT格式 | 2.73MB |

更新于2024-07-09

| 78 浏览量 | 举报

新的激活函数-Rectified Linear Unit (ReLU) 是一种在卷积神经网络(CNN)中广泛应用的非线性函数,其公式为 f(x) = max(0, x),它的引入极大地促进了深度学习的发展。相比于传统的激活函数如sigmoid和tanh,ReLU的主要优点是计算速度快,因为它避免了指数运算,使得梯度不会接近于零,从而减少了梯度消失问题,有助于网络训练更深的层次。

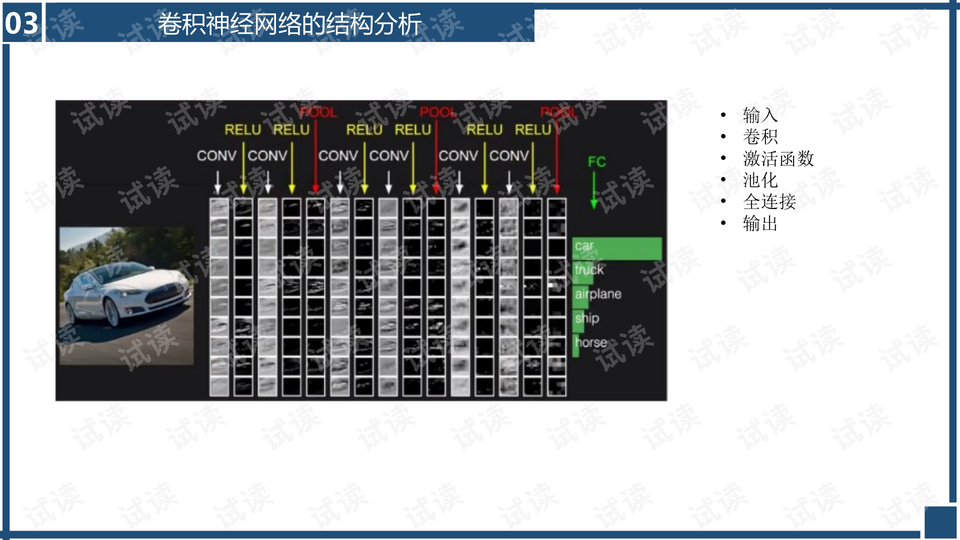

卷积神经网络(CNN)是一种特殊的神经网络结构,特别适合处理具有网格结构的数据,如图像。CNN的结构主要包括以下几个部分:

1. **输入**:原始图像数据,通常为多通道的矩阵形式,如MNIST手写数字数据集中的28x28x1或更大尺寸的彩色图像。

2. **卷积层**:这是CNN的核心组件,通过滑动窗口(滤波器或卷积核)在输入上进行特征检测,提取局部特征。滤波器数量、大小(例如1x1、3x3或5x5)、步长(通常为1)和零填充(用于保持输出尺寸不变)是卷积层的关键参数。

3. **激活函数**:ReLU在卷积神经网络中被广泛应用,因为它可以简化模型并加速训练。ReLU只允许正向传播,将负值置零,提高模型的表达能力。

4. **池化层**:通过降采样(最大池化或平均池化)来减小特征图的尺寸,减少计算量,同时增强对位置不敏感的特性,有助于防止过拟合。

5. **全连接层**:虽然在CNN中相对较少见,但在某些架构中用于将前面卷积层的输出转换为最终分类或回归任务的输出。

6. **数据变化**:在大型网络中,可能包含dropout层来防止过拟合,通过随机丢弃一部分神经元来提高模型泛化能力。

卷积神经网络相较于全连接神经网络的优势在于参数效率、位置信息的利用和更深层次的特征学习。全连接层导致的参数数量过多问题在CNN中得到了缓解,因为卷积层通过局部连接和共享参数的方式降低了参数量。此外,CNN通过卷积操作捕捉空间上的局部特征,这是全连接层无法做到的。

卷积神经网络的历史发展也伴随着技术的不断优化,早期的LeNet-5到AlexNet、VGG、GoogLeNet再到ResNet和Inception等深度网络结构的出现,都体现了CNN在图像识别任务中的不断提升和优化。

总结起来,ReLU激活函数的引入、卷积层的有效特征提取、池化层的参数压缩以及CNN的深度学习优势共同构成了现代深度学习中不可或缺的一部分,使得CNN在图像处理等领域取得了显著的成果。

相关推荐

猫腻MX

- 粉丝: 28

最新资源

- Java实现的情感分析前馈神经网络

- Phaser.js打造的迷人口袋游戏体验

- WinDynamicDesktop 中文版:Windows 10 下的动态壁纸体验

- DiffPlex实现的WPF文本比对组件

- UVA-React项目:开发可离线工作的海洋数据收集应用

- 利用Newmark算法在Matlab中进行动力学响应分析

- winston-mysql-transport:实现MySQL数据库日志记录的高效传输

- 构建WebRTC信令服务器:Signalbox实践指南

- Android平台利用SMSGateway API实现自定义短信发送功能

- DungeonSharp: 构建 roguelike 游戏动态关卡的算法揭秘

- Jsp+XML实现的树状菜单类库:使用简易指南

- 使用Gradle构建SpringBoot与Dubbo集成演示项目

- Redis监控DHCP租约: dhcp-hive-mind项目解析

- React项目入门指南与构建流程详解

- Adept-2:C++自动微分与多维数组操作库

- 云音乐后端管理系统技术实现与架构解析