决策树剪枝:预剪枝与后剪枝策略

版权申诉

58 浏览量

更新于2024-06-27

收藏 1.8MB PPTX 举报

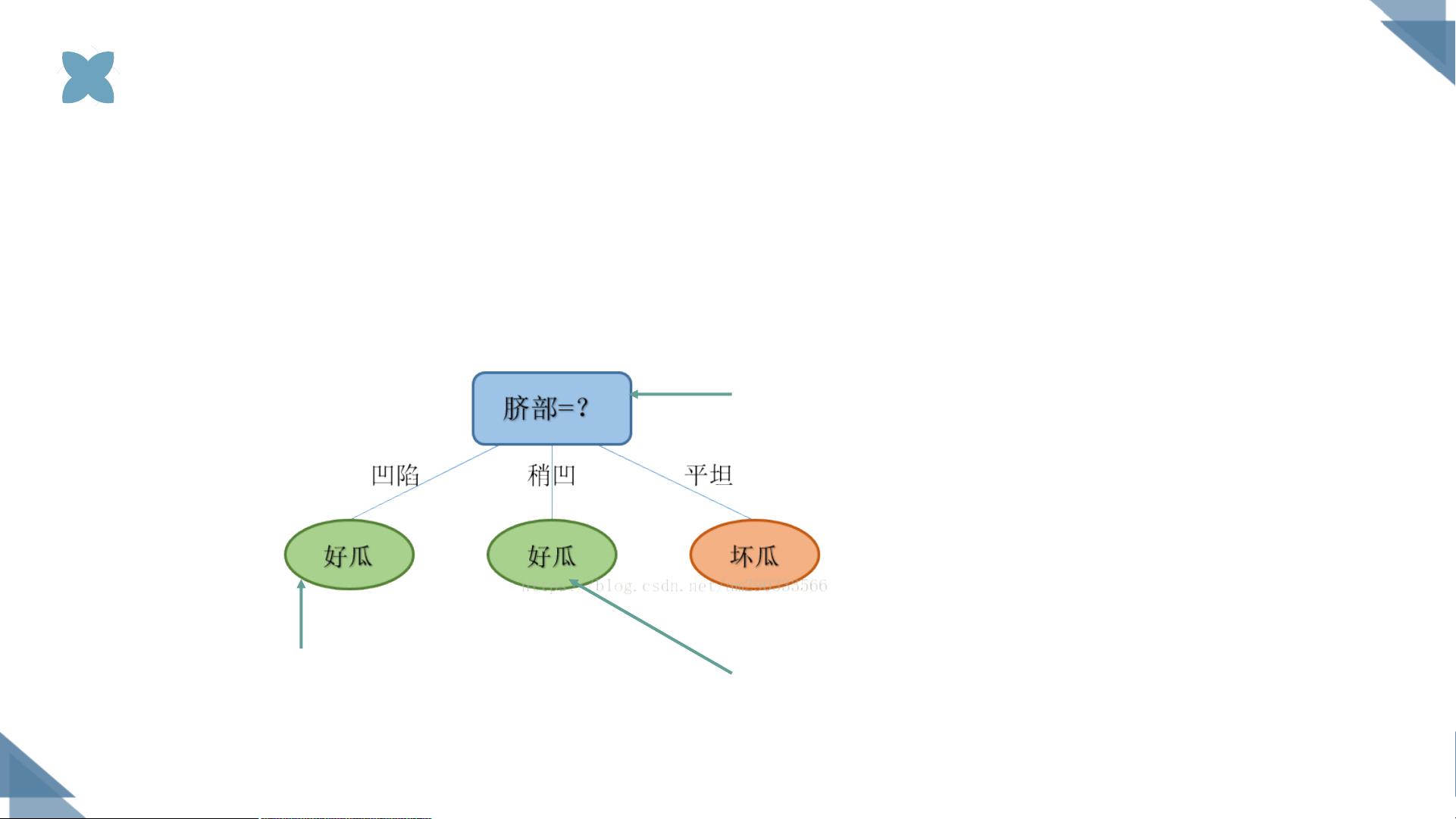

"决策树剪枝是机器学习中用于优化决策树模型的一种技术,旨在提高模型的泛化能力,防止过拟合。决策树通过不断分裂数据集形成分支,但过度复杂的树可能导致对训练数据过度拟合,从而影响对新数据的预测准确性。剪枝策略分为预剪枝和后剪枝两种。

预剪枝是在决策树构建过程中提前停止其生长,以限制树的复杂度。预剪枝通常基于以下条件:

1. 当节点包含的样本数少于某个阈值时,不再继续分裂。

2. 如果分裂带来的不纯度降低(如信息增益、基尼指数)小于某个阈值,不再进行分裂。

3. 设置决策树的最大深度,超过该深度则停止生长。

预剪枝的优点是速度快,适用于大数据集,但缺点是可能因过早停止而错过最优解,需要谨慎选择停止阈值。

后剪枝则是在决策树完全生长后,自底向上地从叶子节点开始检查并删除不必要的分支。剪枝过程通常包括:

1. 将子树替换为单一的叶子节点,该节点的类别由子树中的多数类别决定。

2. 使用子树中最常见的分支替换子树,即子树提升。

后剪枝可以逐步减小决策树的复杂度,以提高泛化性能。其中,Reduced-Error Pruning(错误率降低剪枝)和Pesimistic-Error Pruning(悲观错误剪枝)是常见的后剪枝策略。

决策树剪枝的效果可以通过验证集的精度来评估。例如,在描述中提到的一个例子中,通过对特定特征的划分,决策树的验证集精度从42.9%提升到71.4%,表明剪枝有助于避免过拟合,提高模型的泛化能力。然而,选择合适的剪枝策略和阈值是一个挑战,需要平衡模型的复杂度和预测性能。在实际应用中,可能需要通过交叉验证和调整参数来找到最佳的剪枝方案。"

259 浏览量

点击了解资源详情

点击了解资源详情

128 浏览量

332 浏览量

2021-10-10 上传

2023-01-14 上传

2021-10-10 上传

2021-10-13 上传