Adaboost算法在多类问题上的Matlab实现与优化

版权申诉

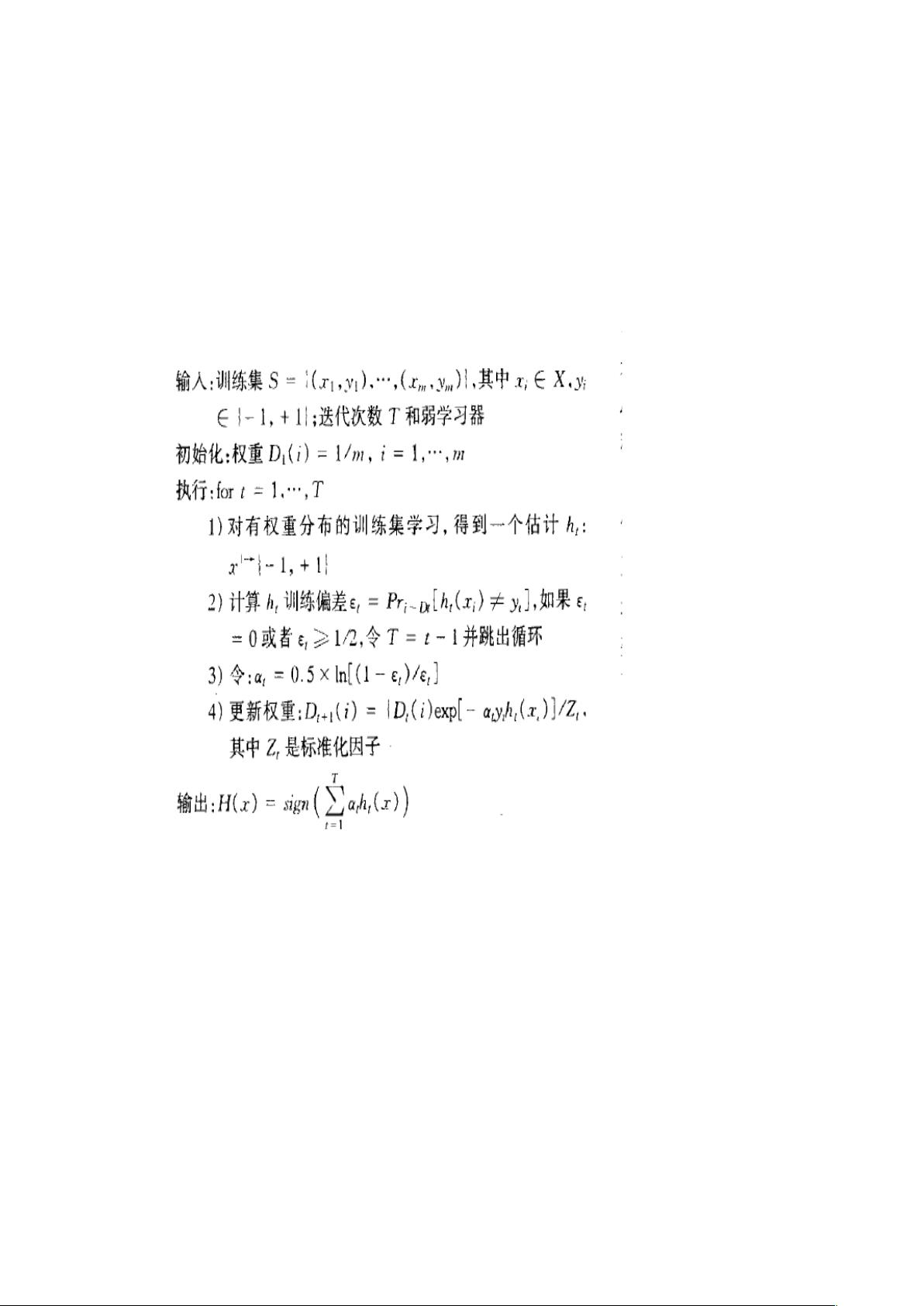

Adaboost算法是一种强大的机器学习方法,最初由Yoav Freund和Robert Schapire于1995年提出,主要用于二分类问题。其核心思想是通过集成多个弱分类器形成一个强分类器,通过迭代过程不断调整样本的权重,使得错误分类的样本在后续的学习中被赋予更高的权重,从而提高整体分类性能。在Matlab中实现多类问题的Adaboost算法时,通常采取One-vs-One (OAO) 和 One-vs-Aliens (OAA) 方法将多类问题转化为二类问题。

在本文档中,作者首先介绍了Adaboost的基本原理,包括初始化样本分布、弱学习器的选择和训练、以及通过迭代提升分类器权重的过程。然后,针对多类问题,作者提出了采用OAA和OAO策略,例如对于7类问题,会训练7个OAA分类器和21个OAO分类器,每个弱分类器采用BP神经网络作为基础模型。

步骤上,作者将数据分为训练集和测试集,然后分别训练OAA和OAO分类器,并保存它们的权重。在测试阶段,通过预测OAA分类器的结果,找出最大权重的两个类别,然后使用OAO分类器对这两个类别进行进一步的判断。最终输出测试结果,其识别率达到了约93%。

然而,作者也指出这种方法存在局限性,当从OAA预测值中选择的两个最大类别并不包含正确类别时,OAO决策可能失效。因此,如何有效组合OAA预测结果,尤其是选择合适的决策策略,是优化多类Adaboost算法的关键。这表明算法在实际应用中需要不断优化和完善,以适应不同场景的需求。

总结来说,这份文档详细地展示了如何在Matlab中实现多类Adaboost算法,包括其原理、分类器构建、训练过程和优化策略。它强调了在处理多类问题时需要注意的问题,以及对算法性能的持续改进的重要性。对于理解和实践Adaboost算法在多类问题中的应用,这是一个实用且有价值的资源。

2022-11-04 上传

2023-10-20 上传

2024-10-19 上传

2024-10-08 上传

2024-10-19 上传

2024-10-19 上传

2024-10-08 上传

2024-10-08 上传

2024-10-08 上传

阿里matlab建模师

- 粉丝: 3624

- 资源: 2807

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载