Python高效处理3万条数据:从写入到去重、导出

34 浏览量

更新于2024-08-31

1

收藏 160KB PDF 举报

"本文主要介绍如何使用Python高效处理大量数据,包括数据写入MySQL数据库、数据去重和数据导出。以3万多条数据为例,通过Python脚本实现了自动化操作,显著提高了工作效率。"

在现代数据处理场景中,面对海量数据,传统工具如Excel往往难以胜任,效率低且容易出错。Python作为一种强大的编程语言,因其丰富的数据处理库和简洁的语法,成为处理大数据的首选工具。本文以处理3万多条数据为例,展示了Python在数据处理方面的强大性能。

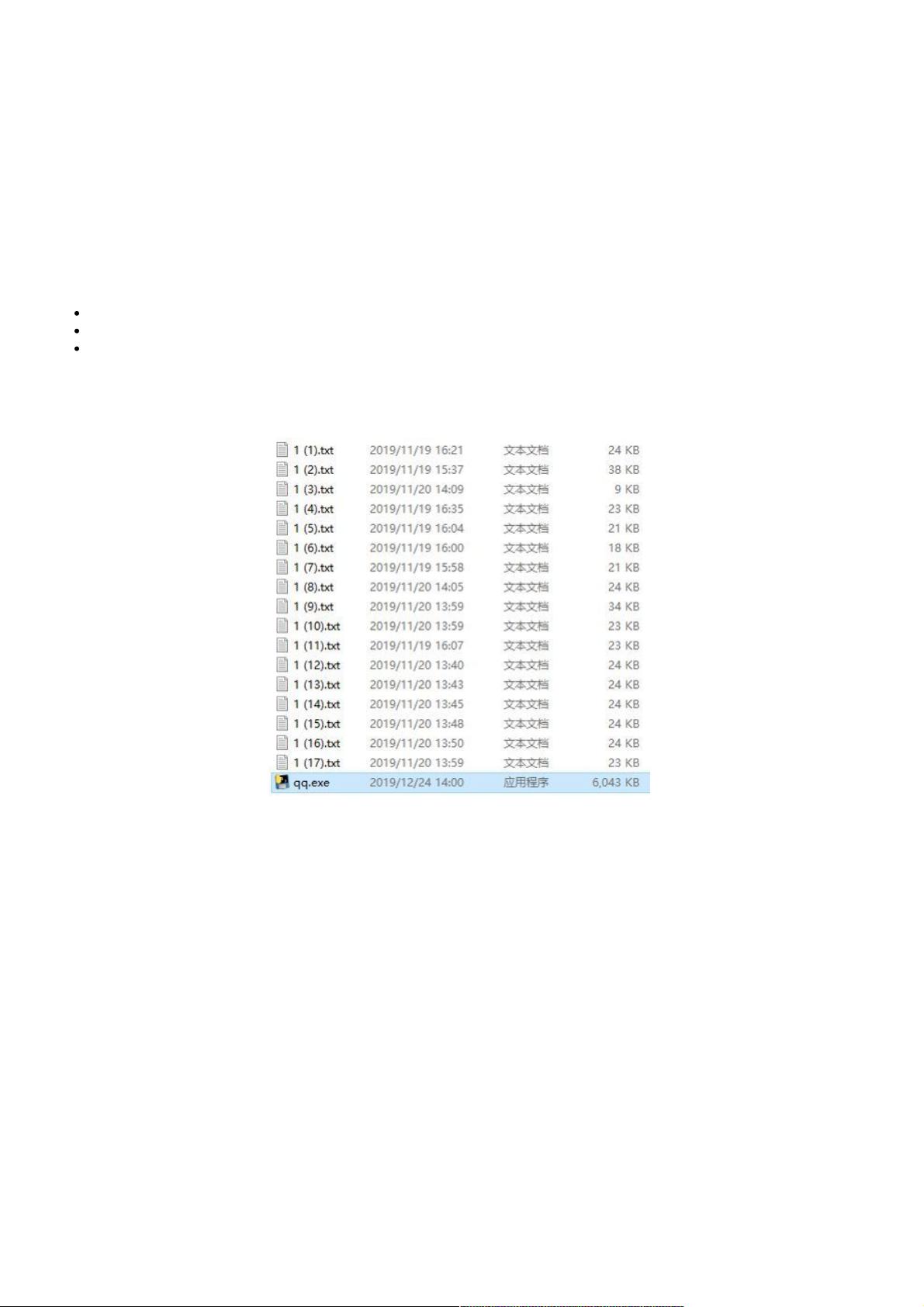

首先,数据写入部分使用了Python的`pymysql`库来连接和操作MySQL数据库。`pymysql.connect()`函数用于建立数据库连接,参数包括数据库服务器地址、用户名、密码、数据库名以及字符编码。接着,创建游标对象`cur`以便执行SQL命令。然后,通过`cur.execute()`执行创建表的SQL语句,这里创建了一个简单的`qq`表,包含`id`(自增主键)和`qq`两个字段。`conn.commit()`用于提交事务,确保数据成功写入。接下来,使用`os`库获取当前工作目录下的所有txt文件,对每个文件逐行读取内容,插入到数据库中。`open()`函数用于打开文件,`for line in f:`遍历文件每一行,`insert into`语句将数据插入表中。最后关闭文件和数据库连接。

数据去重通常涉及到检查和删除重复的记录。在Python中,可以使用`pandas`库的`drop_duplicates()`函数来实现。假设我们已经将数据加载到一个名为`df`的DataFrame中,只需一行代码`df.drop_duplicates(inplace=True)`即可去除重复行。如果需要基于特定列去重,可以指定`subset`参数,如`df.drop_duplicates(subset=['qq'], inplace=True)`。

数据导出通常是指将处理后的数据保存成文件,例如CSV或Excel格式。使用`pandas`,可以使用`to_csv()`或`to_excel()`函数。例如,`df.to_csv('output.csv', index=False)`将保存DataFrame为CSV文件,`index=False`表示不保存索引列。对于Excel格式,需要安装`openpyxl`库,`df.to_excel('output.xlsx', index=False)`则会保存为Excel文件。

此外,文章提到了使用`pyinstaller`将Python脚本打包成可执行文件,这便于在没有Python环境的计算机上直接运行。`pyinstaller`是一个命令行工具,通过`pyinstaller your_script.py`命令可以将Python脚本转换为独立的可执行程序。

总结来说,Python结合`pymysql`、`os`、`pandas`等库,能够高效地处理大量数据,包括快速写入数据库、去重和导出数据。这种自动化处理方式极大地提升了工作效率,使得原本可能需要花费大量时间的任务在短短几秒内就能完成。对于需要处理大量数据的场景,学习和应用这些Python技巧是十分必要的。

2024-09-05 上传

2022-06-01 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38684509

- 粉丝: 4

- 资源: 914

最新资源

- DEM的流域水文特征提取方法研究

- ibatis SqlMaps 开发指南

- dem习题集+绝对经典

- java how to debug

- 最实用的EXT开发教程

- UMl课程设计,完全自己做的。系主任评分通过

- 软件测试课程设计,JUNIT

- A Road Map Through Nachos.pdf

- 试设计一个用回溯法搜索一般解空间的函数

- 试设计一个用回溯法搜索排列空间树的函数

- 设计一个用回溯法搜索子集空间树的函数

- 子集树问题c++试设计一个用回溯法搜索子集空间树的函数。

- fdsafsdofds

- LoadRunner使用手册

- FIRA详细的代码注释(避障函数+position函数)

- 多套嵌入式考试习题集