线性回归详解:要素、实现与优化算法

需积分: 0 105 浏览量

更新于2024-08-05

收藏 10MB PDF 举报

线性回归是一种基础但强大的统计分析工具,在预测和理解两个或多个变量之间的关系时被广泛应用。本资源详细介绍了线性回归的基本概念和实现过程。

首先,线性回归的核心要素包括:

1. 假设:线性回归假设因变量(通常是价格)与自变量(比如房屋面积和年龄)之间存在线性关系,即通过一次多项式函数描述两者的关系。

2. 数据:数据集通常包含训练数据,也就是一系列房屋的售出价格,以及与之相关的特征,如面积和年份。这些数据用于拟合模型,其中每个房屋是一个样本,售出价格是标签,而面积和年份则是特征。

3. 目标:模型训练的目标是找到一组参数,使得模型对未知数据的预测尽可能接近实际价格,从而减小预测误差。这涉及到损失函数的选择,比如常见的平方误差函数,它衡量预测值与真实值之间的差异。

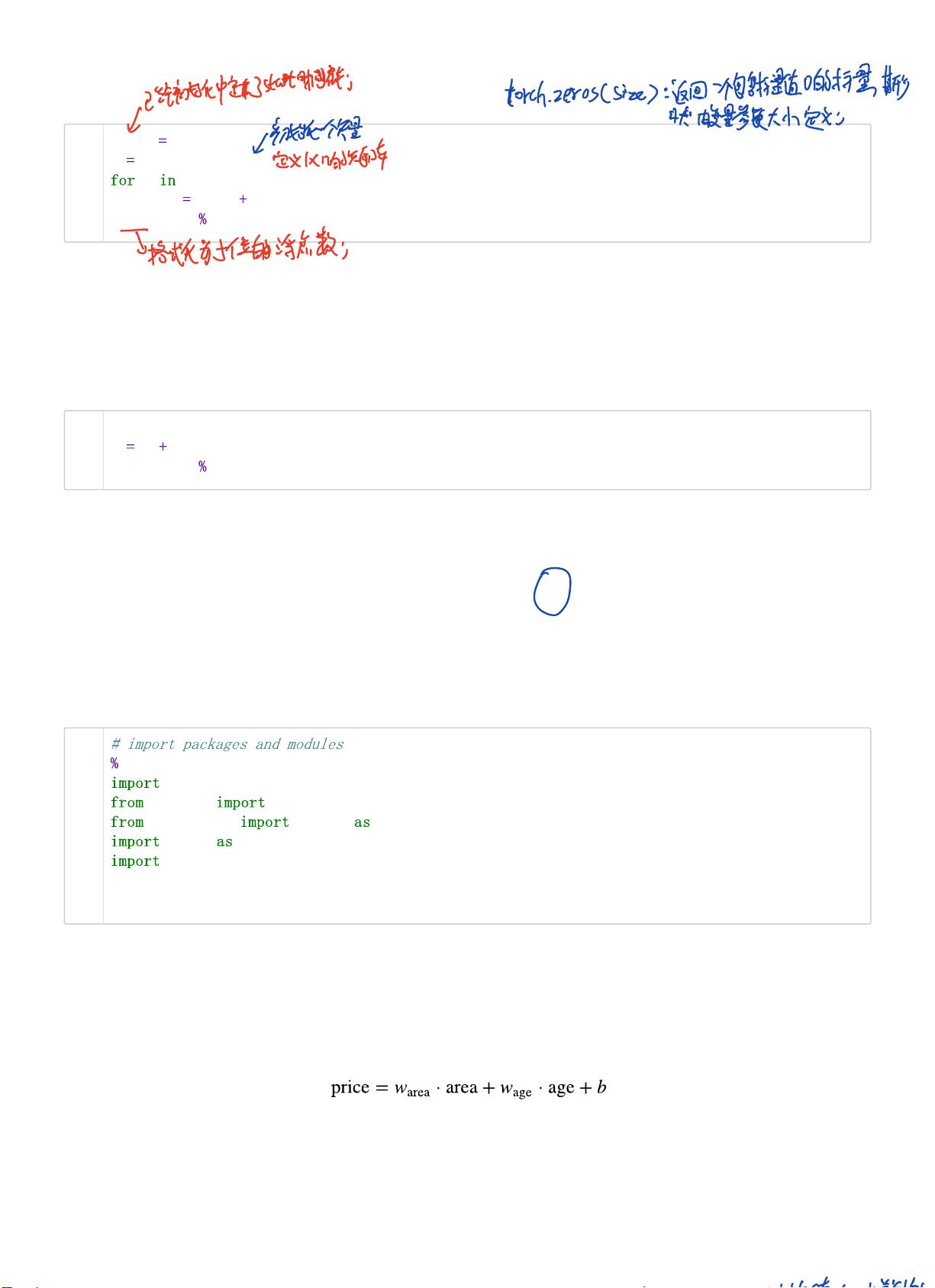

4. 优化:对于简单的线性回归模型,解析解可通过直接计算得到。然而,深度学习模型通常没有解析解,需要使用数值优化算法,如小批量梯度下降。这个过程涉及选择一个初始参数值,然后迭代更新参数,每次迭代通过计算小批量数据的梯度来最小化损失函数。

5. 数值解:小批量梯度下降是深度学习中的常见优化方法,它每次处理一小部分数据(mini-batch),计算这些样本的梯度,并以此调整模型参数,直至找到全局或局部最优解。

6. 损失函数:平方误差函数是最常用的损失函数之一,因为它能够提供连续、可微的误差度量,便于优化。计算样本误差时,平方误差函数会将误差平方,这样较小的误差会被放大,有利于算法收敛。

7. 计算效率:尽管计算过程可能涉及大量的样本计算,但通过小批量处理,可以提高计算效率,减少内存消耗,同时保持模型性能。

本资源提供了线性回归的入门指南,从基本概念到实际应用,涵盖了模型建立、参数估计和优化方法,为理解和实现线性回归模型提供了清晰的路径。

2022-08-03 上传

2022-06-04 上传

2022-07-25 上传

2022-07-25 上传

豆瓣时间

- 粉丝: 27

- 资源: 329

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手