分布式深度学习:GPU加速与Hopsworks在海量数据中的突破

需积分: 49 196 浏览量

更新于2024-07-15

收藏 4.03MB PDF 举报

随着人工智能需求的爆炸性增长,分布式深度学习技术在其中扮演了关键角色。深度学习的进步,尤其是得益于GPU(图形处理器)的并行计算能力,极大地推动了这一领域的发展。分布式深度学习旨在解决单个计算设备处理大规模数据集时的挑战,通过将任务分解到多台计算机上,实现了模型训练的效率提升和性能优化。

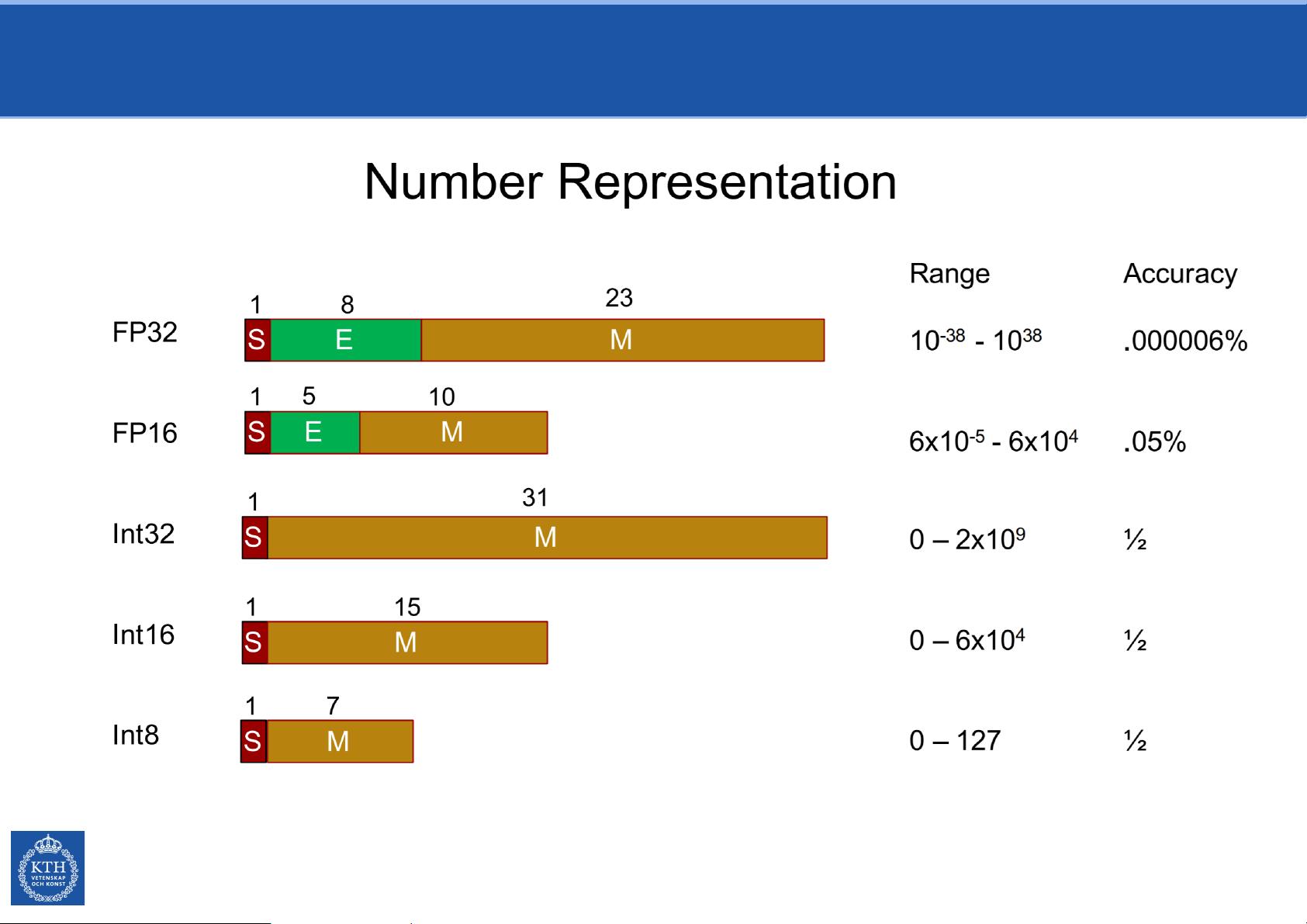

在分布式深度学习中,像NVIDIA的GPU通过Fused Multiply-Add (FMA)指令提供了显著优势。FMA是一种高效的操作,它在一次操作中同时执行乘法和加法,对于深度学习中的矩阵运算,如Affine Transformation(线性变换)和Feed-Forward Networks(前馈神经网络)中的权重更新和激活函数计算极其有利。这使得GPU能够快速进行大规模的权重乘法和累加,从而加速了神经网络的训练过程。

矩阵乘法是深度学习的核心计算之一,它负责计算输入特征与权重之间的加权求和,生成网络层的输出。在卷积神经网络中,这个过程更为复杂,涉及多个卷积滤波器对输入图像的逐像素操作,形成特征映射。每个输出位置(称为像素)通过一个内核(filter)与输入像素的局部区域进行卷积,然后加上偏置项,最终得出该位置的输出值。

传统的冯·诺依曼架构,尽管在早期计算机科学中占据了主导地位,但在处理深度学习的大量数据和复杂的计算需求时显得力不从心。冯·诺依曼体系结构的特点是单一的指令流和数据流,而现代计算系统倾向于采用非冯·诺依曼架构,如数据流或基于内存的计算模型,它们能够更好地支持并行处理和数据流式计算,适应分布式环境下的数据传输和计算需求。

Hopsworks是一个可能与分布式深度学习相关的平台,它提供了一个集成的环境,用于开发、部署和管理机器学习模型,包括分布式训练。在这个平台上,用户可以利用GPU资源和分布式计算能力来加速深度学习任务,并且通过优化的数据管理和通信机制,简化了团队协作和模型部署的过程。

分布式深度学习技术通过利用GPU的并行计算能力、优化的算法实现和现代计算架构,极大地提升了深度学习的训练效率,使得复杂的人工智能应用成为可能。随着硬件和软件技术的持续进步,我们期待看到更多创新的分布式深度学习解决方案,以满足不断增长的人工智能领域的需求。

2021-01-30 上传

2024-12-16 上传

2024-03-10 上传

2021-08-08 上传

2023-03-09 上传

2023-03-09 上传