EM算法详解:从概念到迭代求解

需积分: 1 16 浏览量

更新于2024-08-05

收藏 1.28MB DOCX 举报

"EM算法是一种迭代优化方法,常用于处理含有隐含变量的概率模型参数估计问题。该算法在每一轮迭代中包含期望(E)步和最大化(M)步,逐步逼近参数的最大似然估计值,直至算法收敛。下面将详细阐述EM算法的基本原理和应用。

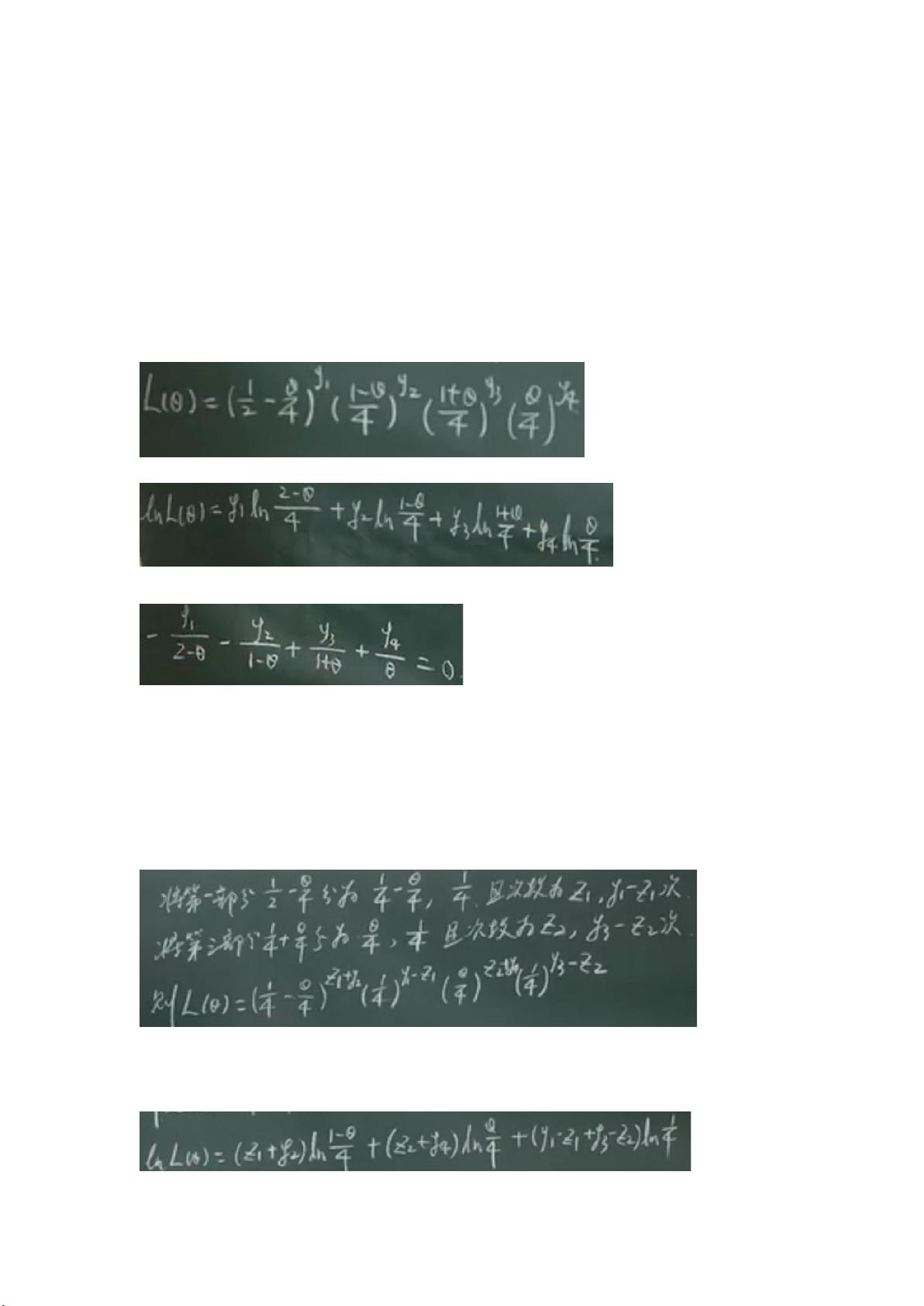

EM算法的核心在于将原问题分解为两部分:已观测数据和未观测(或隐含)数据。在本例中,已观测数据是实验结果的次数y1、y2、y3、y4,而未观测数据z1和z2是对应每个结果发生的概率。通过引入这些未观测变量,我们可以构建更复杂的模型,但同时也带来了求解的困难,因为直接求解可能会导致高次幂的复杂性。

在E步(期望步骤),目标是利用当前的模型参数估计来计算未观测数据的期望值。在这个例子中,由于z1和z2的取值未知,但它们遵循二项分布,我们可以利用这个信息计算它们的期望。E步的关键是找到一种方式来表示这些潜在变量的期望,以便在下一步中使用。

在M步(最大化步骤),我们固定了E步得到的期望值,并最大化似然函数,即调整模型参数以最大化考虑到未观测数据期望后的似然。在这个例子中,我们通过对似然函数取对数并求偏导数来找到θ的最优值,同时消去了E步中计算的期望值,使得问题简化为可解的形式。

EM算法的优势在于它能处理含有隐含变量的复杂模型,并且在每一步迭代中都能保证模型的似然性不降低。随着迭代的进行,模型参数通常会逐渐改进,直到达到一个局部最优解或全局最优解。然而,EM算法并不保证一定能找到全局最优解,但通常在实践中能够找到接近最优的参数估计。

EM算法广泛应用于统计学、机器学习和信号处理等领域,例如混合高斯模型的参数估计、隐马尔科夫模型的学习以及缺失数据的处理等。其灵活性和实用性使其成为解决有隐含变量问题的强大工具。在实际应用中,为了确保算法的收敛和避免陷入局部最优,通常需要设置合理的初始化参数和迭代次数限制。"

2024-09-05 上传

2022-06-19 上传

2022-06-11 上传

2023-06-10 上传

2023-02-24 上传

2023-12-26 上传

2023-05-30 上传

2023-05-31 上传

2024-10-09 上传

呆呆有库

- 粉丝: 3090

- 资源: 2

最新资源

- 前端协作项目:发布猜图游戏功能与待修复事项

- Spring框架REST服务开发实践指南

- ALU课设实现基础与高级运算功能

- 深入了解STK:C++音频信号处理综合工具套件

- 华中科技大学电信学院软件无线电实验资料汇总

- CGSN数据解析与集成验证工具集:Python和Shell脚本

- Java实现的远程视频会议系统开发教程

- Change-OEM: 用Java修改Windows OEM信息与Logo

- cmnd:文本到远程API的桥接平台开发

- 解决BIOS刷写错误28:PRR.exe的应用与效果

- 深度学习对抗攻击库:adversarial_robustness_toolbox 1.10.0

- Win7系统CP2102驱动下载与安装指南

- 深入理解Java中的函数式编程技巧

- GY-906 MLX90614ESF传感器模块温度采集应用资料

- Adversarial Robustness Toolbox 1.15.1 工具包安装教程

- GNU Radio的供应商中立SDR开发包:gr-sdr介绍