深度学习中卷积与全连接网络的区别与优势

186 浏览量

更新于2025-03-20

收藏 214KB DOCX 举报

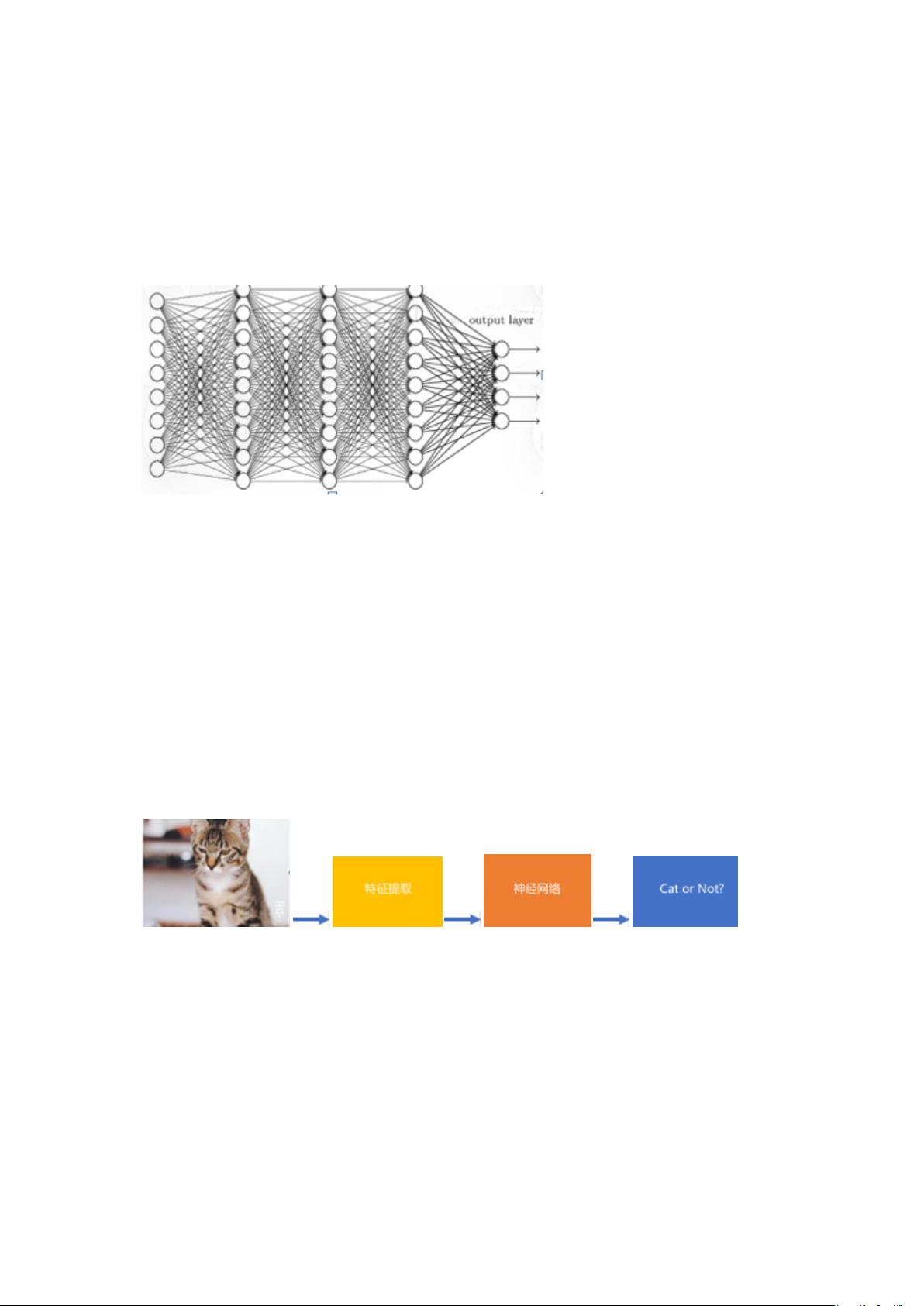

全连接网络由于其参数量巨大,计算量巨大,在处理图像数据时存在局限性。相比之下,卷积神经网络采用局部连接和权重共享策略,大幅降低了参数量,提高了模型的特征提取能力。卷积神经网络的核心思想是局部连接,它能够更好地利用图像中的空间结构信息,通过权重共享保证特征的不变性,并通过减少参数降低学习难度。本文将详细介绍卷积与全连接的比较和区别,卷积的核心思想,以及ANN与CNN的比较。"

深度学习中的卷积与全连接网络都是神经网络的重要组成部分,它们在结构和功能上有着本质的区别。全连接网络(ANN)中的每一层神经元都与上一层的所有神经元相连,这种结构导致了参数量巨大,从而计算量也随之增加。在处理高维度数据时,如图像数据,全连接网络需要大量的参数来描述像素与像素之间的关系,这使得模型变得复杂且难以训练。例如,对于一个1000x1000像素的图像,如果隐藏层有同样大小的1000个神经元,那么参数量将达到10^12,这将占用约400MB的浮点数内存。因此,全连接网络在图像处理等领域的应用受到限制。

相比之下,卷积神经网络(CNN)采用局部连接的方式来连接神经元,即每个神经元只与输入的局部区域的神经元相连,这样显著降低了参数量。以10x10像素的局部块为例,如果卷积核移动步长为1,参数量将降为原来的1/100。此外,CNN中还采用权重共享机制,即同一个卷积核在不同位置的权重相同,这不仅保证了特征提取的不变性,还能够减少参数数量,降低模型的复杂度和学习难度。

卷积的核心思想是局部连接和权重共享。局部连接使得网络能够更好地利用图像的空间特性,即空间距离越近的像素点其相互影响越大,权重共享则通过共享卷积核的参数来减少学习参数的数量,使得网络能够处理图像平移的不变性。这使得卷积神经网络在图像和视频处理领域表现出色。

传统的全连接神经网络是一种有监督的机器学习方法,其输入是已经提取好的特征向量,而卷积神经网络是一种无监督的特征学习方法,它的输入是原始图像数据。CNN可以直接从原始数据中学习到有用的特征表示,而不需要依赖于人工设计的特征提取器。

卷积神经网络相较于全连接网络,在处理图像、视频、音频和其他具有明显空间结构的数据时,表现出更高效的特征提取能力,同时减少了模型参数量和计算复杂度,提高了学习效率。CNN通过卷积层、池化层和全连接层的组合,形成了一种强大的深度学习架构,极大地推动了计算机视觉、图像识别和语音识别等领域的技术进步。

点击了解资源详情

520 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

148 浏览量

469 浏览量

点击了解资源详情

216 浏览量

程序员Thomas

- 粉丝: 406

最新资源

- 《脱壳的艺术》中文版:深入解读反调试技术

- WAP2.0文章阅读网站源代码及其系统后台介绍

- Open Flash Chart-2图表教程与实践示例

- ASP+FLASH综合应用源码解析与下载

- 皖仪科技2021年上半年业绩报告要点分析

- MATLAB图像运动检测功能开发详解

- Java开发的源代码行数统计器评测

- Silverlight 地图功能实现源码分析

- FileZilla客户端和服务器的安装与配置指南

- MATLAB开发IMT2000车辆环境特性及延迟分析

- 探索免费1D电测深反演软件setup1d及其局限性

- 首次部署:自动化流程与技术要点

- 探索Windows环境下的Rader阅读器功能与应用

- SSM框架整合与Maven项目管理实战指南

- 使用Fastor库实现双马赫算例求解2D欧拉方程

- 深入理解iOS CoreData的增删改查操作演示