淘宝技术架构:发展历程与关键需求

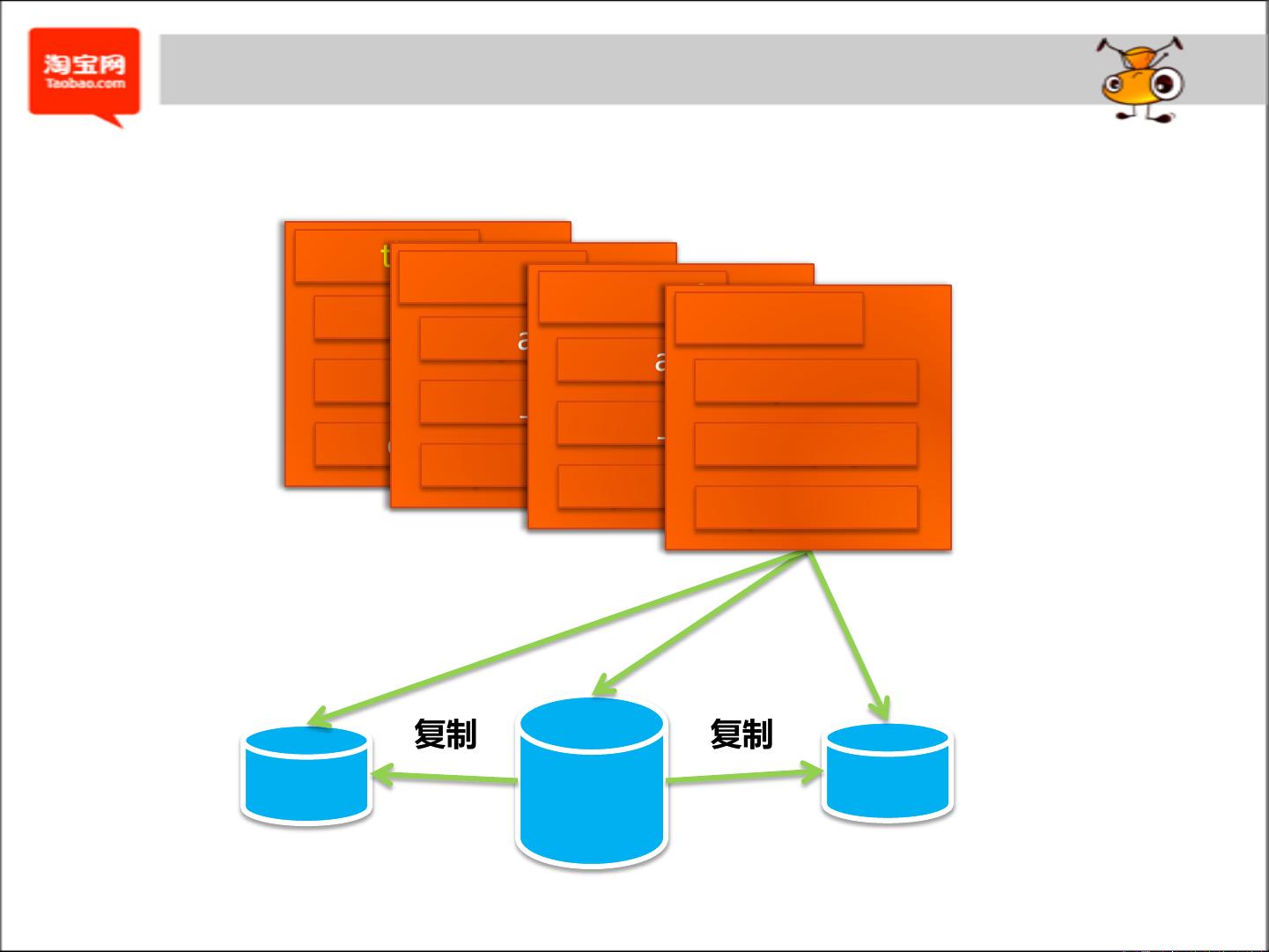

淘宝技术架构是一个庞大而复杂的系统,旨在支持中国最大的在线购物平台的高效运作。它起源于2003年左右,随着淘宝业务的迅速发展,其技术架构经历了多次迭代和升级。最初采用的是LAMP架构(Linux、Apache、MySQL和PHP),在2003年的非典期间,为了应对大规模流量和数据处理需求,引入了MySQL的读写分离策略,通过Master-Slave复制模式提高数据库性能。

随着时间推移,淘宝技术架构的需求逐渐转向了高稳定性、高容量、高性能和高可维护性。这些需求体现在以下几个关键方面:

1. 高稳定性:淘宝作为一个日均7亿次页面访问,高峰期每秒处理超过25GB流量的大型交易网站,必须确保服务的连续性和可靠性。这包括对服务器、数据库和网络基础设施的冗余设计,以及实时监控和故障恢复机制。

2. 高容量:面对超过40亿次的用户访问和400万笔的有效交易,架构需要能够承载庞大的用户群体和数据量。这涉及到存储容量的扩展,如22TB的宝贝图片存储和4亿多条交易记录。

3. 高性能:为了满足用户的快速搜索和浏览需求,淘宝技术架构依赖于高效的搜索引擎和数据库查询优化。同时,处理能力的提升确保了每秒能处理几百笔交易和大量并发请求。

4. 高可维护性:随着项目的快速发布和模板更新,架构需要具备良好的模块化和灵活性,以便于快速迭代和维护。这包括频繁的代码部署、自动化测试和持续集成/持续部署(CI/CD)流程。

2008年是淘宝技术架构的关键节点,这一年交易额达到了999.6亿人民币,注册用户超过9800万,业务规模显著扩大。随着数据量的爆炸式增长,技术团队需要应对更大的日志处理、用户信息访问和缓存请求压力。

淘宝技术架构的发展历程见证了从最初的V1.0版本到后来的V3.0版本的演进,每一次升级都伴随着对现有架构的优化和新技术的应用。例如,从V1.0的简单架构发展到V2.0引入更高级别的数据管理策略,再到V3.0可能涉及分布式系统、云计算、微服务等现代架构理念,以适应不断变化的业务需求和技术趋势。

淘宝技术架构是一个动态且不断演进的体系,它不仅反映了电子商务行业的快速发展,也体现了技术团队如何通过创新和优化来支撑一个全球知名电商平台的运营。

2020-03-12 上传

2013-05-14 上传

2019-03-16 上传

2019-09-20 上传

2018-05-24 上传

点击了解资源详情

toman

- 粉丝: 0

- 资源: 9

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手