word2vec原理解析:Hierarchical Softmax 模型深入

需积分: 24 119 浏览量

更新于2024-09-09

收藏 631KB PDF 举报

"这篇博客文章主要探讨了word2vec模型中的Hierarchical Softmax改进方法,这是word2vec的两种优化策略之一,另一种是Negative Sampling。文章作者是刘建平Pinard,他是一位有着丰富经验的码农,对数学、统计学、数据挖掘、机器学习以及大数据相关领域有深厚的兴趣和实践经验。

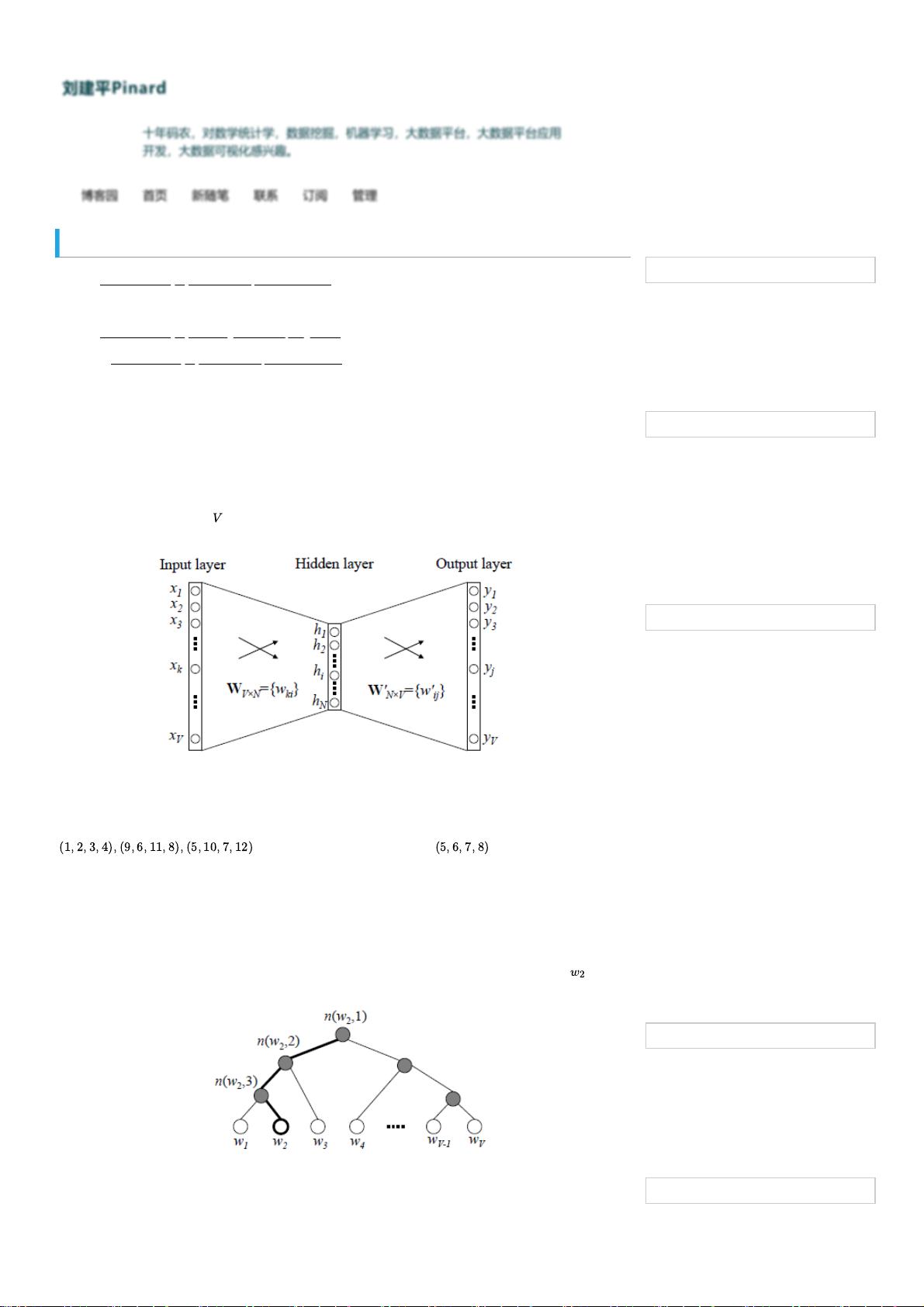

在word2vec的基础模型中,通常包含输入层(词向量)、隐藏层和输出层(Softmax层)。传统模型的问题在于输出层的计算复杂度高,需要计算所有词汇的概率并找出最大概率的词。为了解决这个问题,word2vec提出了Hierarchical Softmax的策略。

Hierarchical Softmax是一种二叉树结构,它将词汇表的每个词映射到二叉树的不同叶子节点。在训练过程中,预测目标词不再是通过计算所有词汇的概率,而是沿着二叉树路径进行一系列的二分类决策,直到到达目标词的叶子节点。这种方法显著减少了计算量,特别是对于词汇表很大的情况。

具体来说,word2vec在输入层到隐藏层的转换上做了简化,不再使用神经网络的线性变换和激活函数,而是取输入词向量的平均值作为新的词向量表示。例如,如果有三个4维词向量,它们的平均值就是新词向量。这种做法减少了计算复杂度,并保持了词向量的语义信息。

从隐藏层到输出层的改进,word2vec采用了Hierarchical Softmax结构,使得每次预测只需要处理与目标词相关的部分,而非所有词汇。这样极大地提高了计算效率,尤其是在大规模词汇表的场景下。

Hierarchical Softmax是word2vec提高训练速度和效率的重要手段,它通过构建树形结构来近似计算概率,降低了全词汇表的计算复杂度。这使得word2vec能够在处理大量词汇的情况下,快速有效地学习到高质量的词向量,为后续的自然语言处理任务提供了强大的预训练特征。在下一篇文章中,作者将继续介绍word2vec的另一种改进策略——Negative Sampling,这是另一种降低计算复杂度的有效方法。"

2014-09-29 上传

2024-01-02 上传

2018-12-28 上传

2018-12-28 上传

2023-02-06 上传

2022-08-08 上传

Gavin_xxx

- 粉丝: 1

- 资源: 4

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常