零基础搭建大数据平台全攻略:从日志采集到Spark处理

版权申诉

144 浏览量

更新于2024-07-05

1

收藏 4.26MB PDF 举报

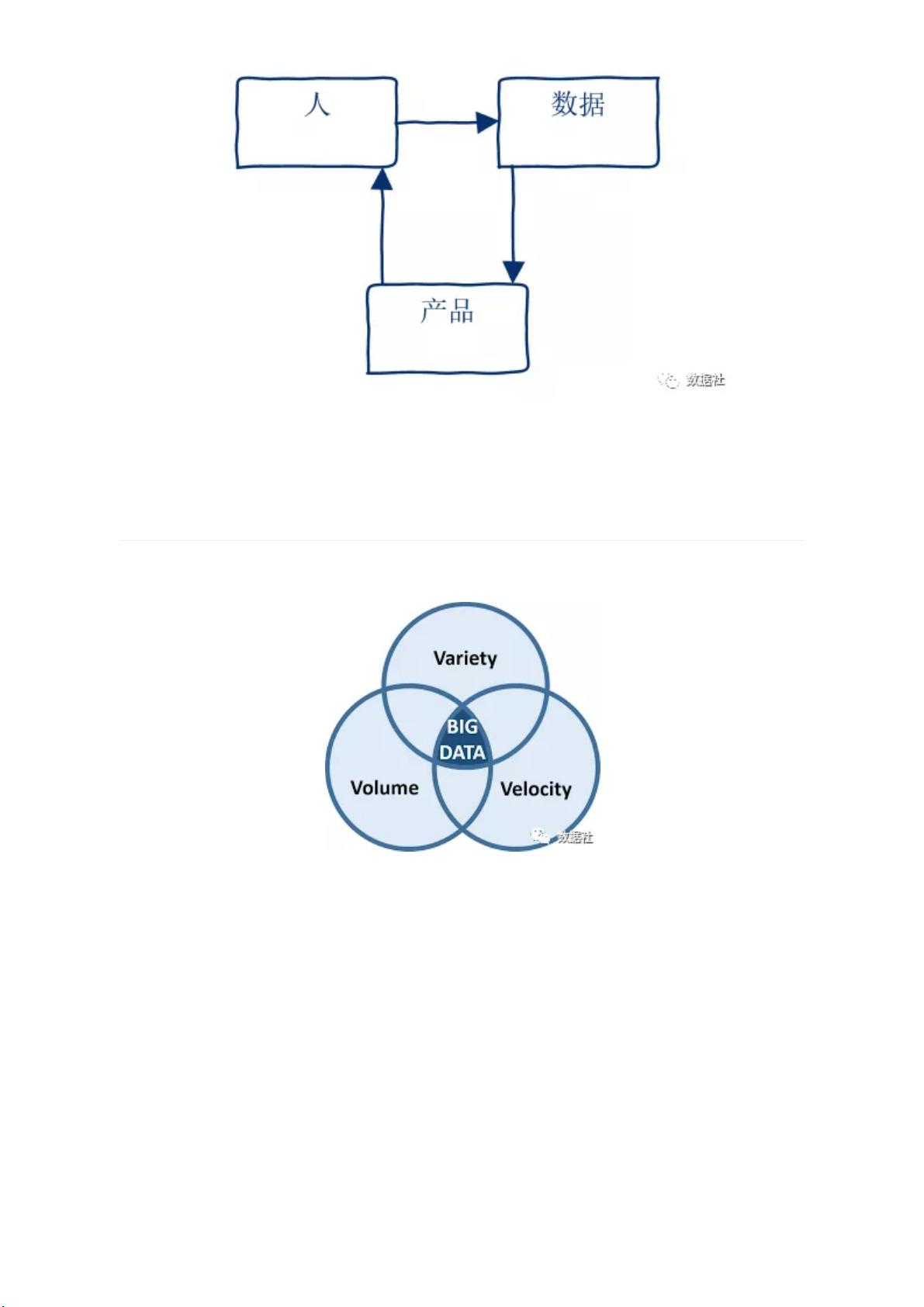

本文档深入探讨了如何从零开始搭建一个完整的大数据平台,共分为五个章节,旨在帮助读者理解大数据平台构建的关键步骤和技术选型。首先,作者概述了大数据平台的一般架构,它包括数据采集、数据存储和数据处理三个主要模块。

在数据采集阶段,文章推荐使用Flume,这是一个开源的日志采集系统,由Cloudera提供,它支持高可用性和分布式处理,能够有效地收集并传输大量行为日志。Flume允许定制数据发送方和接收方,适应不同的数据来源。

数据存储是平台的基础,Hadoop Distributed File System (HDFS) 是首选,它作为分布式计算中的核心存储解决方案,具有高容错、高可靠和高吞吐量的特点。尽管HDFS存储的是非结构化文本,但为了便于后续分析,通常会利用Hive将数据转换为结构化的表,支持类似SQL的查询。

数据处理,即ETL(Extract, Transform, Load),是大数据平台必不可少的环节。文档提到,对于大规模非实时处理,Hive基于MapReduce,以其稳定性和可靠性见长,但处理速度相对较慢。Spark则因其内存驱动的计算模型,理论上速度更快,但也对硬件内存要求较高,可能存在内存溢出问题。Spark兼容Hive的数据源,所以在实际应用中,Hive常作为主要的ETL工具,对于实时性要求不高的场景更为合适,而Spark和其他引擎可以根据具体需求灵活选用。

通过这五篇文章,读者将了解到从零开始搭建大数据平台的具体实践步骤,包括选择合适的工具和技术栈,理解其优缺点,以及如何在实际工作中平衡效率和稳定性。这对于初次接触大数据技术的人员来说,是一份宝贵的入门指南。

145 浏览量

410 浏览量

2025-01-04 上传

2025-01-04 上传

Build前沿

- 粉丝: 1181

- 资源: 2380

最新资源

- hareandhounds:一个基于网络的游戏,称为“野兔和猎犬”

- QTranslate v6.8.0 LITE快速翻译工具

- 茶叶商城(含后端)_history3v6_商城小程序_茶叶商城

- marmot:Marmot工作流程执行引擎

- 国际象棋系统

- 易语言超级列表框取单行列

- civo_cloud_network_test

- api:石灰事件的GraphQL API

- lorentz-force:一种在三维场中模拟磁力对粒子影响的工具

- 修正的摩尔库伦模型_abaqus库伦_abaqus隧道_摩尔库伦模型_abaqus修正摩尔_修正的摩尔库伦三维模型

- 易语言超级列表框动态插入

- appcenter:Liri OS的App Center

- food_app

- pipeline-library

- ticTacToe_js

- java各种javaUntils集成工具类源代码