尚硅谷大数据技术Hive详解

需积分: 16 140 浏览量

更新于2024-07-18

收藏 1.85MB PDF 举报

"大数据之hive笔记"

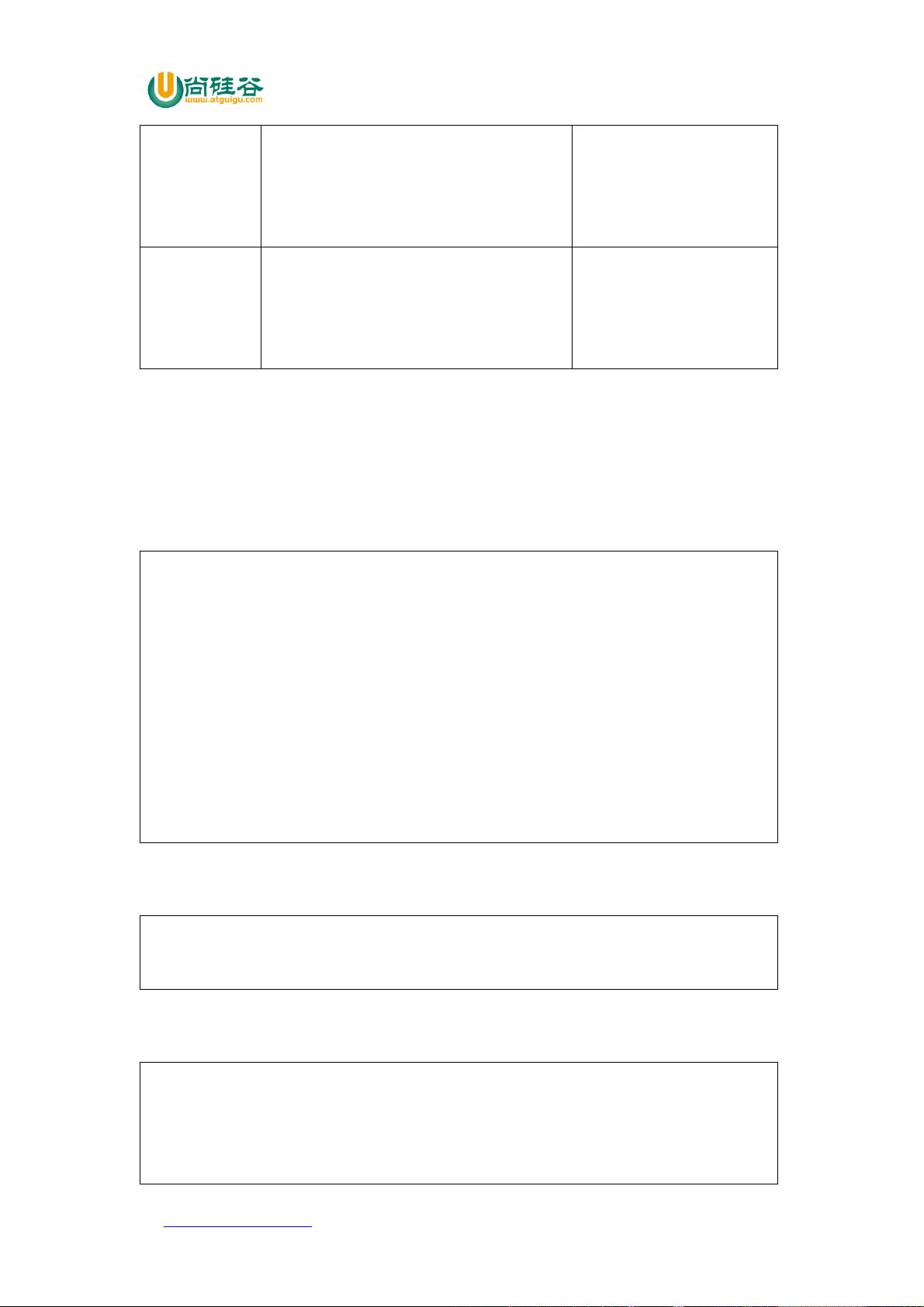

这篇笔记主要介绍了Apache Hive,一个基于Hadoop的数据仓库工具,用于处理和分析大规模的结构化数据。Hive由Facebook开源,它提供了类SQL查询语言(HQL),简化了对存储在HDFS上的大量数据进行分析的过程。

**Hive的基本概念**

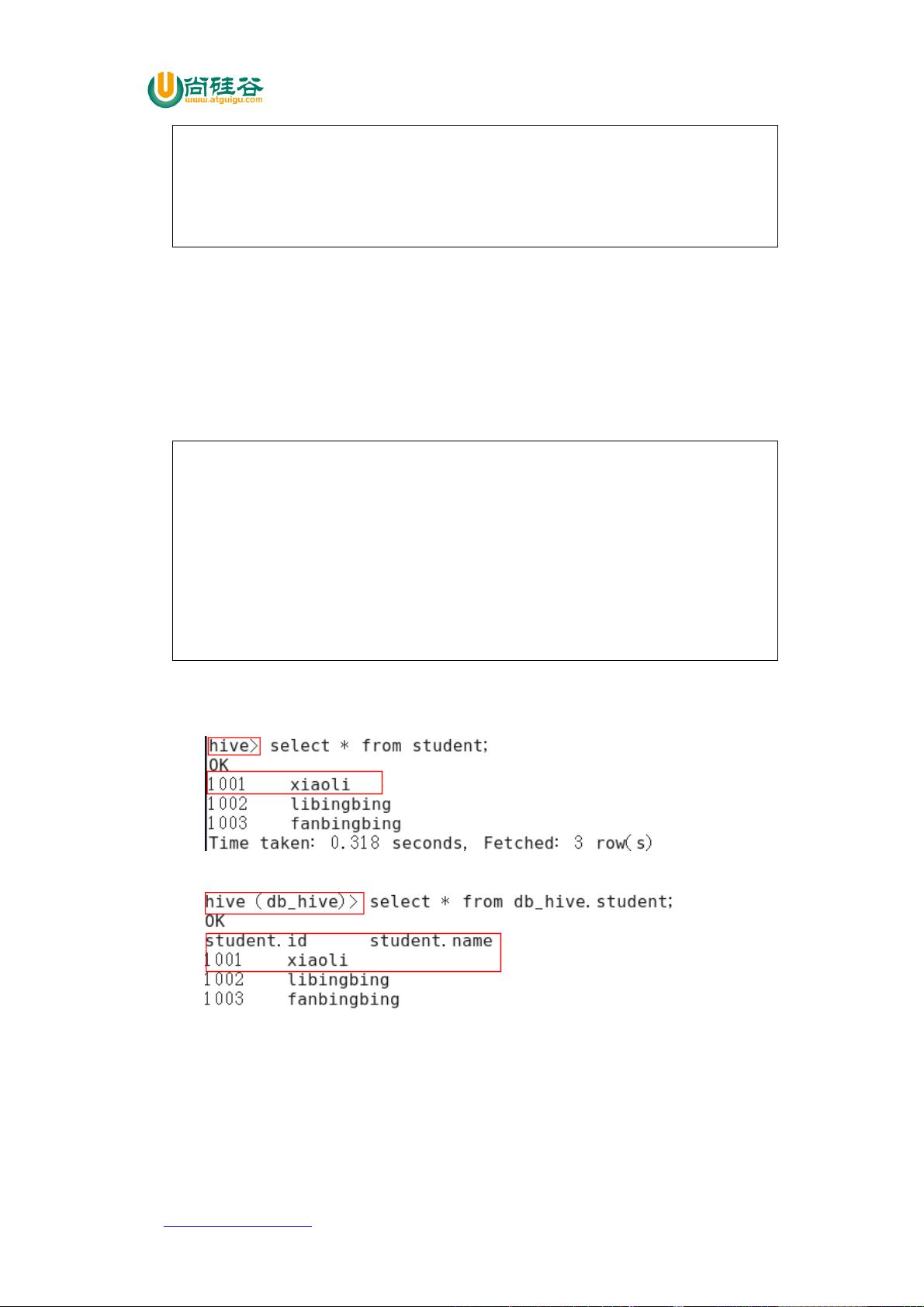

1. **Hive的定义**:Hive是一个数据仓库工具,它将结构化的数据文件映射成数据库中的表,并允许使用SQL-like语句进行查询。实质上,Hive将用户的HQL语句转化为MapReduce任务在Hadoop集群上执行。

2. **数据存储**:Hive处理的数据都存储在HDFS(Hadoop分布式文件系统)中,确保了数据的高可用性和容错性。

3. **执行机制**:Hive的执行层依赖于YARN(Hadoop的资源管理器),负责调度和执行MapReduce作业。

**Hive的优缺点**

1. **优点**

- **易用性**:Hive的SQL接口使得数据分析师无需学习复杂的MapReduce编程即可进行数据分析。

- **降低学习成本**:避免直接编写MapReduce代码,减少了开发人员的学习曲线。

- **适用于大数据处理**:Hive特别适合对大量数据进行离线分析,对实时性要求不高的场景。

- **扩展性**:支持用户自定义函数(UDF),满足多样化的计算需求。

2. **缺点**

- **HQL的局限性**:HQL不能表达迭代式算法,对数据挖掘功能支持有限。

- **效率问题**:Hive生成的MapReduce作业通常效率较低,且优化相对困难。

**Hive架构原理**

Hive的架构包括以下几个核心组件:

- **Parser**:解析器,将用户的SQL语句解析为抽象语法树(AST)。

- **Query Optimizer**:优化器,根据解析后的查询计划进行优化,比如选择最佳的执行路径。

- **Physical Plan**:编译器将优化后的查询计划转化为MapReduce作业的具体执行逻辑。

- **Execution Engine**:执行器,负责在Hadoop集群上执行MapReduce任务。

- **Metastore**:元数据存储,保存表的结构、分区信息等,通常是通过MySQL或Derby等关系型数据库实现。

- **Driver**:驱动程序,协调各个组件的工作,接收客户端请求并返回结果。

- **Clients**:包括CLI(命令行接口)和JDBC/ODBC客户端,提供给用户交互界面。

Hive的设计使得它成为大数据处理领域的一种重要工具,尤其适合于数据仓库和ETL(提取、转换、加载)流程。然而,由于其依赖于MapReduce,所以在实时查询和低延迟场景下,Hive可能不是最佳选择。近年来,Hive也逐步支持Tez和Spark等更高效的执行引擎,以提高查询性能。Hive为大数据分析提供了一个易于使用的、灵活的平台,但同时也需要根据实际需求权衡其优缺点。

2021-09-20 上传

2023-10-27 上传

2021-10-05 上传

2018-09-17 上传

2021-02-03 上传

点击了解资源详情

qmys

- 粉丝: 209

- 资源: 8