"支持向量机学习笔记及Python实战"

需积分: 0 28 浏览量

更新于2024-01-19

收藏 4.23MB PDF 举报

本文是统计学习方法第七章《支持向量机》的笔记。支持向量机(Support Vector Machine, SVM)是一种常用的二分类监督学习方法,其主要思想是在特征空间中找到一个最优超平面,将不同类别的样本分开。SVM最大的特点是可以处理线性可分和线性不可分的情况,并且在处理高维数据时具有较好的效果。

首先,本文介绍了线性可分支持向量机与硬间隔最大化。线性可分支持向量机通过定义函数间隔和几何间隔,将分类问题转化为一个凸二次规划问题,并推导了最大化硬间隔的对偶问题。接着,介绍了学习的对偶算法,即通过求解对偶问题得到最优解。通过引入核技巧,将线性可分支持向量机推广到了非线性情况下。

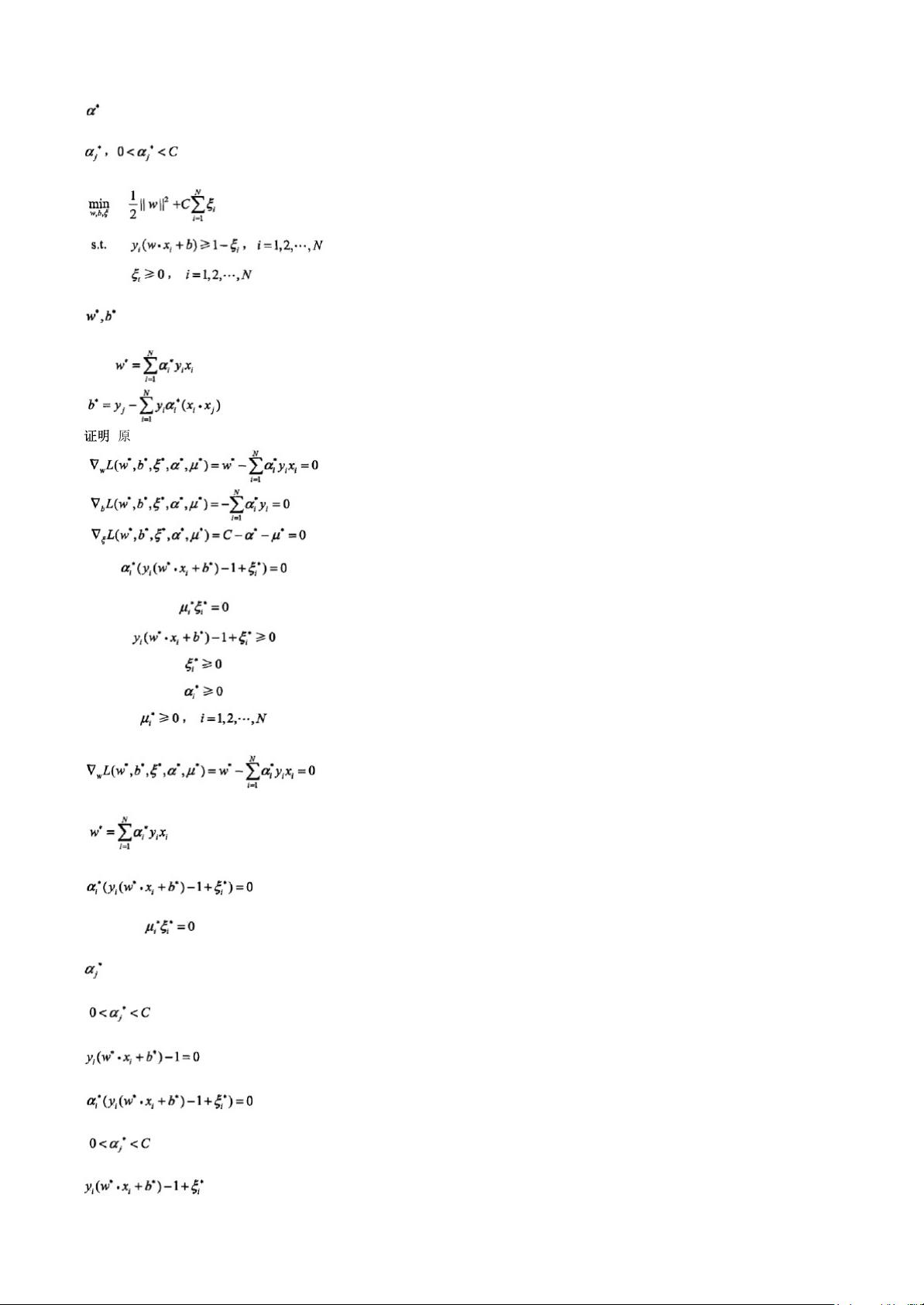

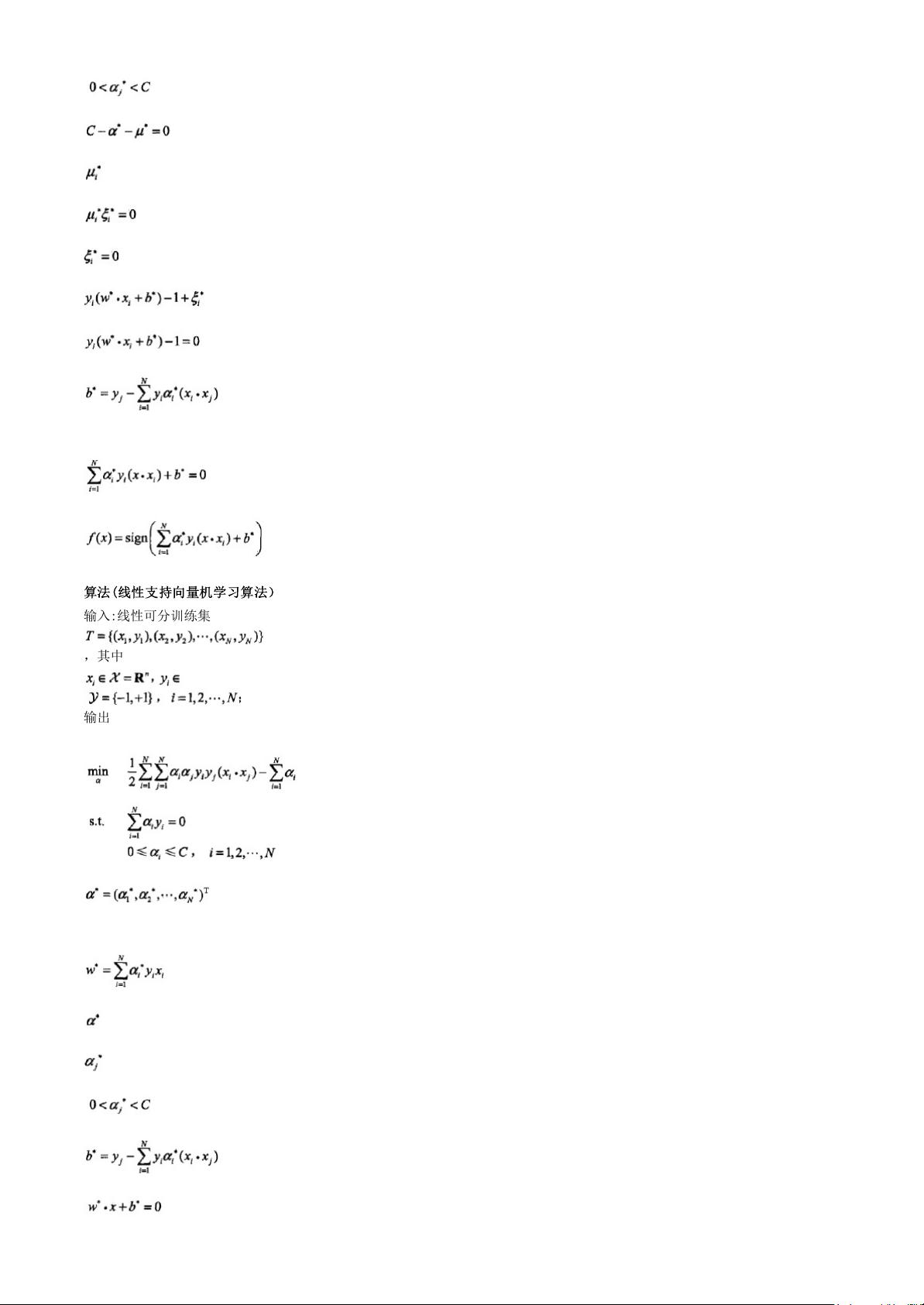

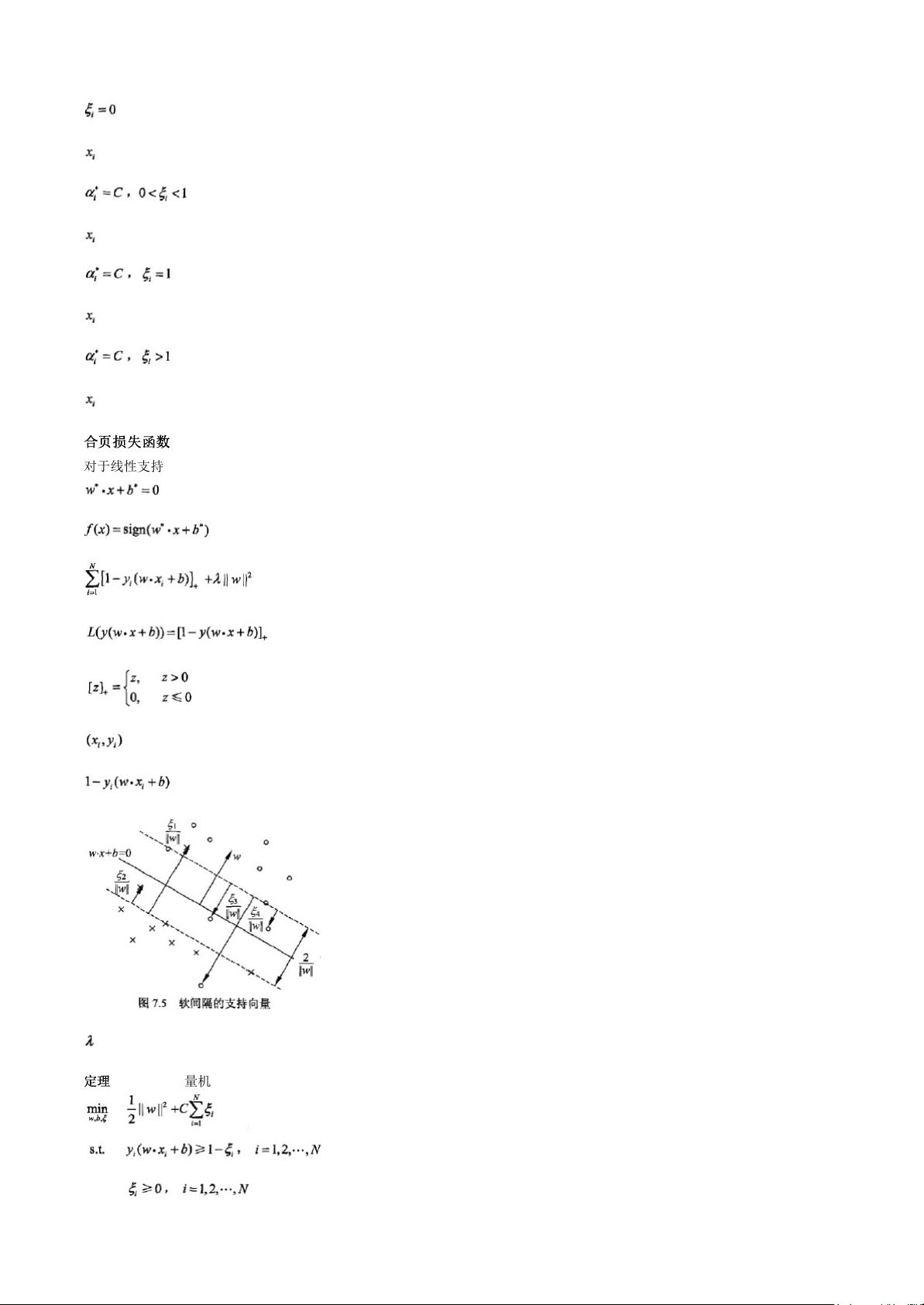

接下来,本文介绍了线性支持向量机与软间隔最大化。当样本数据存在一定的噪音或重叠时,线性可分支持向量机无法直接适用。此时,可以引入松弛变量来容忍一定的错误分类,从而得到线性支持向量机。同样,通过定义函数间隔和几何间隔,并推导了最大化软间隔的对偶问题。

然后,本文介绍了非线性支持向量机与核函数。非线性支持向量机通过引入非线性映射,将样本数据从原始特征空间映射到一个更高维的特征空间,从而使得样本在新的特征空间中变得线性可分。为了简化计算,引入了核函数的概念,通过计算样本间的核函数值来代替映射过程。

接着,本文介绍了序列最小最优化算法(SMO)。SMO算法是求解二次规划问题的一种有效方法,在每次迭代中选择两个变量进行优化,通过更新变量得到最优解。本文分别介绍了SMO算法的简化版和完整版,以及非线性支持向量机中的SMO算法。

最后,本文通过附录的形式介绍了一些背景知识,例如凸二次规划问题、Gram矩阵、希尔伯特空间等,以加深对支持向量机的理解。此外,本文还附带了《机器学习实战》中支持向量机的Python代码,并对代码进行了整理和注释,方便读者理解和实践。

总之,本文全面介绍了支持向量机的原理和算法,并通过注解和补充背景知识的方式,帮助读者更深入地理解支持向量机。通过学习本文,读者可以掌握支持向量机的核心思想和应用方法,并能够利用Python代码实现支持向量机算法。因此,本文对于学习和应用支持向量机的人群具有一定的参考价值。

2018-10-05 上传

地图帝

- 粉丝: 25

- 资源: 297

最新资源

- Windows_Server_2003_R2之文件服务器资源管理器及文件服务器管理

- 基于遗传算法度约束的最小生成树问题的研究

- 基于像素置乱的加密算法的设计

- On Secret Reconstruction in Secret Sharing Schemes

- XORs in the Air: Practical Wireless Network Coding

- Tomcat实用配置

- On Practical Design for Joint Distributed Source and Network Coding

- Efficient Broadcasting Using Network Coding

- C++中extern “C”含义深层探索.doc

- 用PLC实现道路十字路口交通灯的模糊控制

- pragmatic-ajax

- 使用JSP处理用户注册和登陆

- vi Quick Reference

- 华为交换机使用手册quidway

- 在线考试系统论文.doc在线考试系统论文.doc(1).doc

- Linux操作系统下C语言编程

已收录资源合集

已收录资源合集