Scrapy框架学习:安装升级与数据处理

下载需积分: 9 | DOC格式 | 502KB |

更新于2024-09-08

| 139 浏览量 | 举报

"scrapy笔记"

Scrapy是一个强大的Python爬虫框架,用于构建网络爬虫项目。它提供了许多内置功能和组件,简化了爬虫的开发过程。在学习Scrapy的过程中,我们需要注意以下几个关键知识点:

1. **安装与升级**:

使用`pip install --upgrade 库名`来更新第三方库。Scrapy通常会安装在`Scripts`路径下,因为`pip`默认安装在这里。要安装Scrapy,需确保已经安装了Python,并通过`pip install scrapy`命令进行安装。

2. **版本查询**:

要查看Scrapy的版本,可以运行`scrapy version`命令。

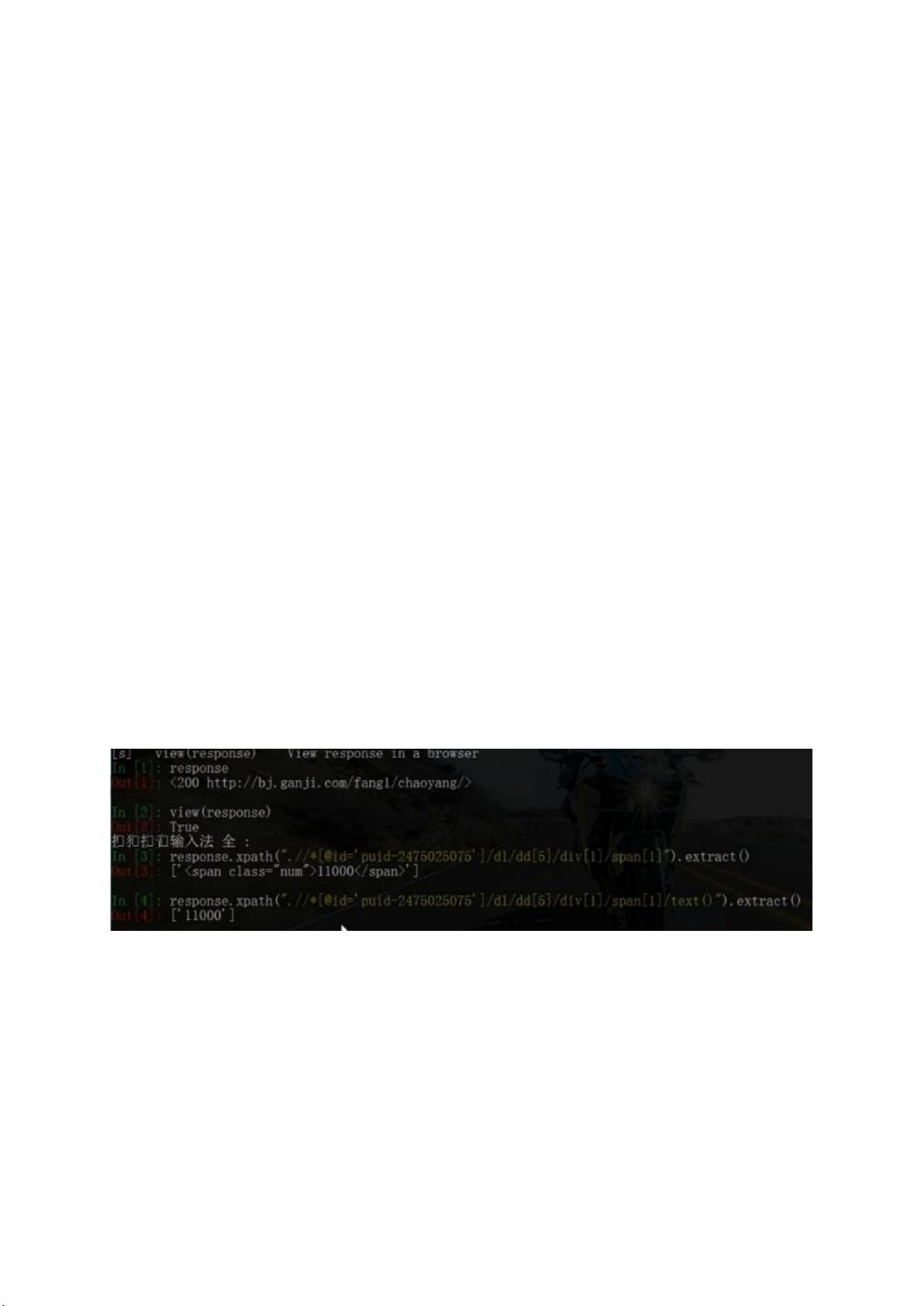

3. **Scrapy Shell**:

`scrapy shell url`命令可以启动Scrapy Shell,这是一个交互式环境,允许你对给定URL的网页内容进行测试和调试。你可以在这个环境中使用XPath或CSS选择器来提取网页数据。

4. **XPath选择器**:

在编写XPath表达式时,如果HTML元素的`class`属性有空格,需要将空格包含在内。例如,`response.xpath('//dl[@class="f-list-item-wrap f-clear"]/dd[1]/a/text()').extract()`这个例子中,类名包含空格,所以必须完整写入。

5. **Scrapy项目创建**:

使用`scrapy startproject 文件夹名`创建一个新的Scrapy项目。在项目结构中的`spiders`目录下,你需要创建Python文件来定义爬虫。

6. **运行爬虫**:

要运行爬虫,可以在命令行环境中使用`scrapy crawl 名字`命令,其中`名字`是Python文件中定义的`name`属性值。

7. **SQLite数据库操作**:

可以通过Python的`sqlite3`模块创建和操作SQLite数据库。例如,`zufang=sqlite3.connect('zufang.sqlite')`连接到数据库,`zufang.execute(zufang_table)`执行SQL语句创建表。但别忘了提交事务,如`self.con.commit()`,以确保数据保存。

8. **PyCharm与SQLite集成**:

如果使用PyCharm,需要安装相应的数据库驱动才能查看SQLite数据库。这可以通过右键点击数据库,选择“Add Database Source”,然后安装驱动来实现。

9. **Scrapy爬虫生成**:

使用`scrapy genspider -t basic dang spddangdang.com`创建一个基于`basic`模板的新爬虫,名为`dang`,目标URL为`dangdang.com`。`scrapy genspider -l`列出所有可用的模板。

10. **爬虫模板**:

`scrapy genspider -t`后面跟模板名称,可以生成特定类型的爬虫。例如,`craw`可能是另一个可用的模板。

在实践中,了解并掌握这些基本操作,能够帮助你高效地利用Scrapy构建和管理网络爬虫项目。此外,理解Scrapy的中间件、管道(pipelines)、请求(requests)和响应(responses)等核心概念,以及如何处理反爬策略,都是成为Scrapy专家的关键。记得在编写爬虫时遵循道德规范,尊重网站的robots.txt文件,合理控制请求频率,以避免被封禁。

相关推荐

qq_22821275

- 粉丝: 0

最新资源

- STM32MP157通用定时器脉冲计数实现与HAL库驱动

- MRTG在Windows下的安装与网络流量监控指南

- PAVT开源项目:编译器构造教学可视化工具

- 登录页设计:美观弹出框与JavaScript验证技巧

- 美观大方的HTML产品介绍网站模板

- php&mysql应用验证:初学者的分数验证系统

- iOS高颜值图片浏览器及其动画效果

- 深入探究内容管理系统(CMS)的HTML应用

- 深入解析网页访问模块的技术实现与应用

- C# Task实现多线程管理与任务控制技巧

- Trinity3:基于Flask的开源MVC内容管理系统

- 360网盘3.30版本发布:简单易用的个人云存储

- iOS代码生成器:将工程高效转化为纯手写代码

- 网页访问模块压缩包内容及功能解析

- 深入解析SGGO:第二学年第二学期EDP项目

- Reddit WatchExchange扩展:WatchCharts For Reddit