AdaBoost算法详解与训练误差深度剖析

AdaBoost是一种集成学习方法,由 Yoav Freund 和 Robert Schapire 在1995年提出,主要用于提升分类器的性能。它通过组合一系列简单的弱分类器来形成一个强大的分类器,特别适合处理高维度、噪声数据以及不平衡数据集。

一、AdaBoost简介

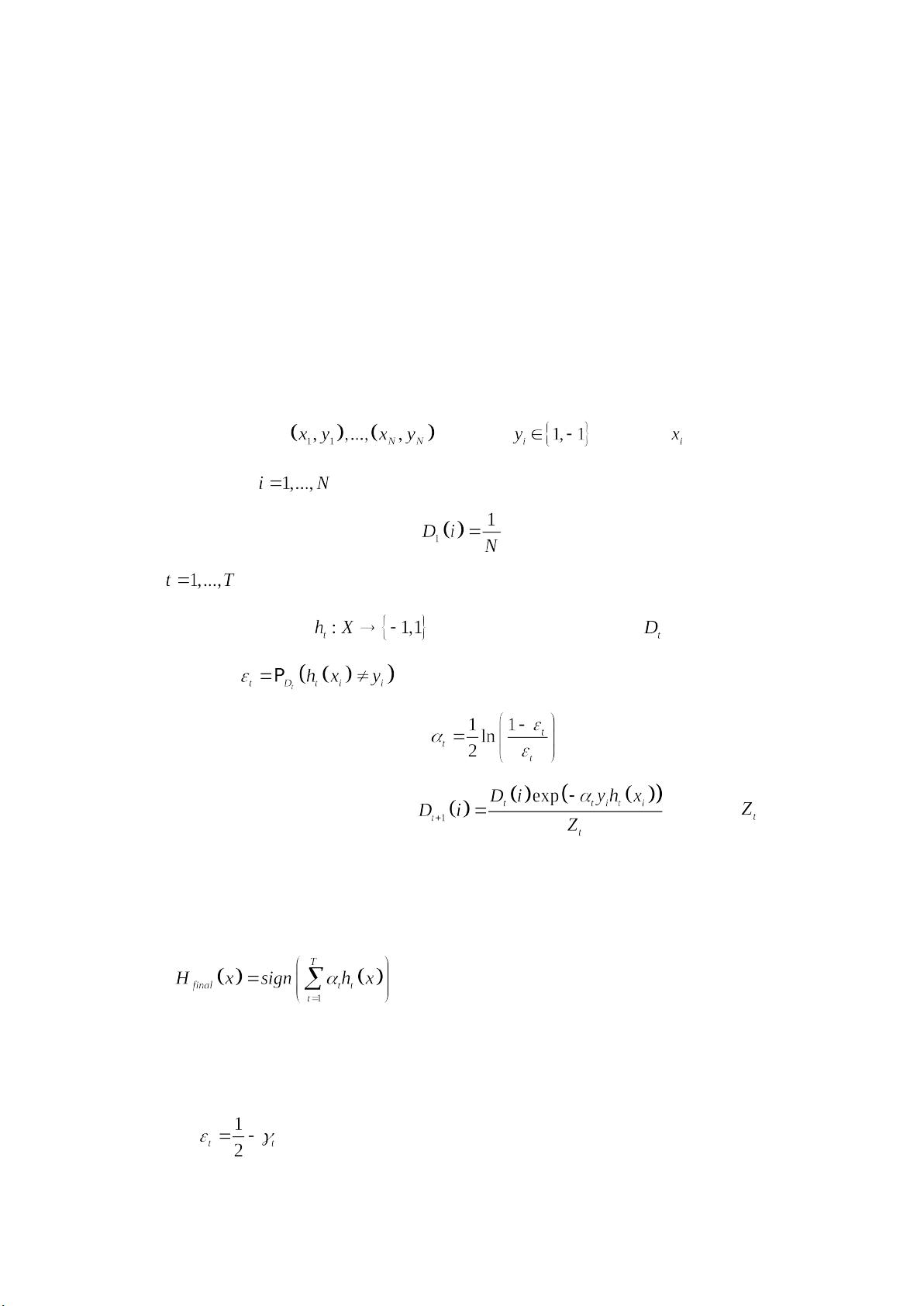

AdaBoost的核心思想是迭代地训练一系列弱分类器,并赋予它们不同的权重,使得最终的分类结果是由这些弱分类器的加权多数决定。训练开始时,所有样本的初始权重相等,然后对每个弱分类器进行训练,优先关注那些被先前分类错误的样本。弱分类器的性能较差,但通过加权的方式,即使单个弱分类器的准确率不高,组合起来也能形成有效的分类器。

二、训练误差分析

1. 计算弱分类器的误差与权重:对于一个弱分类器 \( h \),在分布 \( D_t \) 上的误分类误差为 \( E(h,D_t) \)。根据算法流程,弱分类器 \( h_i \) 的权重 \( w_i \) 与其在当前分布下的错误率成反比,即 \( w_i = \frac{1}{2E(h_i,D_t)} \)。通过这种分配方式,误差小的弱分类器会被赋予更大的权重。

2. 强化学习过程:最终的强分类器 \( H \) 是所有弱分类器的加权和,即 \( H(x) = \sum_{i=1}^T w_i h_i(x) \)。训练误差 \( E(H,D) \) 可以用弱分类器的错误率来近似,因为每个弱分类器的错误率总是小于0.5,所以训练误差 \( E(H,D) \leq 0.5 - \frac{1}{2}\sum_{i=1}^T w_i E(h_i,D_t) \)。

3. 贪心选择策略:AdaBoost采用一种贪心策略,每次选择一个错误率最低的弱分类器,这样可以尽可能地减小训练误差。这类似于特征选择中的前向逐步法,但更侧重于优化错误率而非所有特征。

4. 分类器权重与错误率的关系:随着训练的进行,错误率较低的弱分类器 \( h \) 的权重 \( w_h \) 较大,这是因为它们在调整样本分布上更有影响力。当 \( E(h,D_t) \) 很小,即 \( h \) 对 \( D_t \) 的区分能力很强,对应的 \( w_h \) 就会很大,这样有助于提高整体分类器的性能。

5. 训练误差的表达与优化:训练误差 \( E(H,D) \) 反映了模型在训练数据上的表现,优化目标是找到一组弱分类器,使得 \( \sum_{i=1}^T w_i E(h_i,D_t) \) 最小。在AdaBoost中,这相当于最小化指数风险,即经验风险。

总结,AdaBoost是一种利用弱分类器组合提升性能的算法,通过迭代训练和权重分配,能够有效地处理复杂数据集和不平衡数据。其核心在于训练误差分析,通过优化每个弱分类器的选择和权重分配,最终达到提高分类准确性的目的。

2018-06-06 上传

点击了解资源详情

2010-01-15 上传

2012-10-30 上传

2022-07-02 上传

2019-12-26 上传

2021-05-16 上传

ZJW_Gavin

- 粉丝: 0

- 资源: 1

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载