Kettle ETL工具详细使用指南

需积分: 10 67 浏览量

更新于2024-07-24

收藏 1008KB DOC 举报

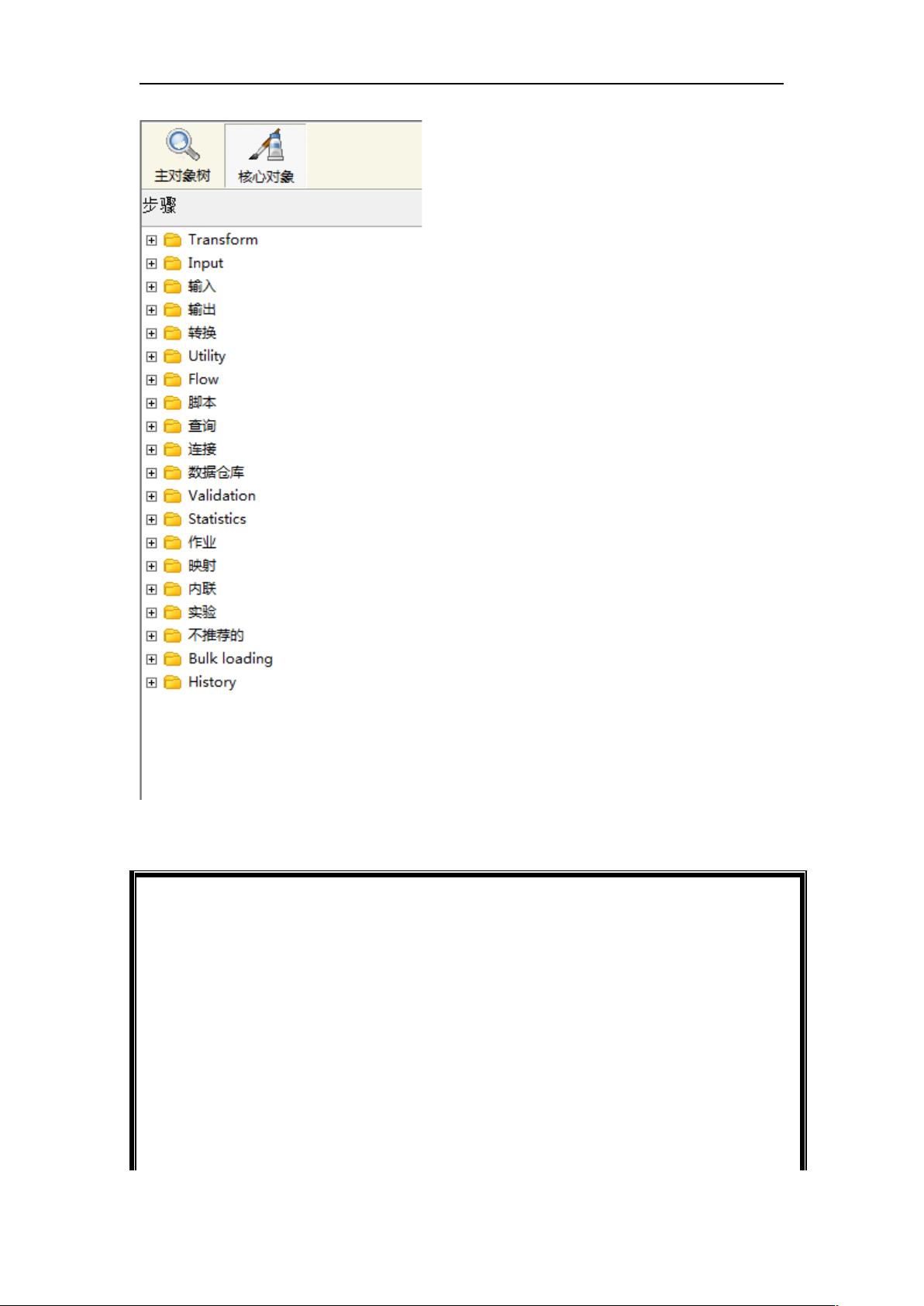

"Kettle ETL 工具是用于数据抽取、转换和装载的开源软件,由JAVA编写,提供高效稳定的数据处理能力。适用于Window、Linux、Unix等多种操作系统环境,需要Jdk1.4以上的版本支持。用户可以从官方网站http://kettle.pentaho.org/下载并直接解压使用。Spoon是其图形用户界面,通过Spoon.bat或Spoon.sh在不同平台运行。Kettle中的转换(Transformation)和作业(Job)是核心概念,前者负责数据基础转换,后者负责整体工作流程控制。转换文件以.ktr为扩展名,可以创建数据库连接,并通过核心对象中的各种节点进行数据处理,包括输入和输出节点,如文本文件输入、表输入、表输出、插入/更新等。"

在深入探讨Kettle ETL工具的知识点之前,我们首先理解ETL过程。ETL是数据仓库和商业智能(BI)领域的重要组成部分,它负责从多个异构数据源中抽取数据,经过清洗、转换,然后加载到目标数据存储,如数据仓库或数据湖。

Kettle作为一款强大的ETL工具,其特点在于:

1. **跨平台兼容性**:由于Kettle是用Java编写的,因此它能够在多种操作系统上运行,包括Windows、Linux和Unix。

2. **用户友好的图形界面**:Spoon是Kettle的图形化开发工具,允许用户通过拖拽方式构建数据转换和工作流程,降低了学习和使用的门槛。

3. **数据库连接管理**:Kettle支持创建和管理多种类型的数据库连接,确保了数据抽取和装载的灵活性。

4. **转换(Transformation)与作业(Job)**:

- **转换**:是Kettle中的基本单元,包含一系列数据处理步骤,每个步骤称为“环节”(Step)。环节之间可以通过线进行连接,表示数据流动的方向。

- **作业**:负责协调多个转换,可以控制转换的执行顺序、条件和错误处理,形成复杂的工作流程。

5. **核心对象与节点**:Kettle提供了丰富的核心对象,包括输入、输出、过滤和转换节点。例如:

- **输入节点**:如文本文件输入和表输入,用于从文件或数据库中读取数据。

- **输出节点**:如文本文件输出和表输出,用于将处理后的数据写入文件或数据库。

- **其他节点**:如获取系统信息,可以获取系统级别的信息;插入/更新和更新节点则用于对数据库进行增删改操作。

6. **数据转换逻辑**:Kettle允许用户自定义数据清洗和转换规则,如字段映射、数据类型转换、数据过滤等,满足各种复杂的数据处理需求。

7. **性能优化**:Kettle以其高效的数据处理而著称,支持并行处理和内存优化,使得大规模数据处理成为可能。

8. **版本控制与资源库**:Kettle支持版本控制,可以通过资源库管理转换和作业,便于团队协作和项目管理。

9. **插件扩展**:Kettle拥有丰富的插件生态系统,允许开发者扩展其功能,适应更多的数据源和特定需求。

10. **社区支持**:作为开源项目,Kettle有一个活跃的社区,提供文档、论坛和技术支持,帮助用户解决问题和分享经验。

Kettle ETL工具以其强大的功能、灵活性和易用性在数据集成领域占据重要位置,无论是小型项目还是大型企业级应用,都可以借助Kettle实现高效的数据管理和分析。通过熟练掌握Kettle,数据工程师能够构建出高效、可靠的ETL流程,为企业的数据分析和决策支持提供坚实的基础。

379 浏览量

1493 浏览量

138 浏览量

159 浏览量

点击了解资源详情

点击了解资源详情

134 浏览量

点击了解资源详情

188 浏览量

cq_cq2009

- 粉丝: 1

最新资源

- Matlab遗传算法工具箱使用指南

- 探索《黑暗王国》:自由编辑的纯文字RPG冒险

- 深入掌握ASP.NET:基础知识、应用实例与开发技巧

- 新型V_2控制策略在Buck变换器中的应用研究

- 多平台手机wap网站模板下载:全面技术项目源码

- 掌握数学建模:32种常规算法深入解析

- 快速启动Angular项目的AMD构建框架:Angular-Require-Kickstart

- 西门子S71200 PLC编程:无需OPC的DB数据读取

- Java Jad反编译器配置教程与运行指南

- SQLiteSpy:探索轻量级数据库管理工具

- VS版本转换工具:实现高至低版本项目迁移

- Vue-Access-Control:实现细粒度前端权限管理

- V_2控制策略下的BUCK变换器建模与优化研究

- 易语言实现的吉普赛读心术源码揭秘

- Fintech Hackathon: 解决HTTP GET私有库文件获取问题

- 手把手教你创建MAYA2008材质库Shader Library