Kettle入门教程:从零到精通

需积分: 15 28 浏览量

更新于2024-07-22

收藏 3.7MB PDF 举报

"Kettle从零开始系列教程涵盖了Kettle的基本概念、操作界面、数据源配置、数据抽取、常用组件、作业流程、组件介绍、变量参数传递、定时任务、运行日志、性能优化以及在Linux环境下的部署。教程旨在帮助初学者系统地了解和掌握这款强大的ETL工具。"

Kettle是一款强大的开源数据集成工具,全称为Pentaho Data Integration,由Java语言编写,支持多平台运行,并且无需安装。它提供了两种工程存储方式:XML和资源库,便于管理和共享ETL项目。Kettle的核心概念分为Transformation和Job。Transformation专注于数据处理,包括清洗、转换和加载;而Job则负责工作流程的调度和管理。

在Kettle中,Spoon是一个图形化界面工具,用户可以通过它直观地设计、测试和运行Transformation和Job。Pan和Kitchen则是命令行工具,Pan用于执行Transformation,Kitchen用于执行Job,尤其适用于自动化任务和定时调度。

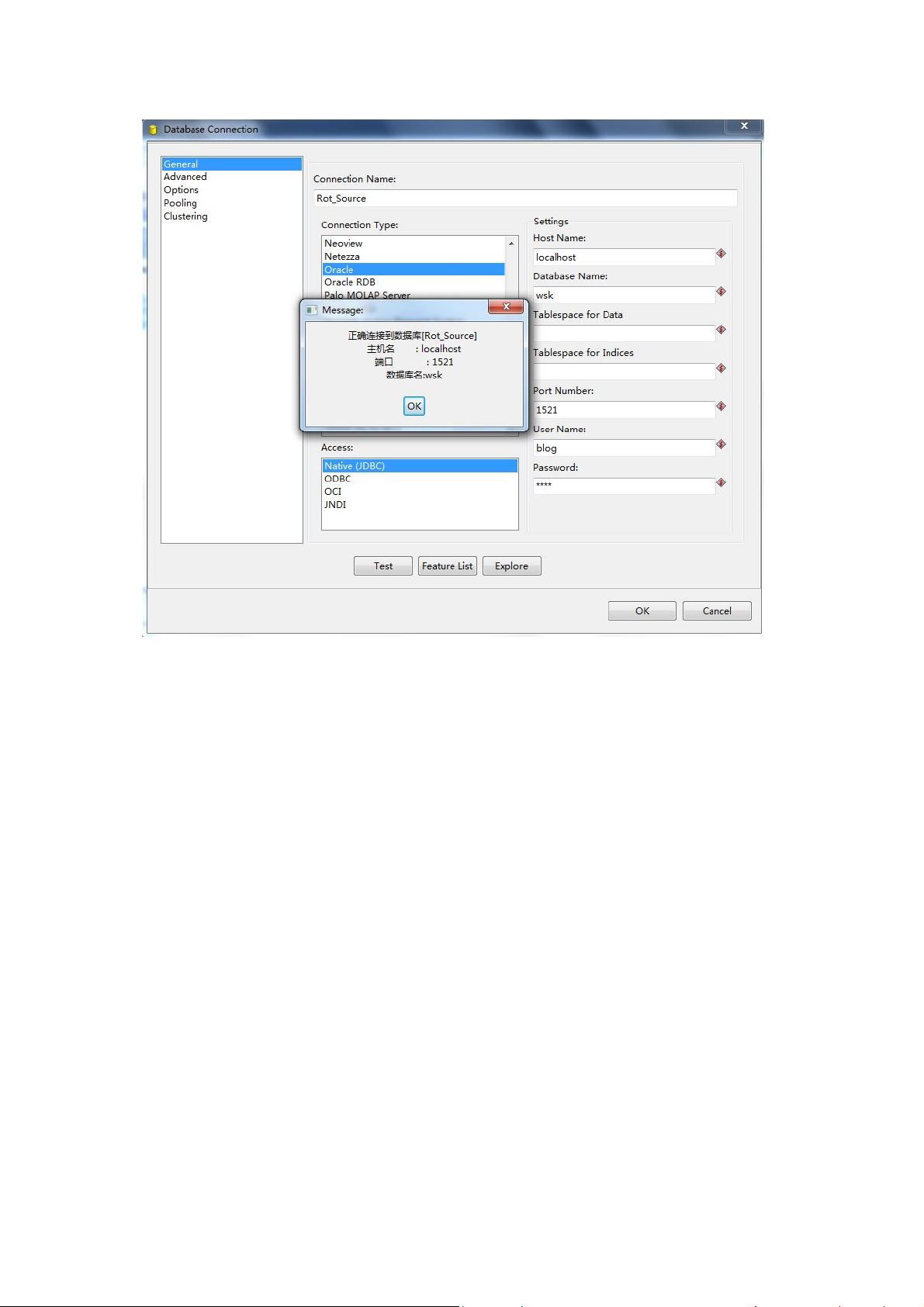

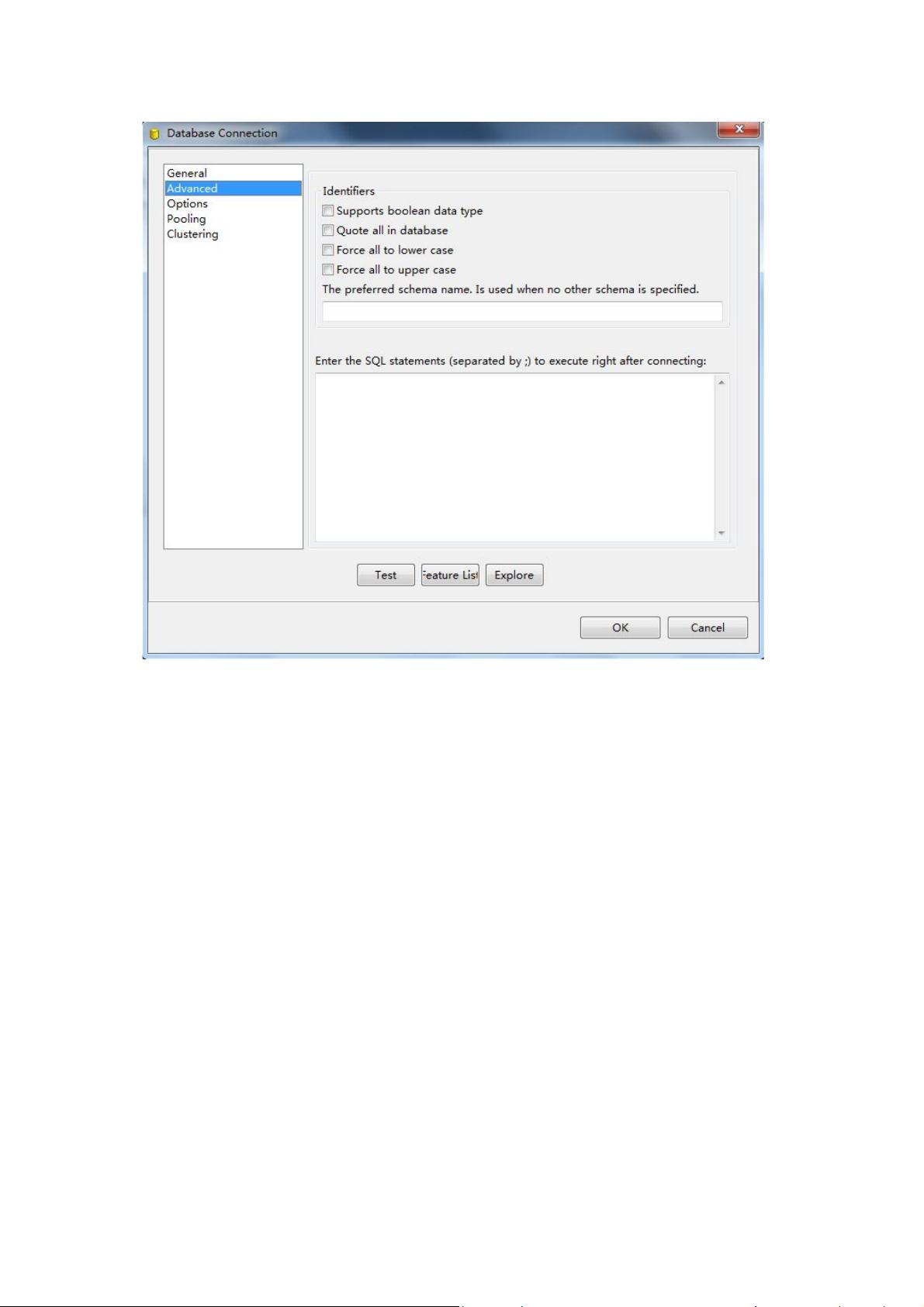

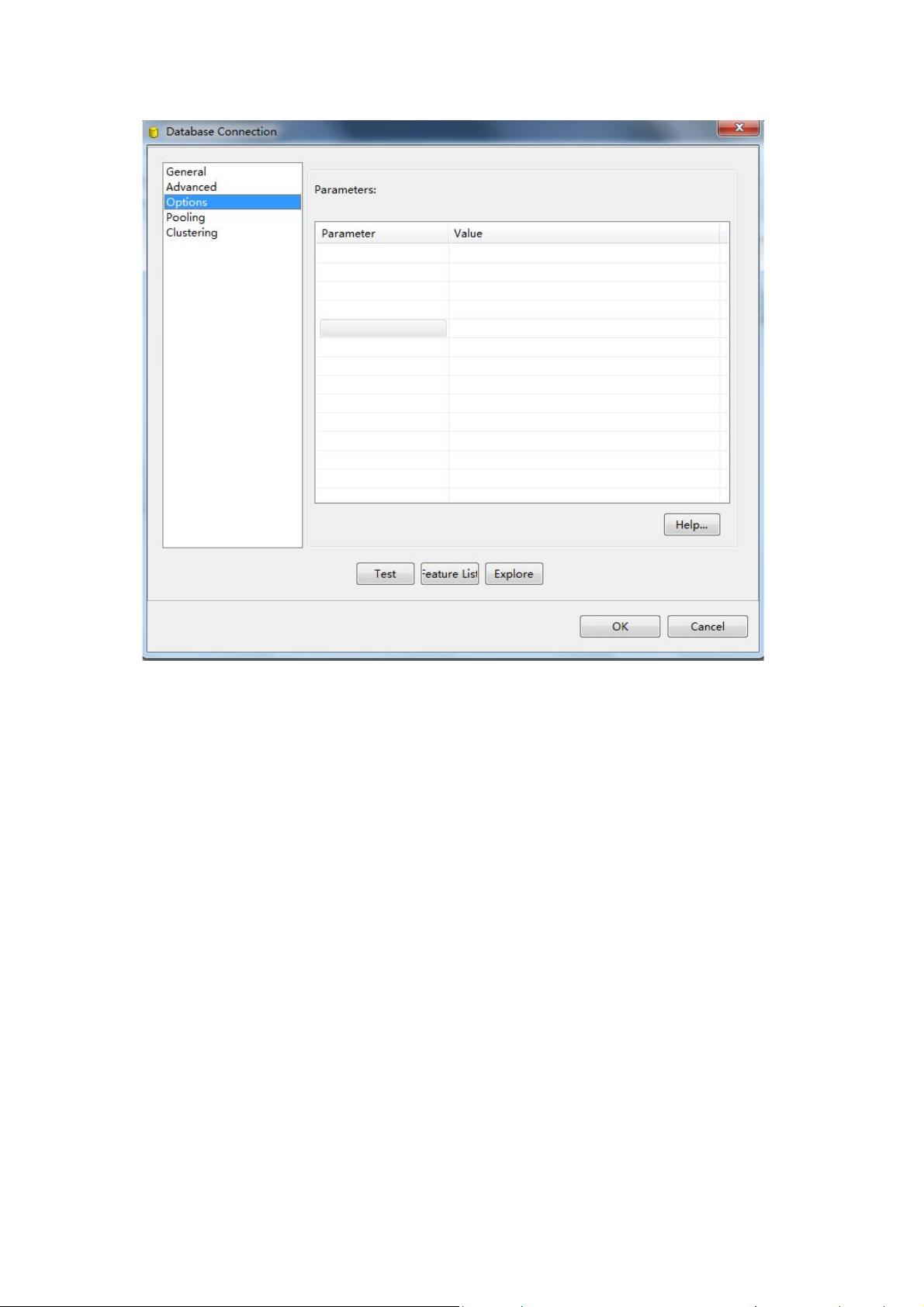

Kettle拥有丰富的数据源连接配置能力,能处理各种类型的数据,如数据库、文件、Web服务等。在数据抽取方面,Kettle提供了多种预定义的步骤(Steps),如读取、写入、过滤、转换等,用户可以根据需求组合这些步骤实现复杂的数据处理逻辑。

在实际应用中,Kettle的组件选择非常关键。每个组件都有其特定的功能,比如数据输入/输出步骤、数据转换步骤、控制流程步骤等。详细的组件使用方法可以在Pentaho Data Integration Steps的官方Wiki上找到,这对于深入理解和使用Kettle至关重要。

Kettle还提供了变量和参数传递功能,使得在不同Transformation或Job之间可以灵活地传递信息。同时,它内置了定时任务管理,可以配合Kitchen执行定期的数据处理工作。此外,Kettle的运行日志记录功能有助于监控和调试,确保ETL过程的稳定性和可追溯性。

对于性能调优,Kettle提供了多种手段,包括并行处理、内存管理、优化步骤配置等,以提高数据处理效率。对于大型企业,Kettle还提供企业版,包含更多高级特性和服务支持。

最后,Kettle在Linux环境下的部署和使用同样简便,适应于服务器环境的需求,保证了ETL任务的稳定运行。

通过这个“Kettle从零开始”的系列教程,读者将能够逐步学习并掌握Kettle的各项功能,从而在数据集成和ETL过程中发挥其强大潜力。同时,官方的Spoon User Guide文档也是学习Kettle操作和高级特性的宝贵资源。

2018-04-30 上传

2018-01-08 上传

2014-03-11 上传

2022-12-25 上传

2017-07-12 上传

2020-09-21 上传

2019-03-18 上传

2020-08-21 上传

欧参谋

- 粉丝: 0

- 资源: 1

最新资源

- OO Principles.doc

- Keil C51程序设计中几种精确延时方法.doc

- 基于单片机的智能遥控小汽车

- 利用asp.net Ajax和sqlserver2005实现电子邮件系统

- 校友会网站需求说明书

- Microsoft Windows Internals (原版PDF)

- 软件测试工具的简单介绍

- 2009年上半年软件评测师下午题

- 2009年上半年软件评测师上午题

- linux编程从入门到提高-国外经典教材

- 2009年上半年网络管理员下午题

- 2009年上半年系统集成项目管理师下午题

- 2009年上半年系统集成项目管理师上午题

- 数据库有关的中英文翻译

- 2009年上半年系统分析师下午题II

- 2009年上半年系统分析师上午题