Flink实时流处理安全认证与运行教程

需积分: 0 61 浏览量

更新于2024-08-04

收藏 504KB DOCX 举报

"该资源提供了一份关于实时流处理系统Flink的样例代码运行步骤,主要涉及环境准备、代码修改、打包与启动等关键环节,适用于具有Hadoop、Java背景的开发者,尤其关注Flink的安全认证配置。"

在实时流处理领域,Apache Flink是一个强大的开源框架,它支持事件时间处理和低延迟的数据流处理。本示例代码运行步骤旨在指导用户在已配置好Flink安全认证的环境中执行实时流处理任务。首先,我们需要按照Flink开发指南的环境准备部分进行操作,特别是关于安全认证的部分。

1. **环境准备**:

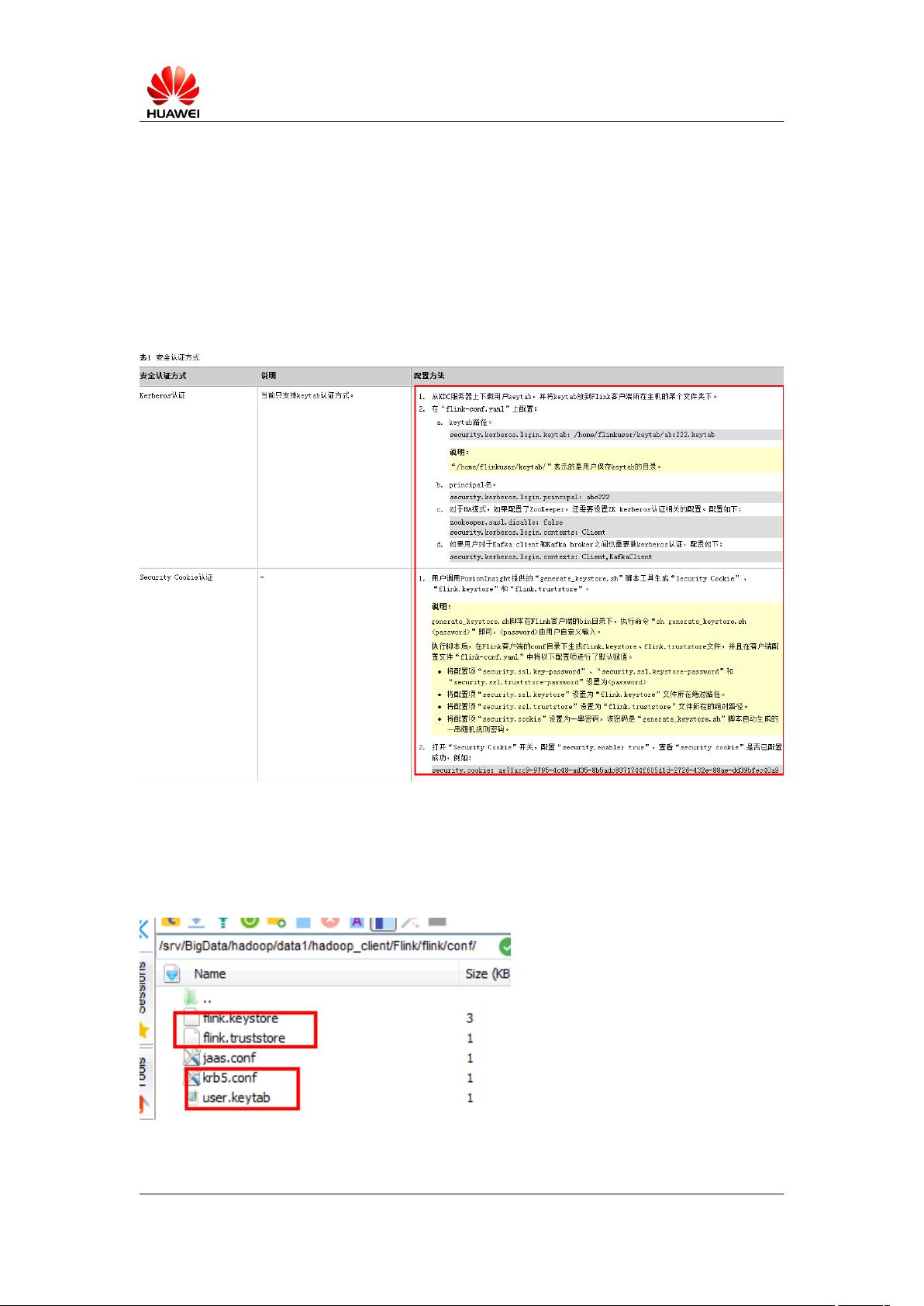

- 在Flink客户端的`conf`目录下,添加keystore、truststore以及User.keytab和krb5.conf文件。这些文件用于Flink的安全认证,keystore和truststore是Java的加密证书存储,User.keytab是Kerberos的身份验证令牌,krb5.conf是Kerberos的配置文件。

- 检查Flink客户端`lib`目录,确保包含必要的jar包,尤其是来自FusionInsightHD客户端的特定jar包,这些包对于与FusionInsightHD集成和进行安全认证至关重要。

2. **修改代码**:

- 对于`ProcessDataAndSinkToRedis`类,需更新Redis的安全认证信息,即User.keytab和krb5.conf的路径,应设置为上一步中文件的实际相对路径。这使得Flink能够使用Kerberos进行身份验证,安全地连接到Redis。

- 修改`Const`接口,设置Redis集群的IP和PORT信息,确保与实际环境匹配,以便正确地将数据流发送到Redis。

3. **打包**:

- 按照Flink开发指南,将修改后的代码打包成jar文件,上传到指定目录(如`/opt/fwc/`)。

4. **启动运行程序**:

- 首先,启动Flink集群。使用`bin/yarn-session.sh`命令,指定配置文件路径(`-tconf`),并设置任务管理器的节点数和内存分配。

- 然后,通过`flinkrun`命令启动`ProcessDataAndSinkToRedis`类,提供相关参数如Kafka主题、服务器地址、安全协议和Kerberos服务名称。

- 同样的,启动`WriteIntoKafka`类,指定输入主题、Kafka服务器地址以及其他必要参数。

这些步骤详细地描述了如何在一个需要安全认证的环境中运行基于Flink的实时流处理应用。确保每个步骤都正确执行,对于避免认证失败和其他潜在问题至关重要。此外,了解和理解Flink的安全模型以及Kerberos等认证机制也是成功部署的关键。在实际操作中,可能还需要根据具体的集群配置和安全策略进行适当的调整。

2011-03-05 上传

2021-09-20 上传

2010-07-23 上传

2023-07-28 上传

2023-09-06 上传

2023-06-13 上传

2023-08-17 上传

2023-08-27 上传

2023-07-09 上传

老许的花开

- 粉丝: 33

- 资源: 328

最新资源

- C++ Qt影院票务系统源码发布,代码稳定,高分毕业设计首选

- 纯CSS3实现逼真火焰手提灯动画效果

- Java编程基础课后练习答案解析

- typescript-atomizer: Atom 插件实现 TypeScript 语言与工具支持

- 51单片机项目源码分享:课程设计与毕设实践

- Qt画图程序实战:多文档与单文档示例解析

- 全屏H5圆圈缩放矩阵动画背景特效实现

- C#实现的手机触摸板服务端应用

- 数据结构与算法学习资源压缩包介绍

- stream-notifier: 简化Node.js流错误与成功通知方案

- 网页表格选择导出Excel的jQuery实例教程

- Prj19购物车系统项目压缩包解析

- 数据结构与算法学习实践指南

- Qt5实现A*寻路算法:结合C++和GUI

- terser-brunch:现代JavaScript文件压缩工具

- 掌握Power BI导出明细数据的操作指南

已收录资源合集

已收录资源合集