PyTorch实现LSTM模型:优化记忆,理解门结构

需积分: 0 48 浏览量

更新于2024-08-05

收藏 358KB PDF 举报

"本文主要介绍了基于PyTorch实现的LSTM模型,探讨了LSTM在处理序列数据,尤其是自然语言处理中的优势。通过引入门控机制,LSTM解决了传统RNN的长期依赖问题,提高了对信息的记忆和处理能力。文中还提到了模型的实现步骤,包括数据预处理和模型构建等环节。"

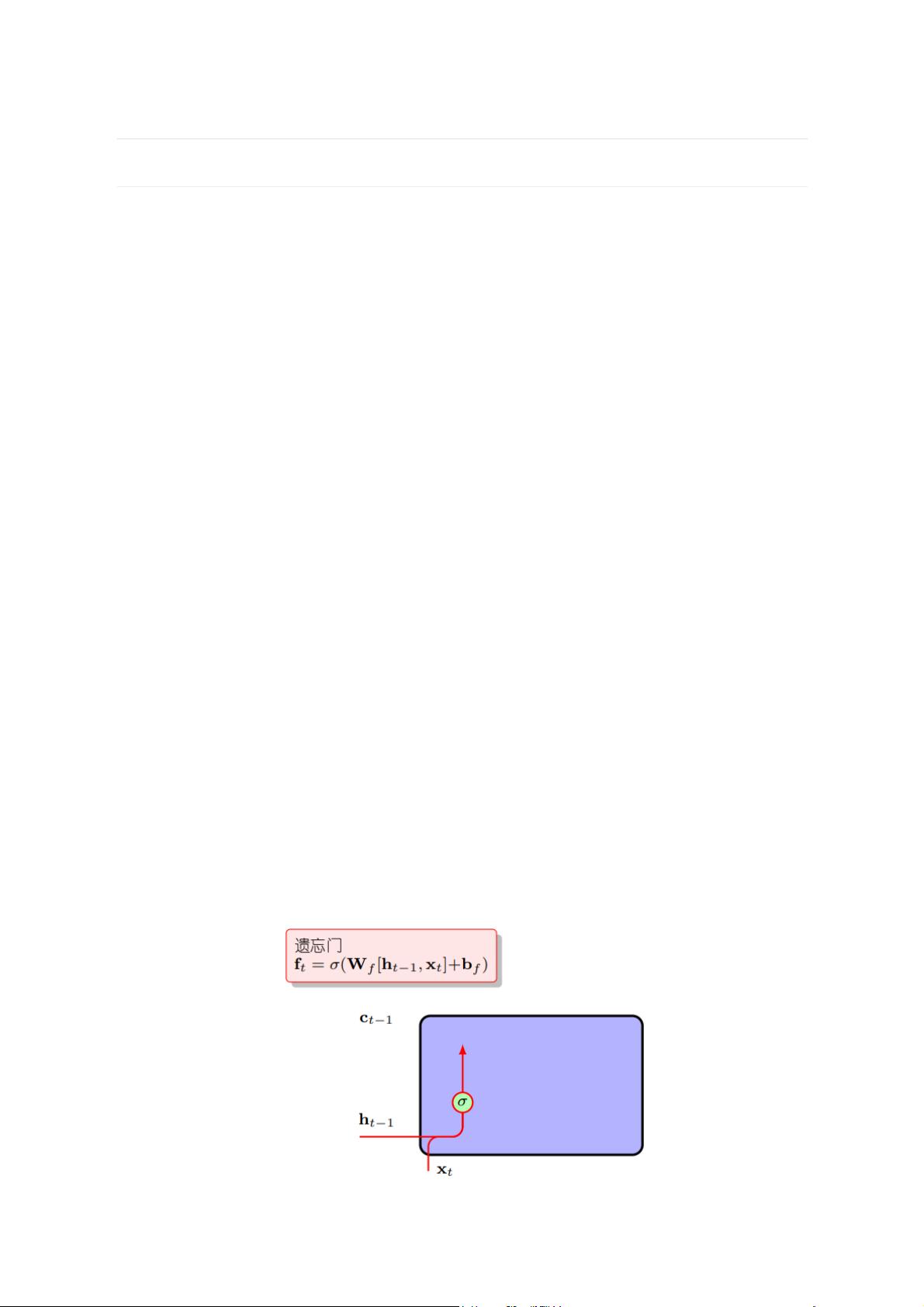

基于PyTorch的LSTM模型实现,首先需要理解LSTM模型的基本原理。LSTM全称为长短期记忆网络,它是循环神经网络(RNN)的一种变体,旨在解决标准RNN在处理长序列数据时面临的梯度消失和梯度爆炸问题。传统的RNN虽然能捕捉时间序列中的依赖关系,但其记忆能力有限,容易遗忘远期信息。LSTM通过引入“门”结构,即遗忘门、输入门和输出门,使得网络能够有选择性地记住或忘记信息,从而更好地处理长期依赖。

遗忘门允许LSTM决定保留或丢弃旧状态中的哪些信息,输入门则控制新信息如何融入当前状态。输出门决定了当前时间步的输出应基于哪些内部状态。这种门控机制使得LSTM在处理如自然语言这样的序列数据时,能更好地捕捉上下文关系,尤其适合于文本分类、机器翻译等任务。

在实现LSTM模型的过程中,首先需要进行数据预处理,包括清洗、分词、编码等步骤,将原始文本转化为适合模型输入的格式。接着,构建LSTM模型,定义网络架构,包括输入层、LSTM层、全连接层以及损失函数和优化器。在PyTorch中,可以使用torch.nn模块方便地搭建LSTM模型。模型训练阶段,通过反向传播更新权重,并在验证集上监控模型性能,防止过拟合。

此外,还可以对LSTM进行扩展,例如堆叠多层LSTM以增强模型的表达能力,或者使用双向LSTM同时考虑序列的前向和后向信息。在实际应用中,还可以结合注意力机制或其他技术,进一步提高模型在特定任务上的性能。

LSTM通过其独特的门控机制,解决了RNN在处理长序列数据时的局限性,成为自然语言处理领域广泛应用的模型。利用PyTorch这一强大的深度学习框架,我们可以方便地实现和优化LSTM模型,应用于各种序列数据相关的任务。

223 浏览量

548 浏览量

367 浏览量

2025-01-24 上传

156 浏览量

508 浏览量

134 浏览量

548 浏览量

乔木Leo

- 粉丝: 32

最新资源

- C语言实现LED灯控制的源码教程及使用说明

- zxingdemo实现高效条形码扫描技术解析

- Android项目实践:RecyclerView与Grid View的高效布局

- .NET分层架构的优势与实战应用

- Unity中实现百度人脸识别登录教程

- 解决ListView和ViewPager及TabHost的触摸冲突

- 轻松实现ASP购物车功能的源码及数据库下载

- 电脑刷新慢的快速解决方法

- Condor Framework: 构建高性能Node.js GRPC服务的Alpha框架

- 社交媒体图像中的抗议与暴力检测模型实现

- Android Support Library v4 安装与配置教程

- Android中文API合集——中文翻译组出品

- 暗组计算机远程管理软件V1.0 - 远程控制与管理工具

- NVIDIA GPU深度学习环境搭建全攻略

- 丰富的人物行走动画素材库

- 高效汉字拼音转换工具TinyPinYin_v2.0.3发布