理解Hadoop MapReduce:执行过程与编程模型

需积分: 10 110 浏览量

更新于2024-07-31

收藏 614KB PDF 举报

"这份PDF主要介绍了MapReduce的概念以及其在处理天气数据示例中的应用,同时提到了MapReduce程序的编写,包括mapper和reducer的实现。"

MapReduce是Hadoop框架的核心组成部分,它是一种分布式计算模型,用于处理和生成大规模数据集。MapReduce的工作原理分为两个主要阶段:Map阶段和Reduce阶段。

1. Map阶段:

在这个阶段,原始数据被分割成多个小块(split),每个split由一个map任务处理。默认情况下,TextInputFormat将每个数据行视为一个记录,其key为行的偏移量,value为整行文本。在给定的例子中,map函数会解析每一行,提取出年份和温度信息,形成新的key-value对,例如(年份,温度)。这个阶段的输出是一系列中间key-value对,这些对会被排序并分组,以便后续的reduce阶段处理。

2. Reduce阶段:

这个阶段的主要任务是对map阶段产生的中间key-value对进行聚合操作。相同的key会被分到同一个reduce任务,所有对应的value会被收集到一个列表中。在天气数据的例子中,reduce函数会接收这些年份和温度的列表,找出每一年的最高温度,并输出(年份,最高温度)的key-value对。

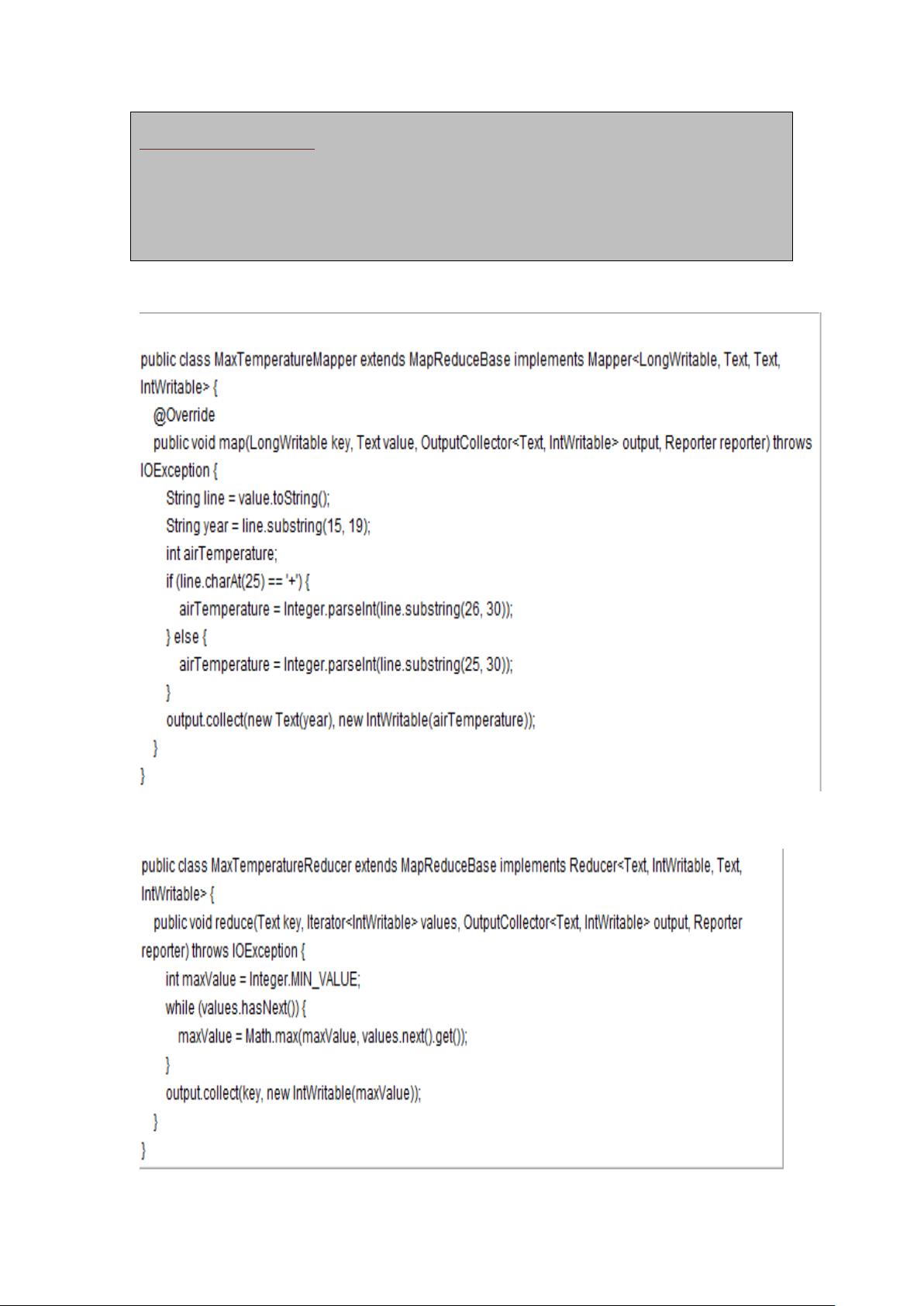

3. 编写MapReduce程序:

要编写MapReduce程序,你需要实现两个关键函数:`map()`和`reduce()`。`map()`函数负责处理输入数据并生成中间key-value对,而`reduce()`函数则聚合这些中间结果并生成最终输出。在编程时,通常会使用Hadoop提供的特定类,如`Reporter`来报告进度,`OutputCollector`用于收集和发送输出数据。

对于上述天气数据处理,mapper的`map()`函数会解析输入行并创建key-value对,而reducer的`reduce()`函数则会找出每组中的最大温度。这两个函数的实现通常会用到Hadoop提供的基本数据类型,如`LongWritable`、`IntWritable`和`Text`,它们可以方便地进行序列化和反序列化,适应分布式环境的数据交换。

4. 运行MapReduce作业:

要运行自定义的Mapper和Reducer,你需要将它们包含在一个MapReduce作业中,并提交给Hadoop集群执行。作业会自动管理任务调度、数据分发和错误恢复等复杂过程。

MapReduce提供了一种灵活且可扩展的方式来处理大数据,使得开发者能够专注于业务逻辑,而不是底层的分布式系统细节。通过MapReduce,可以高效地处理PB级别的数据,广泛应用于数据分析、日志处理、机器学习等多个领域。

2021-10-14 上传

2023-03-03 上传

2023-06-10 上传

2024-03-08 上传

2023-12-26 上传

2023-04-04 上传

2023-06-08 上传

2023-04-04 上传

2023-06-09 上传

yueyinger131

- 粉丝: 0

- 资源: 2

最新资源

- Postman安装与功能详解:适用于API测试与HTTP请求

- Dart打造简易Web服务器教程:simple-server-dart

- FFmpeg 4.4 快速搭建与环境变量配置教程

- 牛顿井在围棋中的应用:利用牛顿多项式求根技术

- SpringBoot结合MySQL实现MQTT消息持久化教程

- C语言实现水仙花数输出方法详解

- Avatar_Utils库1.0.10版本发布,Python开发者必备工具

- Python爬虫实现漫画榜单数据处理与可视化分析

- 解压缩教材程序文件的正确方法

- 快速搭建Spring Boot Web项目实战指南

- Avatar Utils 1.8.1 工具包的安装与使用指南

- GatewayWorker扩展包压缩文件的下载与使用指南

- 实现饮食目标的开源Visual Basic编码程序

- 打造个性化O'RLY动物封面生成器

- Avatar_Utils库打包文件安装与使用指南

- Python端口扫描工具的设计与实现要点解析