支持向量机SVM详解:从入门到精通

"SVM原理入门式介绍"

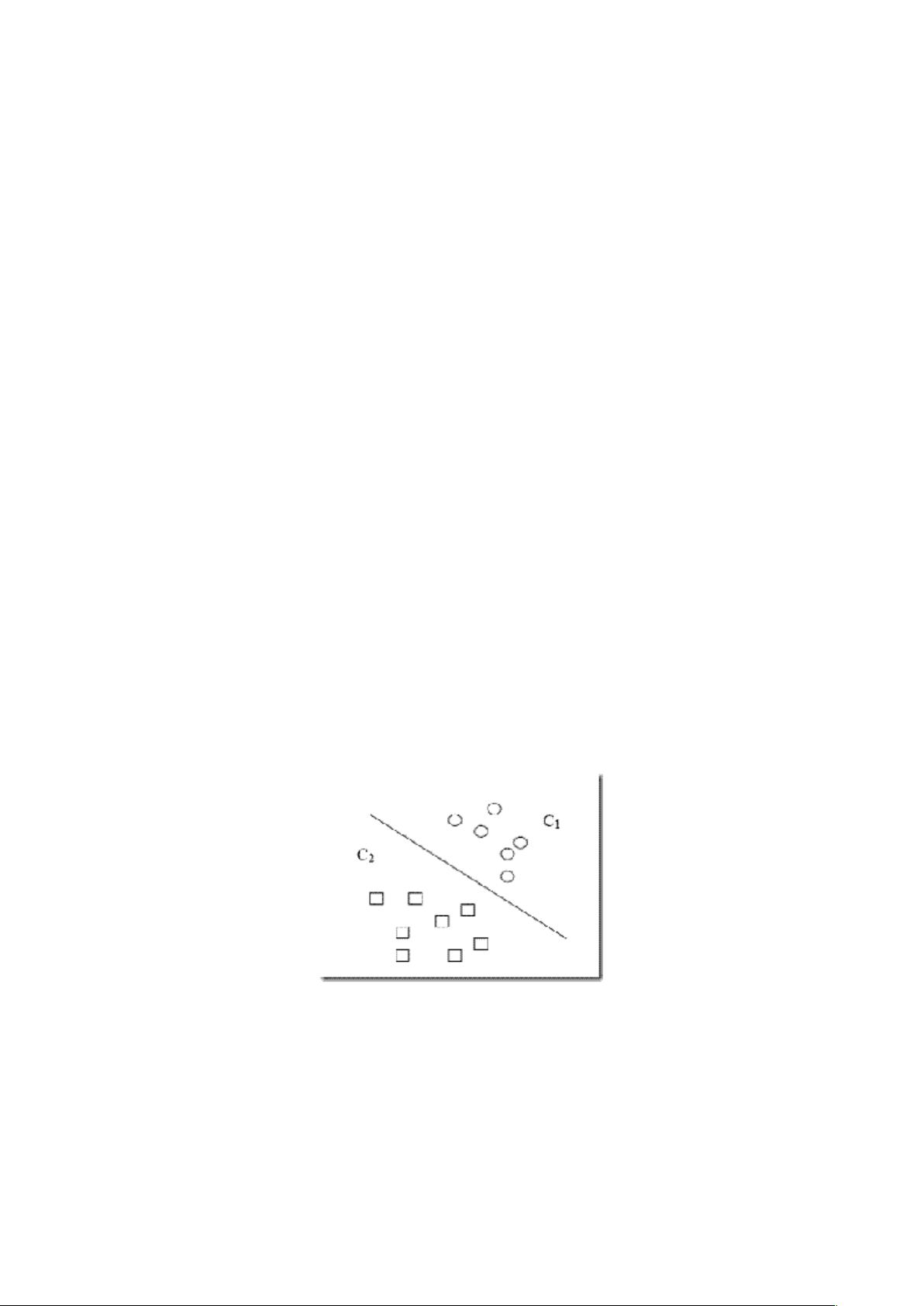

支持向量机(SVM)是一种监督学习算法,主要用于分类和回归分析。它的核心思想是找到一个最优的决策边界,使得两类样本点被最大程度地分离,同时保持边界尽可能远离最近的样本点,这些最近的样本点被称为支持向量。

1. SVM的基本概念

- 支持向量:在SVM中,最靠近分类边界的样本点被称为支持向量。它们对于构建分类超平面至关重要,因为它们定义了最大间隔。

- 分类超平面:在二维空间中表现为直线,在高维空间中表现为超平面,用来划分不同类别的数据点。

- 最大间隔:SVM的目标是找到一个最大化间隔(margin)的超平面,间隔是分类超平面与最近的支持向量之间的距离。

2. 核函数

- SVM的非线性处理能力来源于核函数。通过核函数,我们可以将原本在低维空间中的非线性可分问题转换到高维空间,使其变得线性可分。常见的核函数有线性核、多项式核、高斯核(RBF)等。

3. 维数灾难与SVM

- 高维数据通常会导致"维数灾难",使得许多算法性能下降。然而,SVM通过核函数巧妙地处理了这个问题,即使在非常高维的空间中,也能有效地找到分类超平面。

4. VC维理论

- VC维(Vapnik-Chervonenkis维度)是衡量模型复杂度的一个指标。它表示模型能完美拟合的数据集的最大规模。VC维越高,模型的复杂度越大,过拟合的风险也越高。

5. 结构风险最小化

- 结构风险最小化是SVM优化的目标,它综合考虑了经验风险(训练集上的误差)和置信风险(泛化误差)。通过控制模型复杂度,SVM试图找到一个在训练集上表现良好且泛化能力强的模型。

6. C参数与软间隔

- 在实际应用中,可能存在一些样本点不能严格满足最大间隔原则,这时引入了C参数,允许一定数量的误分类(即软间隔)。C值越大,对误分类的容忍度越小,模型越趋向于追求最大间隔;C值越小,模型倾向于包容更多的误分类,提高泛化能力。

7. 多分类与一对多策略

- 对于多分类问题,SVM通常采用一对多(one-vs-one 或 one-vs-rest)策略,即构建多个二分类器,每个分类器负责区分一类与其他类。

SVM以其强大的泛化能力和对小样本、非线性、高维数据的良好处理能力,在文本分类、图像识别、生物信息学等领域有着广泛应用。理解并掌握SVM的基本原理和操作方法,对于解决实际问题具有重要的价值。

104 浏览量

155 浏览量

2023-04-26 上传

2023-06-12 上传

2023-07-28 上传

2023-07-29 上传

2023-05-10 上传

2023-10-22 上传

2023-07-09 上传

WTK-CV

- 粉丝: 47

- 资源: 24

最新资源

- 深入理解23种设计模式

- 制作与调试:声控开关电路详解

- 腾讯2008年软件开发笔试题解析

- WebService开发指南:从入门到精通

- 栈数据结构实现的密码设置算法

- 提升逻辑与英语能力:揭秘IBM笔试核心词汇及题型

- SOPC技术探索:理论与实践

- 计算图中节点介数中心性的函数

- 电子元器件详解:电阻、电容、电感与传感器

- MIT经典:统计自然语言处理基础

- CMD命令大全详解与实用指南

- 数据结构复习重点:逻辑结构与存储结构

- ACM算法必读书籍推荐:权威指南与实战解析

- Ubuntu命令行与终端:从Shell到rxvt-unicode

- 深入理解VC_MFC编程:窗口、类、消息处理与绘图

- AT89S52单片机实现的温湿度智能检测与控制系统