深度强化学习解析:A3C算法与核心概念

需积分: 36 23 浏览量

更新于2024-07-19

2

收藏 2.64MB PDF 举报

"本文将深入探讨深度强化学习(DRL)中的A3C算法,以及相关的强化学习概念,包括value-based方法、policy-based方法、off-policy与on-policy的区别,以及离散动作域与连续动作域的差异。"

深度强化学习(DRL)是一种结合了深度学习和强化学习的技术,它在解决复杂决策问题时展现出强大的能力。A3C(Asynchronous Advantage Actor-Critic)算法是DRL领域中的一种重要方法,由杨少康提出的框架能够通过多种强化学习算法训练神经网络。

1. Value-based VS Policy-based 方法:

- Value-based方法如Q-learning和SARSA,主要目标是通过估计状态值函数(state-value function)或动作值函数(action-value function)来选择最优行动。Q-learning通过最大化未来奖励的期望来更新Q值,但它是off-policy的,允许使用非当前策略的经验进行更新,这可能导致快速收敛但也增加不稳定性。

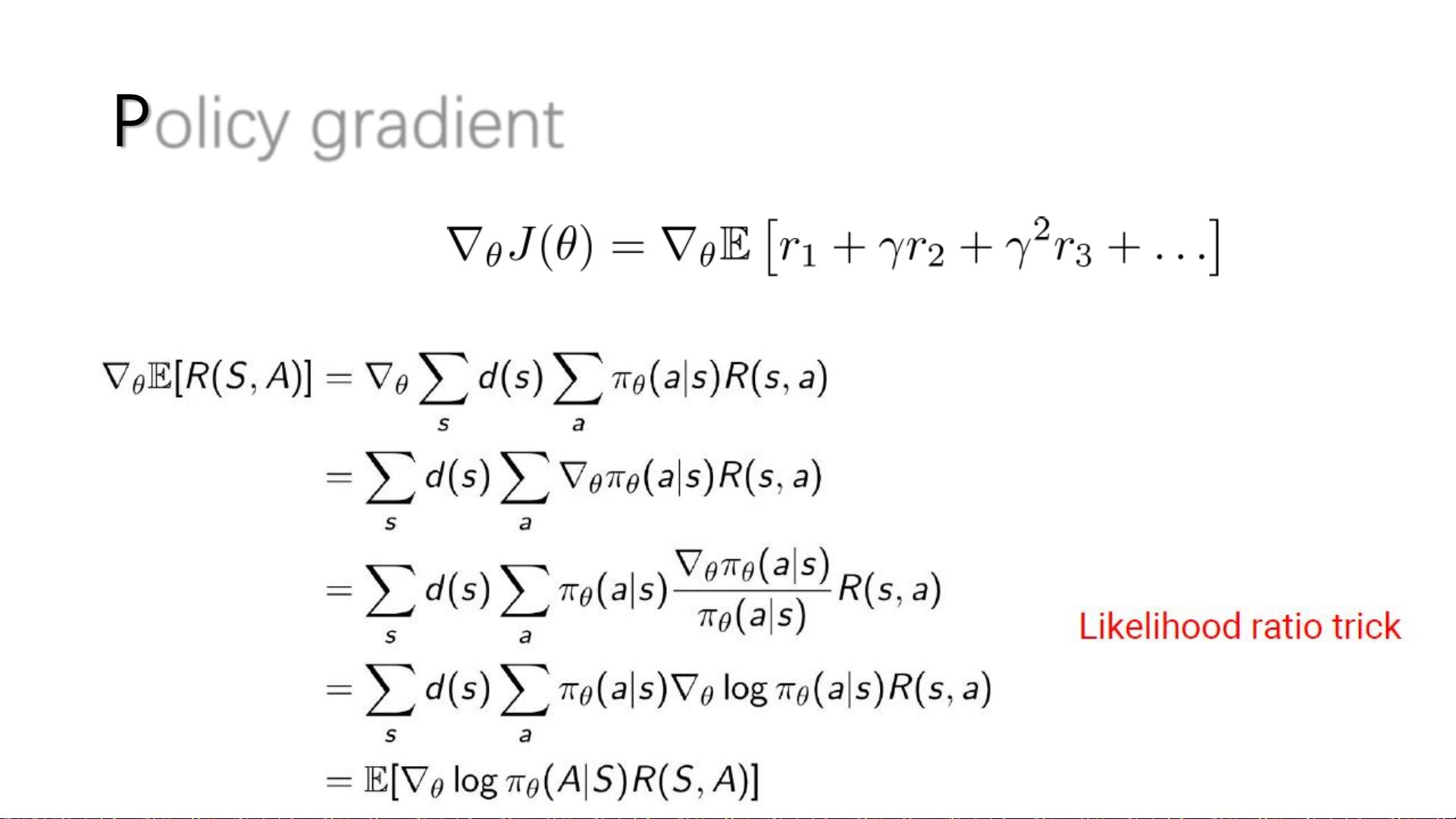

- Policy-based方法,例如Policy Gradients,直接优化策略函数(policy function),即直接调整策略以最大化期望回报。A3C就是一种policy-based方法,它使用策略梯度来更新策略,更直接地影响行动选择。

2. Model-based VS Model-free 方法:

- Model-based强化学习知道环境的动态模型(MDP的<S, A, R, P, γ>),能预测结果并计划长期策略。然而,实际环境中模型通常难以获取,因此这种方法应用有限。

- Model-free方法不依赖于环境模型,而是通过与环境的交互来学习。它们包括Q-learning和A3C等,通过试错学习和经验回放缓冲区来改进策略。

3. Off-policy VS On-policy 方法:

- On-policy方法如SARSA,当前策略用于生成数据并更新策略。这种方法较为保守,但确保了策略的稳定更新。

- Off-policy方法如Q-learning,允许使用非当前策略的数据进行学习,这可以更有效地利用经验,但可能引入样本偏差。

4. Discrete VS Continuous Actions:

- DQN(Deep Q-Network)适用于离散动作空间,如Atari游戏,输出的是离散的动作选择。

- 然而,对于连续动作空间(如机器人控制),DQN就显得力不从心。在这种情况下,通常需要其他算法,如DDPG(Deep Deterministic Policy Gradient)或SAC(Soft Actor-Critic),它们能够处理连续动作输出。

A3C算法的异步特性是其独特之处,它使用多个并行的模拟环境来更新策略,这加速了学习过程,并且通过异步更新减少了过拟合的风险。此外,A3C结合了Actor-Critic方法,即同时优化策略和价值函数,从而在学习过程中提供稳定的梯度信号。

总结起来,理解A3C算法需要掌握强化学习的基本概念,包括value-based与policy-based方法的区别,模型的存在与否,以及处理离散和连续动作的能力。A3C通过异步更新和Actor-Critic架构,实现了高效且稳定的强化学习。

2013-01-24 上传

2022-07-15 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-08-25 上传

jack_ya_ng

- 粉丝: 11

- 资源: 8

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能