TensorRT环境配置与编程实战指南

需积分: 5 114 浏览量

更新于2024-06-22

收藏 842KB PDF 举报

"该文档详细介绍了TensorRT的环境配置与编程实例,主要涵盖了TensorRT的回顾、CUDA的安装、CUDNN的安装以及如何在Ubuntu 16.04上配置TensorRT环境。"

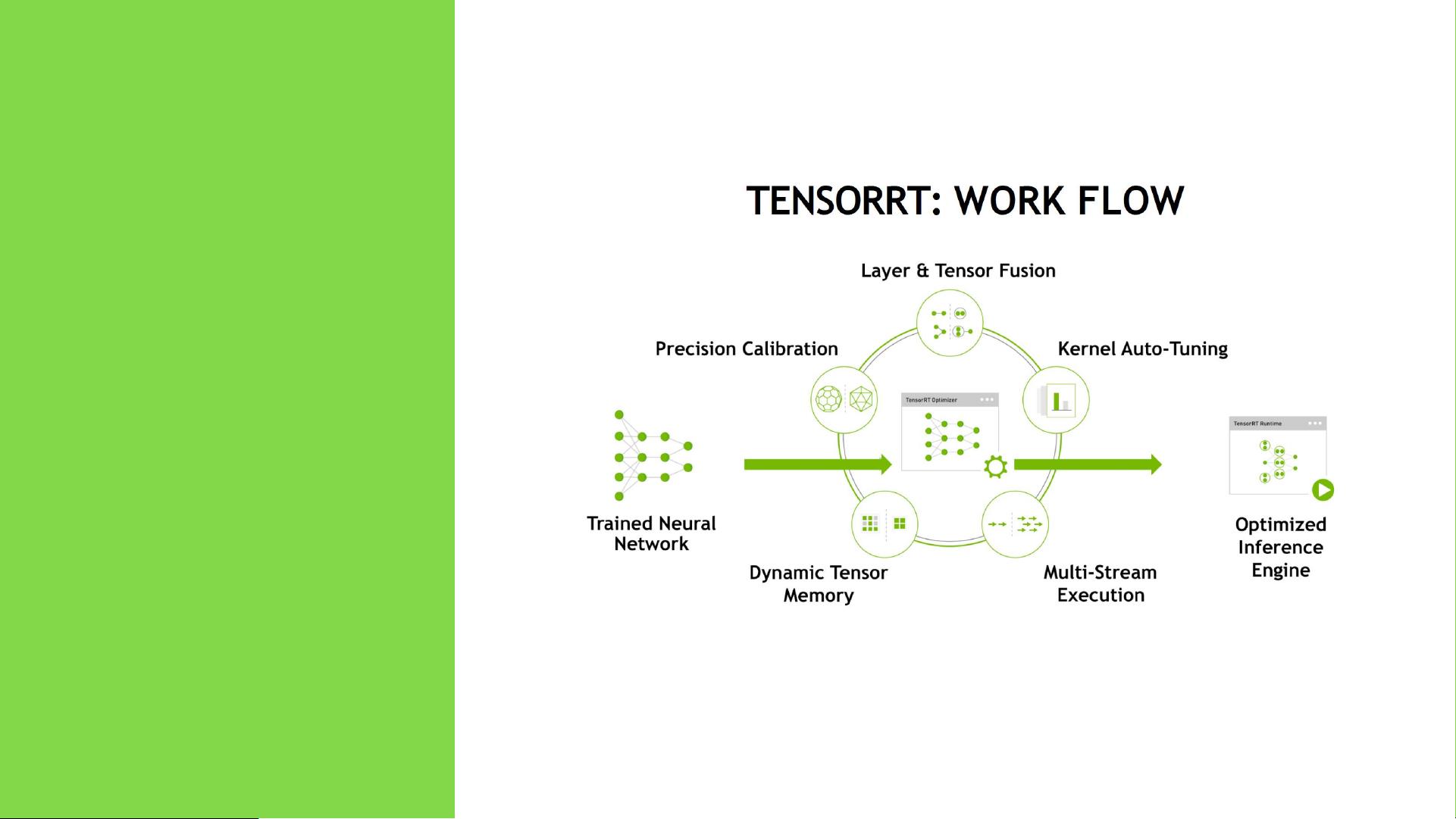

TensorRT是由NVIDIA开发的一款高性能深度学习推理(Inference)优化库,它用于构建和部署高效的深度学习模型。TensorRT通过分析和优化网络结构,生成针对NVIDIA GPU的高度优化的运行时执行引擎,从而提供低延迟和高吞吐量的推理服务。

在TensorRT的环境配置中,首先需要安装CUDA。CUDA是NVIDIA提供的用于GPU加速计算的软件平台,它包含了驱动程序、运行时库和开发工具。对于TensorRT,通常需要与之兼容的CUDA版本,此文档中推荐的是CUDA 9.0。安装CUDA的步骤包括下载deb安装包、安装包、更新环境变量,并确保`PATH`和`LD_LIBRARY_PATH`包含CUDA的bin和lib路径。

接着,安装CUDNN(CUDA Deep Neural Network library)是必要的,因为它是CUDA上的一个深度学习库,用于加速深度神经网络的训练和推理。CUDNN提供了对卷积、池化、全连接等操作的优化实现。安装CUDNN需要下载对应CUDA版本的deb包,然后使用dpkg命令进行安装。

完成CUDA和CUDNN的安装后,环境配置还需要确保所有环境变量设置正确。这通常包括将CUDA和CUDNN的路径添加到系统路径中,以便在任何地方都能访问这些库。

在TensorRT的编程模型中,开发者可以使用TensorRT API来构建和优化模型。API允许用户构建计算图,定义网络层,加载预训练模型,以及进行推理。TensorRT支持多种框架,如TensorFlow、Caffe等,可以方便地将这些框架中的模型转换为TensorRT可以执行的形式,以提高推理性能。

在实际的TensorRT实例展示中,可能包括了如何加载模型、分配内存、构建执行上下文、执行推理以及解析结果等步骤。这有助于开发者理解如何在自己的应用中有效地利用TensorRT。

TensorRT通过高效地利用GPU硬件,为深度学习模型的推理阶段提供了显著的性能提升,而这份文档详细指导了如何在Ubuntu系统上配置和使用TensorRT,对于想要进行深度学习推理优化的开发者来说,是非常有价值的参考资料。

2021-09-21 上传

2020-04-04 上传

2021-10-11 上传

2024-05-24 上传

2021-09-24 上传

2021-08-18 上传

2022-03-18 上传

2022-02-25 上传

weixin_44079197

- 粉丝: 1729

- 资源: 598

最新资源

- Accuinsight-1.0.21-py2.py3-none-any.whl.zip

- 基于PN序列的信道估计和OFDM中Reed Solomon码的实现:PN_sequence_based_channel_estimation_and_implementation_of_Reed_Solomon_code_in_OFDM-matlab开发

- jackson-zhipeng-chang:我的个人资料库

- Proyecto_Adsi

- circleci-demo-javascript-react-app

- 模糊控制程序2.rar

- notion:概念小部件

- Access-Form-Creator:该项目的目的是使不了解访问或vba的人能够访问数据库,该数据库仅包含允许他们根据提供的表格中填写的信息来创建表格,报告,链接表所需的内容给他们。 项目完成后,他们应该能够选择是隐藏还是删除用于创建所需后端的所有内容

- translator.github.io

- testhexo

- 基于PHP的最新仿米兰站微购(购物导航)php版源码.zip

- galicia:加利西亚银行的实际考试

- React游戏

- ansible-nginx:在类似Debian的系统中设置(最新版本的)NGINX的角色

- 参考资料-2M.02.06.05 AS-IS现状流程图绘制工具包.zip

- coolguy4ever.github.io:这是我的网站的仓库