Eclipse中搭建Spark开发环境步骤详解

需积分: 0 18 浏览量

更新于2024-09-05

收藏 1.11MB DOC 举报

"Eclipse开发Spark项目环境搭建文档"

在本文档中,黄sir详细介绍了如何在Eclipse中配置Spark开发环境,以便初学者和学生能够顺利进行Spark项目的开发。以下是该过程的详细步骤:

1. **软件工具准备**:首先,你需要确保已经准备了Eclipse IDE和Spark的相关软件。这通常包括Eclipse的安装文件以及Spark的二进制包。

2. **Eclipse在Linux上的部署**:将Eclipse解压到Linux系统(例如CentOS 6.5)的适当目录,并启动Eclipse。在启动时,可能需要根据你的系统配置进行特定的设置。

3. **创建Spark项目**:

- **新建Scala项目**:在Eclipse中,选择新建一个Scala项目。这是通过选择相应的菜单项并输入项目名称来完成的。

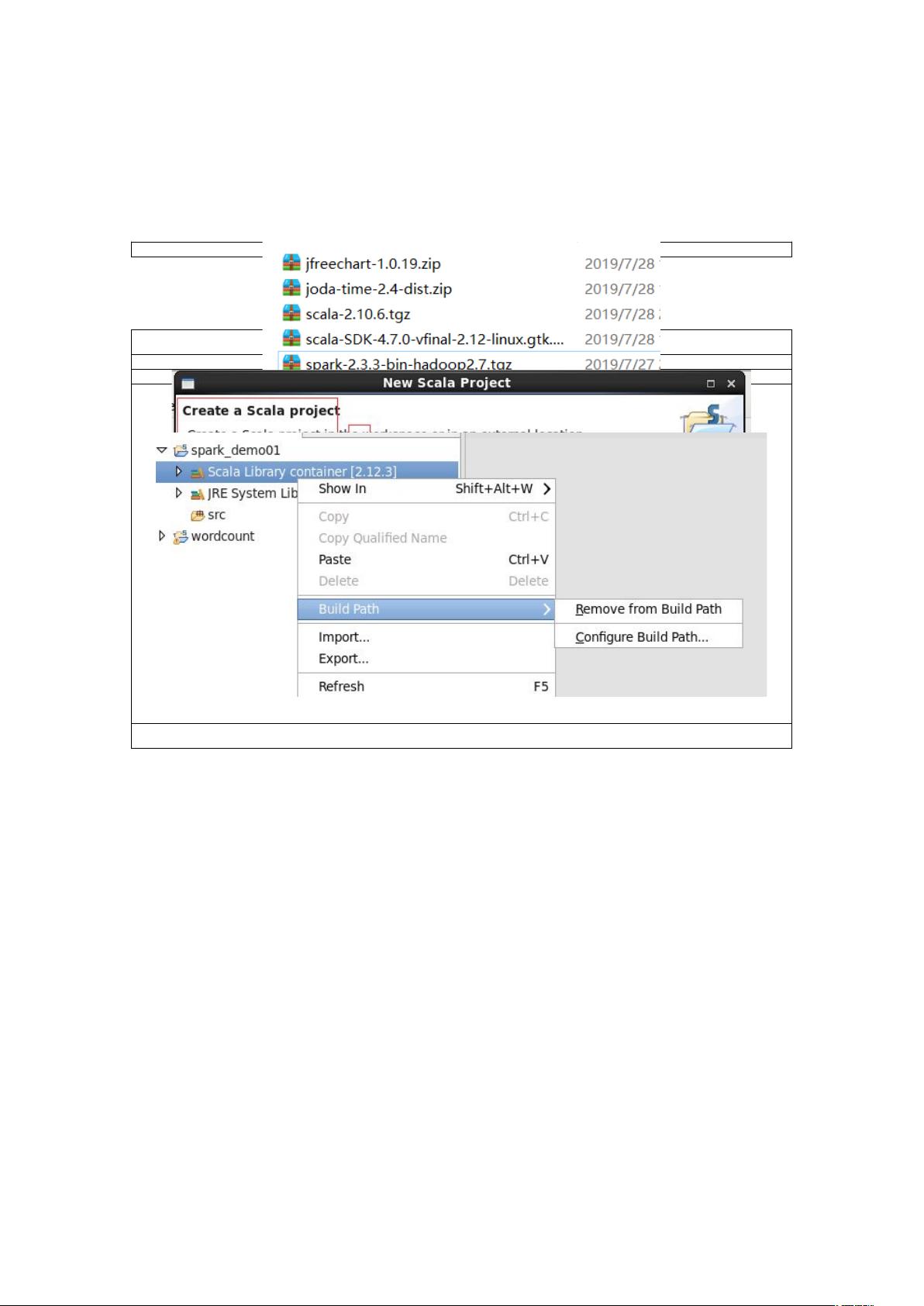

- **管理项目依赖**:接着,你需要调整项目依赖。这涉及到删除已有的项目依赖,然后重新添加你需要的Spark相关的jar包。这有助于避免jar包冲突问题。

- **添加Spark库**:将Spark解压后的库文件添加到项目中。这通常包括Spark的核心库和其他必要的库文件。

4. **创建项目类**:

- **创建包**:在项目中创建一个新的包,这有助于组织代码结构。

- **新建Scala类**:在新创建的包内,创建一个Scala类。这个类是Spark程序的主要入口点。

- **编写代码**:在类中编写Spark WordCount示例代码。这个简单的程序用于统计文本文件中的单词数量。它包含了初始化SparkContext,读取文件,创建RDD,执行转换和操作,以及保存结果到HDFS的基本步骤。

- **主方法**:在类中定义一个`main`方法,这是程序的入口点。在`main`方法中,调用SparkContext的相关方法来执行任务。

5. **运行前的设置**:在运行程序之前,需要确保正确设置了项目的构建路径,确保所有必要的jar包都已添加,同时移除了可能导致冲突的其他jar包。

这个文档不仅提供了详细的步骤,还配以图片,使得初学者能够更直观地理解每个步骤。通过遵循这些步骤,你可以成功地在Eclipse中建立一个有效的Spark开发环境,从而开始你的Spark编程之旅。这个环境对于学习和实践Spark的分布式计算功能非常有用,尤其适合那些刚开始接触Spark和Scala的开发者。

点击了解资源详情

169 浏览量

135 浏览量

177 浏览量

737 浏览量

261 浏览量

2022-03-08 上传

102 浏览量

397 浏览量

黄_sir

- 粉丝: 0

- 资源: 11

最新资源

- debian-cdimage

- Sec_Bot:用Discord.py编写的简单的以网络为重点的Discord机器人

- 算法题的提交答案,并随着每周的周赛等新增题目更新。编程语言以 C++ 为主

- Nanopool Calculator Extension-crx插件

- dubbostudy.zip

- 电信设备-一种基于地理信息技术的应急知识库维护系统及实现方法.zip

- 平差代码MATLAB小数点精度保留和课本一样

- 微信小程序Demo:技术新闻

- fuzzy-archer:Weewx的图形仪表和历史记录表生成器

- 胰腺癌

- 《Python编程:从入门到实践》第1-11章的编程题的代码。.zip

- Intercom Gmail Integration-crx插件

- 数字产业:2019年度网络安全威胁情报分析

- Basic-Bannking-System:Sparks Foundation Web开发实习项目

- eetop.cn_sunburst.rar

- LAoE-开源