深度学习第15章:表示学习与贪心预训练详解

需积分: 10 194 浏览量

更新于2024-07-19

1

收藏 2.2MB PPTX 举报

第十五章“表示学习”是深度学习领域的重要组成部分,主要探讨如何有效地组织和转换输入数据,以便于机器理解和处理。章节的核心内容包括信息表示的效率与任务难度的关系,以及无监督预训练方法如贪心逐层学习在深度学习中的应用。

在表示学习中,信息任务的完成难易程度直接取决于所使用的表示形式。例如,有序链表的插入操作时间复杂度为O(n),而红黑树可以提升到O(lgn),这体现了高效表示的重要性。一个好的表示能够简化后续任务,如使用堆叠自编码器(Stacked Autoencoders),它通过多层自动编码器结构,每一层的输出作为下一层的输入,目标是学习到一种潜在表示,使得分类或其他任务变得更加容易。

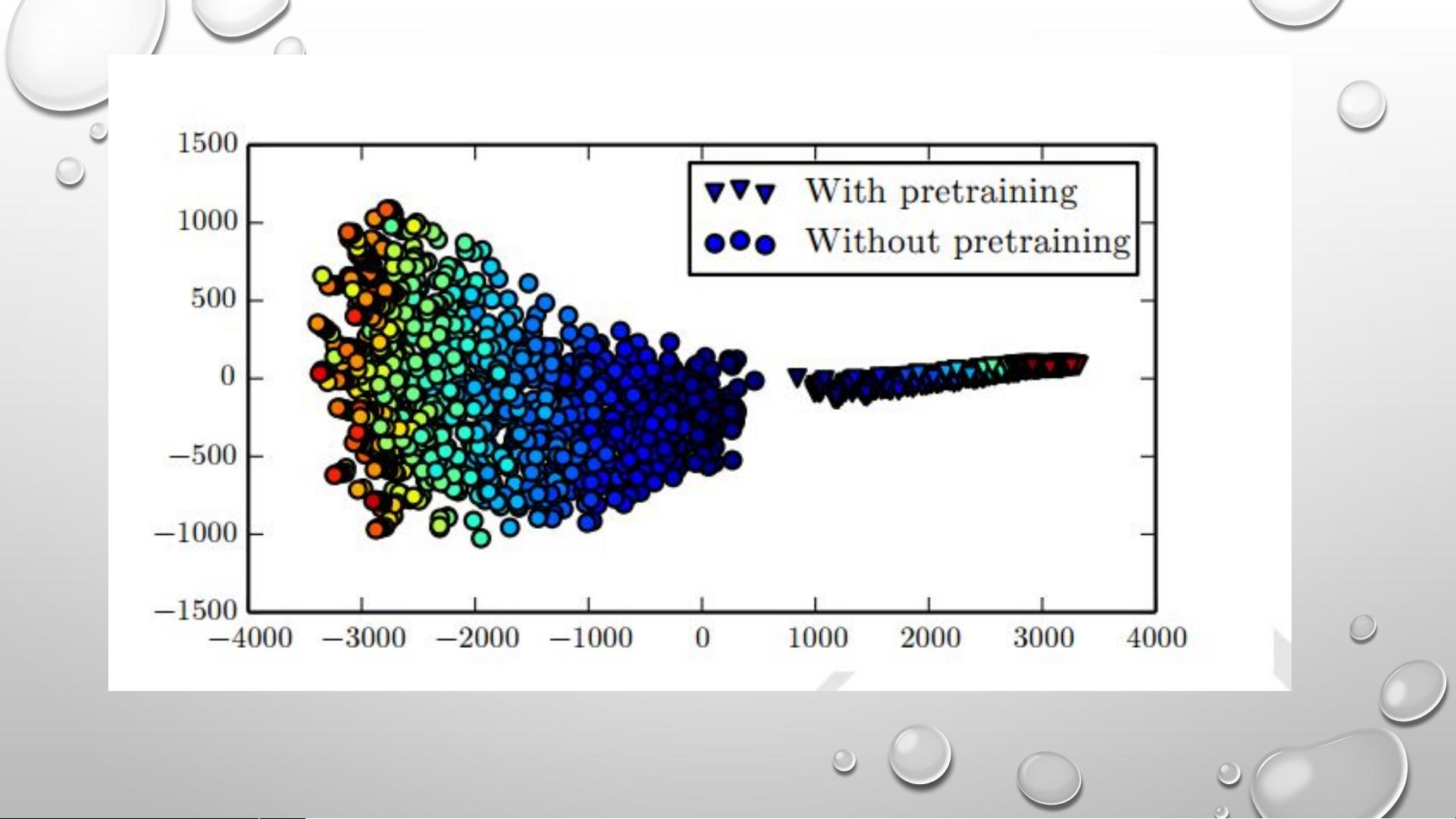

无监督的贪心逐层预训练是这种方法的关键步骤,如单层表示学习算法,如受限玻尔兹曼机(RBM)、单层自编码器或稀疏编码模型。这个过程通常分为两个阶段:首先通过无监督学习获取底层表示,然后微调这些表示并连接分类器进行监督学习。尽管这种方法在许多分类任务中能显著降低测试误差,但也有局限性,如可能导致无监督训练带来的负面影响,特别是当预训练不恰当时。

无监督预训练的思想主要包括两方面:一是通过深度神经网络的初始化参数,优化模型训练性能;二是利用无监督学习学习到的特征对监督学习任务有益,如在汽车和摩托车图像分类中,轮子的共享特征可以被学习并用于监督学习。词向量(Word Embeddings)是一个重要的无监督学习表示,它们通过学习词之间的向量距离来捕捉语义相似性,比如one-hot编码相比,词向量更加直观和有效。

然而,这种方法也存在缺点。首先,预训练和微调是两个独立的阶段,需要分别调整超参数,可能导致正则化强度的控制困难,因为调整效果要在第二阶段才能看到,且超参数调整的延迟可能会影响最终性能。此外,无监督预训练的灵活性较差,特别是在缺乏足够标注数据的情况下,使用监督学习的深度学习技术可能会更为有效。

总结来说,第十五章“表示学习”在深度学习中扮演着桥梁角色,通过优化表示,提升模型的泛化能力,但同时也需要注意无监督学习方法的适用性和潜在挑战。理解并掌握这一概念对于深入理解深度学习的实践至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-10-07 上传

2021-10-09 上传

2021-10-10 上传

2021-10-05 上传

2021-10-02 上传

2022-11-14 上传

hyk_1996

- 粉丝: 118

- 资源: 7

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率