SVM算法解析:VC维与文本分类的强大工具

需积分: 0 125 浏览量

更新于2024-06-30

收藏 295KB DOCX 举报

SVM(Support Vector Machine,支持向量机)算法是一种基于统计学习理论的强大工具,最初由Cortes和Vapnik在1995年提出。它在处理小样本、非线性和高维数据时表现出卓越性能,特别适用于文本分类等场景,因为它不受样本维度限制,即使在上万维的高维空间中也能保持高效。

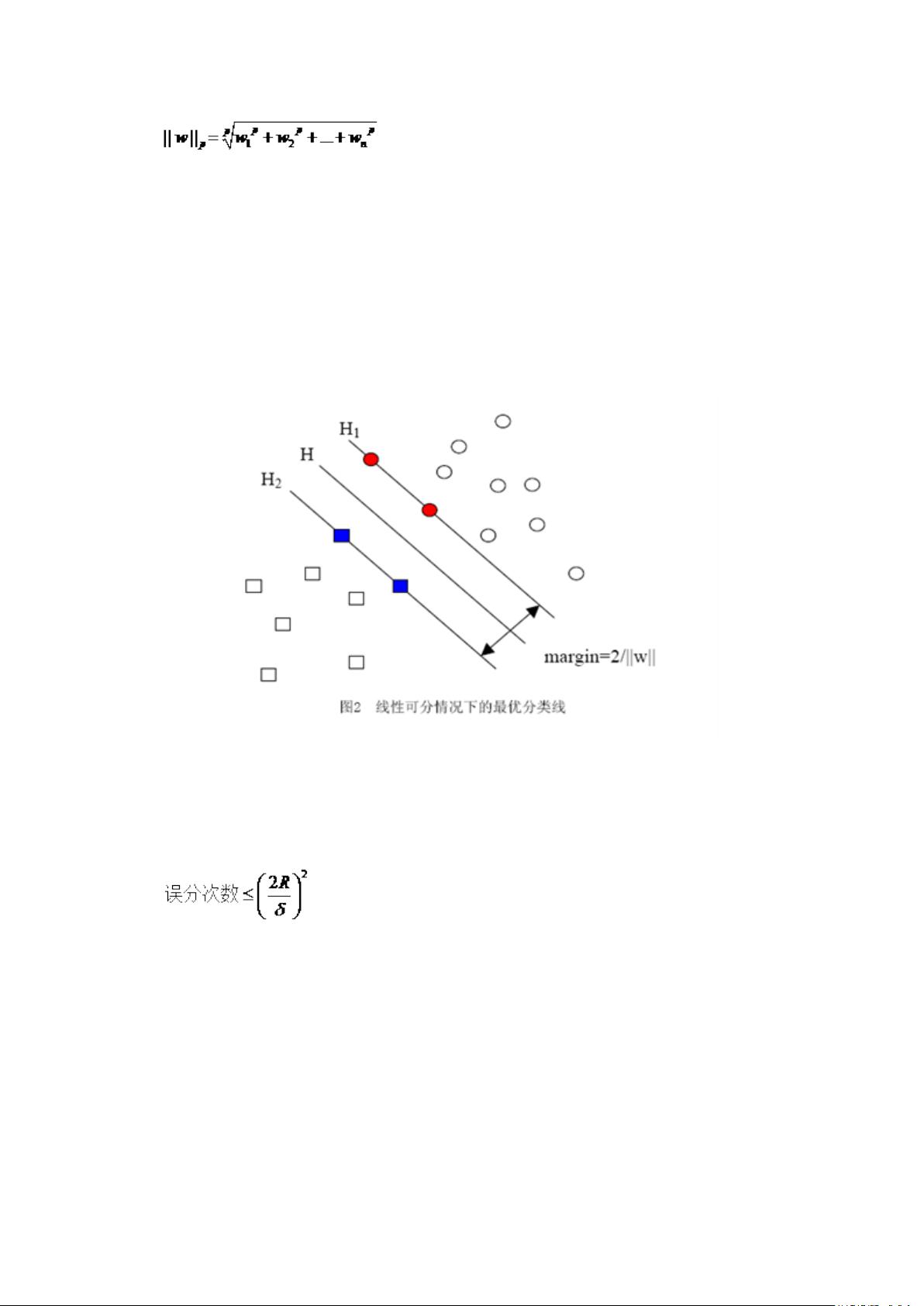

SVM的核心理念是结合VC维理论和结构风险最小化原理。VC维(Vapnik-Chervonenkis Dimension)是一个概念,用于衡量函数类的复杂性,数值越高代表问题越复杂。SVM通过优化模型复杂度和泛化能力之间的平衡,确保在有限的训练数据下,模型既能准确地学习当前样本,又能在未知数据上的表现良好,从而提高其推广能力。

Vapnik的《Statistical Learning Theory》强调了统计机器学习与传统机器学习的区别,前者强调精确的学习效果预测和样本需求分析,而后者更像是经验主义,缺乏理论指导。在SVM中,这种理论基础体现在其对模型复杂度的控制上,避免了过拟合(过度依赖训练数据导致在新数据上表现不佳)和欠拟合(模型过于简单,无法捕捉数据中的复杂关系)的问题。

结构风险最小化(Structural Risk Minimization,SRM)实质上是寻找最佳模型,它平衡了训练误差(模型在训练数据上的表现)和泛化误差(模型在未见过的数据上的表现),试图找到一个既简单又能有效处理未知数据的模型。在SVM中,通过核函数的使用,即使数据在原始空间难以线性分割,也能在特征映射的更高维空间中找到一个有效的决策边界,实现非线性分类。

总结来说,SVM算法的关键在于其对问题复杂性的精确控制,以及利用核函数处理高维数据的能力。它通过结构风险最小化策略,保证模型具有良好的泛化性能,使其在处理各种复杂任务时展现出独特的价值。在实际应用中,如文本分类中,SVM的这些特性使得它成为不可或缺的工具之一。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-09-30 上传

106 浏览量

2022-09-24 上传

277 浏览量

2023-04-21 上传

2011-09-20 上传

艾斯·歪

- 粉丝: 42

- 资源: 342

最新资源

- Elasticsearch核心改进:实现Translog与索引线程分离

- 分享个人Vim与Git配置文件管理经验

- 文本动画新体验:textillate插件功能介绍

- Python图像处理库Pillow 2.5.2版本发布

- DeepClassifier:简化文本分类任务的深度学习库

- Java领域恩舒技术深度解析

- 渲染jquery-mentions的markdown-it-jquery-mention插件

- CompbuildREDUX:探索Minecraft的现实主义纹理包

- Nest框架的入门教程与部署指南

- Slack黑暗主题脚本教程:简易安装指南

- JavaScript开发进阶:探索develop-it-master项目

- SafeStbImageSharp:提升安全性与代码重构的图像处理库

- Python图像处理库Pillow 2.5.0版本发布

- mytest仓库功能测试与HTML实践

- MATLAB与Python对比分析——cw-09-jareod源代码探究

- KeyGenerator工具:自动化部署节点密钥生成