Java实现的Web网络爬虫设计与实战优化

需积分: 9 90 浏览量

更新于2024-09-11

收藏 381KB PDF 举报

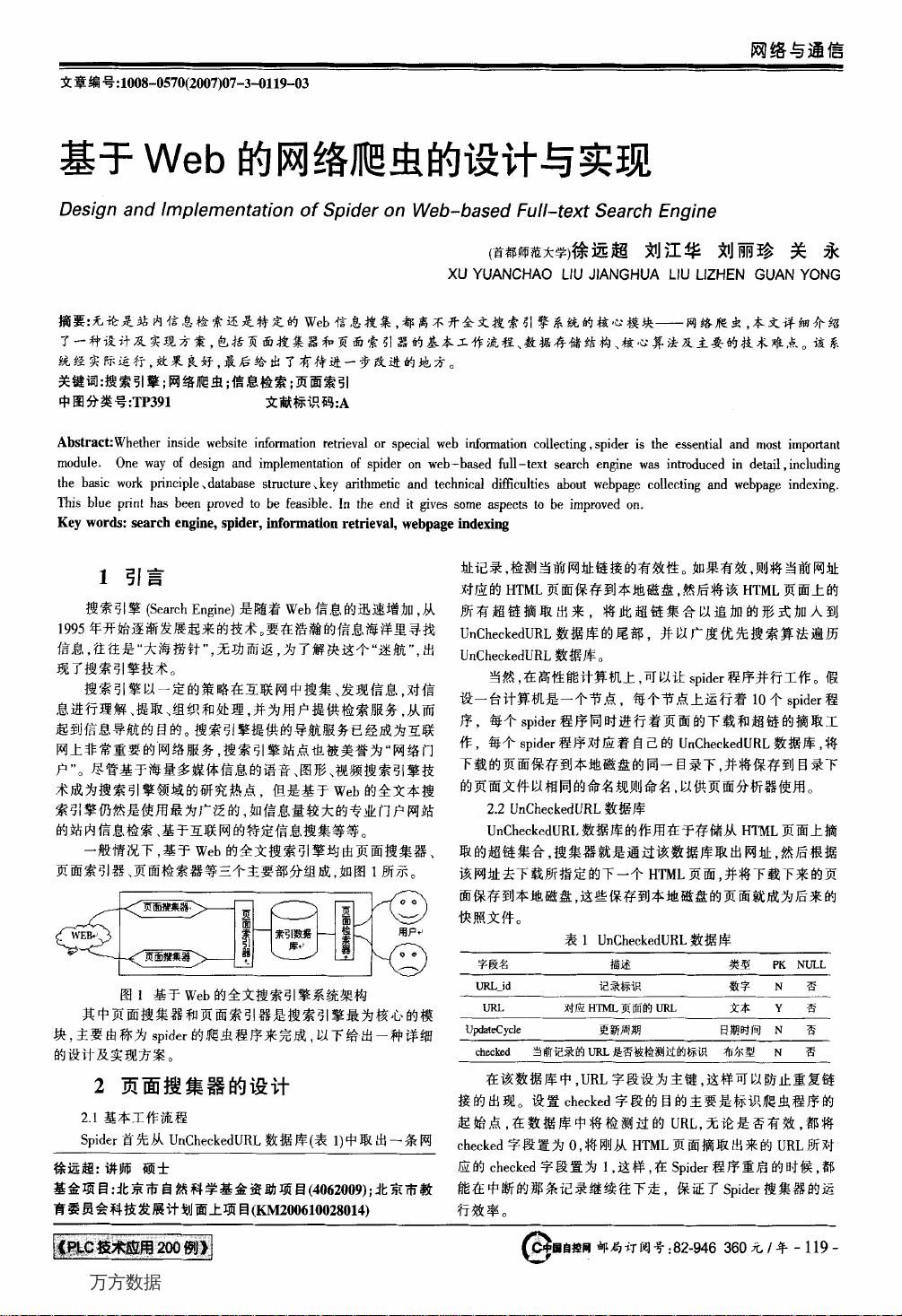

本文主要探讨了"基于Web的网络爬虫的设计与实现"这一主题,着重于利用Java语言构建的全文搜索引擎系统中的关键模块——网络爬虫。网络爬虫在网络与通信技术的支持下,对于站内信息检索和特定Web信息的搜集起着至关重要的作用。文章首先介绍了网络爬虫在搜索引擎中的核心地位,它是搜索引擎成功的关键环节。

作者详细阐述了网络爬虫的工作流程,包括页面搜集器如何通过URL链接发现新的网页,然后下载并解析网页内容。在这个过程中,页面搜集器通常会遵循一定的策略,如深度优先或广度优先搜索,以有效地遍历互联网上的信息。此外,文章还涉及到了页面索引器的工作,它负责对搜集到的页面内容进行处理,提取关键信息,以便后续的搜索请求能够快速定位到相关结果。

数据存储结构是网络爬虫设计中的另一个重要考虑因素,高效的数据库设计能确保数据的存储和检索效率。常见的数据结构可能包括哈希表、倒排索引等,它们能够帮助系统快速定位到相关的网页片段。核心算法方面,抓取策略、链接分析和重复过滤等都是需要精心设计的部分,以避免重复抓取、提高抓取效率,并确保信息的多样性。

然而,网络爬虫的设计与实现并非易事,它面临着技术挑战,如动态网页抓取、反爬虫机制的应对、网页结构的复杂性以及数据安全等问题。为了克服这些难题,文章提到了可能采用的技术手段,如使用代理IP、处理JavaScript渲染、以及采用动态网页解析库如Jsoup或Scrapy。

文章最后部分总结了实际运行中该网络爬虫系统的性能表现,尽管效果良好,但仍存在需要进一步优化和改进的地方。这可能涉及到算法的优化、分布式爬虫架构的应用、或者更好的资源调度策略等。

关键词包括搜索引擎、网络爬虫、信息检索和页面索引,这些词汇准确地概括了论文的核心内容和研究领域。整个设计与实现过程既展示了技术的先进性,也体现了实际应用中的问题意识和持续改进的精神。

本文不仅提供了一种基于Web的网络爬虫设计和实现的具体方案,而且深入剖析了其中的关键技术和挑战,为其他研究人员和开发者提供了有价值的参考和实践指导。

2009-06-19 上传

2011-07-25 上传

2022-06-08 上传

2021-06-28 上传

2023-06-16 上传

2011-07-25 上传

2011-06-16 上传

2013-07-04 上传

haojwcaoling

- 粉丝: 0

- 资源: 2

最新资源

- 探索AVL树算法:以Faculdade Senac Porto Alegre实践为例

- 小学语文教学新工具:创新黑板设计解析

- Minecraft服务器管理新插件ServerForms发布

- MATLAB基因网络模型代码实现及开源分享

- 全方位技术项目源码合集:***报名系统

- Phalcon框架实战案例分析

- MATLAB与Python结合实现短期电力负荷预测的DAT300项目解析

- 市场营销教学专用查询装置设计方案

- 随身WiFi高通210 MS8909设备的Root引导文件破解攻略

- 实现服务器端级联:modella与leveldb适配器的应用

- Oracle Linux安装必备依赖包清单与步骤

- Shyer项目:寻找喜欢的聊天伙伴

- MEAN堆栈入门项目: postings-app

- 在线WPS办公功能全接触及应用示例

- 新型带储订盒订书机设计文档

- VB多媒体教学演示系统源代码及技术项目资源大全